2 Nachricht und Information

2 Nachricht und Information 2 Nachricht und Information

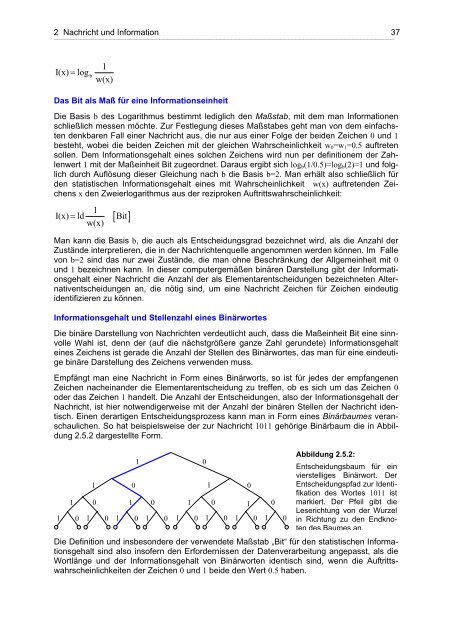

2 Nachricht und Information 37⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯I(x) = logb1w(x)Das Bit als Maß für eine InformationseinheitDie Basis b des Logarithmus bestimmt lediglich den Maßstab, mit dem man Informationenschließlich messen möchte. Zur Festlegung dieses Maßstabes geht man von dem einfachstendenkbaren Fall einer Nachricht aus, die nur aus einer Folge der beiden Zeichen 0 und 1besteht, wobei die beiden Zeichen mit der gleichen Wahrscheinlichkeit w 0 =w 1 =0.5 auftretensollen. Dem Informationsgehalt eines solchen Zeichens wird nun per definitionem der Zahlenwert1 mit der Maßeinheit Bit zugeordnet. Daraus ergibt sich log b (1/0.5)=log b (2)=1 und folglichdurch Auflösung dieser Gleichung nach b die Basis b=2. Man erhält also schließlich fürden statistischen Informationsgehalt eines mit Wahrscheinlichkeit w(x) auftretenden Zeichensx den Zweierlogarithmus aus der reziproken Auftrittswahrscheinlichkeit:I(x) = ld 1w(x)[ Bit]Man kann die Basis b, die auch als Entscheidungsgrad bezeichnet wird, als die Anzahl derZustände interpretieren, die in der Nachrichtenquelle angenommen werden können. Im Fallevon b=2 sind das nur zwei Zustände, die man ohne Beschränkung der Allgemeinheit mit 0und 1 bezeichnen kann. In dieser computergemäßen binären Darstellung gibt der Informationsgehalteiner Nachricht die Anzahl der als Elementarentscheidungen bezeichneten Alternativentscheidungenan, die nötig sind, um eine Nachricht Zeichen für Zeichen eindeutigidentifizieren zu können.Informationsgehalt und Stellenzahl eines BinärwortesDie binäre Darstellung von Nachrichten verdeutlicht auch, dass die Maßeinheit Bit eine sinnvolleWahl ist, denn der (auf die nächstgrößere ganze Zahl gerundete) Informationsgehalteines Zeichens ist gerade die Anzahl der Stellen des Binärwortes, das man für eine eindeutigebinäre Darstellung des Zeichens verwenden muss.Empfängt man eine Nachricht in Form eines Binärworts, so ist für jedes der empfangenenZeichen nacheinander die Elementarentscheidung zu treffen, ob es sich um das Zeichen 0oder das Zeichen 1 handelt. Die Anzahl der Entscheidungen, also der Informationsgehalt derNachricht, ist hier notwendigerweise mit der Anzahl der binären Stellen der Nachricht identisch.Einen derartigen Entscheidungsprozess kann man in Form eines Binärbaumes veranschaulichen.So hat beispielsweise der zur Nachricht 1011 gehörige Binärbaum die in Abbildung2.5.2 dargestellte Form.1110 10 1 0 1 0 1 01 0 1 0 1 0 1 0 1 0 1 0 1 0 1 000Abbildung 2.5.2:Entscheidungsbaum für einvierstelliges Binärwort. DerEntscheidungspfad zur Identifikationdes Wortes 1011 istmarkiert. Der Pfeil gibt dieLeserichtung von der Wurzelin Richtung zu den Endknotendes Baumes an.Die Definition und insbesondere der verwendete Maßstab „Bit“ für den statistischen Informationsgehaltsind also insofern den Erfordernissen der Datenverarbeitung angepasst, als dieWortlänge und der Informationsgehalt von Binärworten identisch sind, wenn die Auftrittswahrscheinlichkeitender Zeichen 0 und 1 beide den Wert 0.5 haben.

38 2 Nachricht und Information⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯Beispiel: Der Informationsgehalt einer nicht-binären NachrichtDie Berechnung des Informationsgehaltes lässt sich ohne weiteres auf nicht-binäre Nachrichten,etwa das lateinische Alphabet, übertragen, wie das folgende Beispiel zeigt.In einem deutschsprachigen Text tritt der Buchstabe b mit der Wahrscheinlichkeit 0.016 auf.Wie groß ist der Informationsgehalt dieses Zeichens? Die Lösung dafür lautet:11log( 0.016)1.79588I(b) = ld( 0.016)= ≈ ≈ 5.97 Bitlog(2) 0.30103[ ]Für die tatsächliche binäre Codierung müsste man also – notwendigerweise aufgerundet aufdie nächst größere natürliche Zahl – die Stellenzahl 6 wählen.Praktisches Rechnen mit ZweierlogarithmenFür die praktische Berechnung des Zweierlogarithmus, der ja auf Taschenrechnern meistnicht implementiert ist, wurde oben die folgende Gleichung benützt, welche einen Logarithmuszu einer beliebigen Basis durch den Zehnerlogarithmus ausdrückt:log10(x)log10(x)logb(x) = also log2(x) = ld(x) = mit loglog (b)log (2) 10 (2) = log(2) = 0.3010310Für log 10 (x) schreibt man üblicherweise einfach log(x) und für log 2 (x) einfach ld(x). In der Mathematikwird sehr häufig der natürliche Logarithmus zur Basis e≈2.71828... verwendet. Stattlog e (x) schreibt man dafür ln(x).102.5.2 Die Entropie einer NachrichtDie Entropie als mittlerer InformationsgehaltEine Nachricht setzt sich im Allgemeinen aus Zeichen bzw. aus zu Worten verbundenen Zeichenzusammen, die einen unterschiedlichen Informationsgehalt tragen, da sie mit unterschiedlicherHäufigkeit auftreten. Man führt daher den Begriff des mittleren Informationsgehaltsoder der Entropie H einer Nachricht ein, die aus den Zeichen x 1 , x 2 , ... x n eines AlphabetsA besteht. Die Entropie ist durch den Mittelwert der mit den Auftrittswahrscheinlichkeitengewichteten Informationsgehalte der Zeichen gegeben:n1H= w(xi)ld =w(x )∑ ∑i= 1i i=1nw(x )I(x )iiDie Bezeichnung Entropie wurde wegen der formalen und in gewisser Weise auch inhaltlichenÄhnlichkeit mit einem physikalischen Gesetz der Thermodynamik gewählt, die im Grundeebenfalls eine Theorie mit statistischem Charakter ist.Der maximale InformationsgehaltMan kann nun fragen, für welche Auftrittswahrscheinlichkeiten w(x i ) der mittlere InformationsgehaltH einer aus den Zeichen x i bestehenden Nachricht maximal wird. Man findet durchAbleiten der Entropieformel nach w und Nullsetzen des Ergebnisses, dass dies dann der Fallist, wenn alle Auftrittswahrscheinlichkeiten w(x i ) gleich sind.Die Rechnung läuft für ein aus nur zwei Zeichen bestehendes Alphabet A = {x 1 , x 2 } mit denAuftrittswahrscheinlichkeiten w(x 1 )=w 1 und w(x 2 )=w 2 =1- w 1 folgendermaßen:Für die Entropie erhält man:

- Seite 1 und 2: 30 2 Nachricht und Information⎯

- Seite 3 und 4: 32 2 Nachricht und Information⎯

- Seite 5 und 6: 34 2 Nachricht und Information⎯

- Seite 7: 36 2 Nachricht und Information⎯

- Seite 11 und 12: 40 2 Nachricht und Information⎯

- Seite 13: 42 2 Nachricht und Information⎯

2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong> 37⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯I(x) = logb1w(x)Das Bit als Maß für eine <strong>Information</strong>seinheitDie Basis b des Logarithmus bestimmt lediglich den Maßstab, mit dem man <strong>Information</strong>enschließlich messen möchte. Zur Festlegung dieses Maßstabes geht man von dem einfachstendenkbaren Fall einer <strong>Nachricht</strong> aus, die nur aus einer Folge der beiden Zeichen 0 <strong>und</strong> 1besteht, wobei die beiden Zeichen mit der gleichen Wahrscheinlichkeit w 0 =w 1 =0.5 auftretensollen. Dem <strong>Information</strong>sgehalt eines solchen Zeichens wird nun per definitionem der Zahlenwert1 mit der Maßeinheit Bit zugeordnet. Daraus ergibt sich log b (1/0.5)=log b (2)=1 <strong>und</strong> folglichdurch Auflösung dieser Gleichung nach b die Basis b=2. Man erhält also schließlich fürden statistischen <strong>Information</strong>sgehalt eines mit Wahrscheinlichkeit w(x) auftretenden Zeichensx den Zweierlogarithmus aus der reziproken Auftrittswahrscheinlichkeit:I(x) = ld 1w(x)[ Bit]Man kann die Basis b, die auch als Entscheidungsgrad bezeichnet wird, als die Anzahl derZustände interpretieren, die in der <strong>Nachricht</strong>enquelle angenommen werden können. Im Fallevon b=2 sind das nur zwei Zustände, die man ohne Beschränkung der Allgemeinheit mit 0<strong>und</strong> 1 bezeichnen kann. In dieser computergemäßen binären Darstellung gibt der <strong>Information</strong>sgehalteiner <strong>Nachricht</strong> die Anzahl der als Elementarentscheidungen bezeichneten Alternativentscheidungenan, die nötig sind, um eine <strong>Nachricht</strong> Zeichen für Zeichen eindeutigidentifizieren zu können.<strong>Information</strong>sgehalt <strong>und</strong> Stellenzahl eines BinärwortesDie binäre Darstellung von <strong>Nachricht</strong>en verdeutlicht auch, dass die Maßeinheit Bit eine sinnvolleWahl ist, denn der (auf die nächstgrößere ganze Zahl ger<strong>und</strong>ete) <strong>Information</strong>sgehalteines Zeichens ist gerade die Anzahl der Stellen des Binärwortes, das man für eine eindeutigebinäre Darstellung des Zeichens verwenden muss.Empfängt man eine <strong>Nachricht</strong> in Form eines Binärworts, so ist für jedes der empfangenenZeichen nacheinander die Elementarentscheidung zu treffen, ob es sich um das Zeichen 0oder das Zeichen 1 handelt. Die Anzahl der Entscheidungen, also der <strong>Information</strong>sgehalt der<strong>Nachricht</strong>, ist hier notwendigerweise mit der Anzahl der binären Stellen der <strong>Nachricht</strong> identisch.Einen derartigen Entscheidungsprozess kann man in Form eines Binärbaumes veranschaulichen.So hat beispielsweise der zur <strong>Nachricht</strong> 1011 gehörige Binärbaum die in Abbildung2.5.2 dargestellte Form.1110 10 1 0 1 0 1 01 0 1 0 1 0 1 0 1 0 1 0 1 0 1 000Abbildung 2.5.2:Entscheidungsbaum für einvierstelliges Binärwort. DerEntscheidungspfad zur Identifikationdes Wortes 1011 istmarkiert. Der Pfeil gibt dieLeserichtung von der Wurzelin Richtung zu den Endknotendes Baumes an.Die Definition <strong>und</strong> insbesondere der verwendete Maßstab „Bit“ für den statistischen <strong>Information</strong>sgehaltsind also insofern den Erfordernissen der Datenverarbeitung angepasst, als dieWortlänge <strong>und</strong> der <strong>Information</strong>sgehalt von Binärworten identisch sind, wenn die Auftrittswahrscheinlichkeitender Zeichen 0 <strong>und</strong> 1 beide den Wert 0.5 haben.