8 Diplom- und Studienarbeiten - IAS - Technische Universität Dresden

8 Diplom- und Studienarbeiten - IAS - Technische Universität Dresden

8 Diplom- und Studienarbeiten - IAS - Technische Universität Dresden

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

<strong>Technische</strong> <strong>Universität</strong> <strong>Dresden</strong><br />

Fakultät Elektrotechnik <strong>und</strong> Informationstechnik<br />

Institut für Akustik <strong>und</strong> Sprachkommunikation<br />

Professur für Systemtheorie <strong>und</strong> Sprachtechnologie<br />

Jahresbericht 2009<br />

Berichtszeitraum 1.1.2009 bis 31.12.2009

Postanschrift (Briefe):<br />

<strong>Technische</strong> <strong>Universität</strong> <strong>Dresden</strong><br />

Fakultät Elektrotechnik <strong>und</strong> Informationstechnik<br />

Institut für Akustik <strong>und</strong> Sprachkommunikation<br />

Professur für Systemtheorie <strong>und</strong> Sprachtechnologie<br />

01062 <strong>Dresden</strong><br />

Postanschrift (Pakete):<br />

Helmholtzstr. 10<br />

01069 <strong>Dresden</strong><br />

Besucheradresse:<br />

Helmholtzstr. 18<br />

Barkhausen-Bau<br />

Sekretariat: Zi.: S48<br />

Telefon: ++49 – 351 - 463 37656 (Sekretariat)<br />

++49 – 351 - 463 32747<br />

Fax: ++49-351 – 463 – 37781<br />

E-Mail: Ruediger.Hoffmann@tu-dresden.de<br />

Als Manuskript gedruckt<br />

2

Vorwort<br />

Vorwort<br />

Der vorliegende Jahresbericht ist der neunzehnte aus dem Institut für Akustik <strong>und</strong> Sprachkommunikation<br />

der TU <strong>Dresden</strong> <strong>und</strong> umfasst für das Jahr 2009 anteilig die Aktivitäten der Professur für Systemtheorie<br />

<strong>und</strong> Sprachtechnologie <strong>und</strong> der Honorarprofessur für Elektroakustik.<br />

Um mit positiven Nachrichten zu beginnen, sollen einige erfreuliche Personalia in chronologischer<br />

Reihenfolge erwähnt werden:<br />

• Am 24. März 2009 erhielt unser langjähriger ehemaliger Institutsdirektor, Herr Prof. Dr.-Ing.<br />

habil. Peter Költzsch, auf der Konferenz NAG/DAGA in Rotterdam die Helmholtz-Medaille für<br />

seine herausragenden <strong>und</strong> vielfältigen Beiträge zur Strömungsakustik verliehen.<br />

• Zum 1. Juni 2009 bewilligte die Humboldt-Stiftung die Verlängerung des Forschungsaufenthaltes<br />

von Frau Dr. Joan K.-Y. Ma in unserer Arbeitsgruppe für ein Jahr.<br />

• Zum Wintersemester 2009/10 erhielt unsere langjährige Mitarbeiterin, Frau Dr. phil. Hongwei<br />

Ding, eine Professorenstelle für Linguistik an der School of Foreign Languages der Tongji University,<br />

Shanghai.<br />

• Am 26. Oktober 2009 wurde Herrn Dr.-Ing. Rolf Dietzel anlässlich seines 75. Geburtstages die<br />

Ehrenmedaille der TU <strong>Dresden</strong> für seine Verdienste um die Traditionspflege an unserer <strong>Universität</strong><br />

überreicht.<br />

Allen Genannten gilt noch einmal unser herzlicher Glückwunsch.<br />

Im Bereich der Lehre hat uns im Berichtsjahr der Bologna-Prozess sehr stark beschäftigt. Die Fakultät<br />

Elektrotechnik <strong>und</strong> Informationstechnik hat nach reiflicher Überlegung beschlossen, ihre drei Studiengänge<br />

nicht auf konsekutive Abschlüsse (Bachelor / Master) umzustellen, sondern das international<br />

angesehene <strong>Diplom</strong>studium beizubehalten. Gegenwärtig erfolgt die Modularisierung der <strong>Diplom</strong>studiengänge<br />

im Einklang mit den Bologna-Vorschriften.<br />

Im Hinblick auf die Entwicklung der Studentenzahlen gibt es für das Berichtsjahr keine guten Nachrichten.<br />

Die Fakultät immatrikulierte mit 324 Anfängerinnen <strong>und</strong> Anfängern wiederum reichlich 10 %<br />

weniger als im Vorjahr. Wir erklären uns diesen Effekt, der diesmal nicht im gesamtdeutschen Trend<br />

liegt, mit der im Berichtsjahr erfolgten Schließung des <strong>Dresden</strong>er Halbleiter-Herstellers Qimonda.<br />

In der Forschung zur Sprachverarbeitung macht sich im Drittmittelsektor bemerkbar, dass die meisten<br />

Konzerne ihre Forschung auf diesem Gebiet praktisch eingestellt haben. Dank der in den letzen Jahren<br />

erfolgten Verbreiterung unserer fachlichen Basis in Richtung einer allgemeiner verstandenen intelligenten<br />

Signalverarbeitung konnte die Finanzierung des wissenschaftlichen Nachwuchses trotzdem<br />

gesichert werden. Ich danke allen Förderinstitutionen <strong>und</strong> Industriepartnern, die sich gemeinsam mit<br />

uns für die Belange der Anwendung der Signal- <strong>und</strong> Systemtheorie auf sprachliche <strong>und</strong> nichtsprachliche<br />

Signale eingesetzt haben. Mein besonderer Dank gilt wieder Frau Wilhelmine Willkomm für die<br />

fortdauernde, großzügige Unterstützung der Lehre <strong>und</strong> Qualifizierung aus den Mitteln ihrer Stiftung.<br />

Allen Mitgliedern <strong>und</strong> Fre<strong>und</strong>en des Instituts für Akustik <strong>und</strong> Sprachkommunikation wünsche ich für<br />

2010 alles Gute, Ges<strong>und</strong>heit <strong>und</strong> Erfolg.<br />

<strong>Dresden</strong>, im Februar 2010 Rüdiger Hoffmann<br />

3

Inhaltsverzeichnis<br />

4<br />

Inhaltsverzeichnis<br />

Vorwort.................................................................................................................................................... 3<br />

Inhaltsverzeichnis .................................................................................................................................... 4<br />

1 Mitarbeiterinnen <strong>und</strong> Mitarbeiter ..................................................................................................... 6<br />

2 Lehre ................................................................................................................................................ 8<br />

2.1 Vorlesungen, Übungen, Praktika ................................................................................................ 8<br />

2.1.1 Pflichtfächer im Gr<strong>und</strong>- <strong>und</strong> Hauptstudium ....................................................................... 8<br />

2.1.2 Wahlobligatorische Fächer................................................................................................. 8<br />

2.1.3 Lehrveranstaltungen für andere Studiengänge (Nebenfach)............................................. 9<br />

2.1.4 Externe Lehrangebote ....................................................................................................... 9<br />

2.2 <strong>Studienarbeiten</strong> ........................................................................................................................ 10<br />

2.3 <strong>Diplom</strong>arbeiten ......................................................................................................................... 10<br />

2.4 Studienwerbung <strong>und</strong> Führungen.............................................................................................. 10<br />

3 Forschungsbericht.......................................................................................................................... 12<br />

3.1 Verarbeitung <strong>und</strong> Erkennung sprachlicher <strong>und</strong> nicht sprachlicher Signale............................... 12<br />

3.1.1 Theorie der akustischen Mustererkennung..................................................................... 12<br />

3.1.2 Sprachsteuerung für Mess- <strong>und</strong> Prüfgeräte .................................................................... 14<br />

3.2 Sprachsynthese ........................................................................................................................ 18<br />

3.2.1 Sprachsynthesesystem DRESS....................................................................................... 18<br />

3.2.2 Prosodische Analyse <strong>und</strong> Resynthese ............................................................................ 20<br />

3.3 Verarbeitung akustischer Signale (akustisches Frontend)........................................................ 21<br />

3.3.1 Robuste Spracherkennung in Räumen durch Beamforming ........................................... 21<br />

3.3.2 Multimodales, personalisiertes Bedienkonzept für Public Terminals – ..............................<br />

Mobiles Endgerät............................................................................................................. 22<br />

3.3.3 Nichtlineares Übertragungsverhalten von Kondensatormikrofonen................................ 23<br />

3.3.4 Untersuchungen zur Signalseparation für Zweikanalmikrofone ...................................... 24<br />

3.4 Anwendungen von Sprachtechnologie in Interaktionsforschung <strong>und</strong> Didaktik........................ 24<br />

3.4.1 Überblick .......................................................................................................................... 24<br />

3.4.2 Euronounce/ Intelligent Pronunciation Tutoring System ................................................. 25<br />

3.4.3 Prosodic impairment in dysarthria associated with Parkinson’s disease: Analysis-bysynthesis..........................................................................................................................<br />

30<br />

3.4.4 AvatR – Audio visual assistant turns Real........................................................................ 31<br />

3.4.5 Lingubär – Lehrmittel zur Förderung der kindlichen Sprachkompetenz .......................... 32<br />

3.4.6 CALL-Kooperation mit der Beuth Hochschule für Technik, Berlin................................... 33<br />

3.4.7 Multimediale Vorlesungsergänzung zur Systemtheorie <strong>und</strong> Signalverarbeitung ............ 34<br />

3.5 Verarbeitung von Musiksignalen .............................................................................................. 36<br />

3.5.1 Einordnung des Forschungsprojektes ............................................................................. 36<br />

3.5.2 Durchführung................................................................................................................... 37<br />

3.5.3 Vergleich statistischer Klassifikatoren zur Ermittlung musikalischer Aspekte................. 37<br />

3.6 Forschungsaktivitäten der Honorarprofessur Elektroakustik.................................................... 39<br />

3.7 Historische Aktivitäten.............................................................................................................. 39<br />

3.7.1 Bestandserschließung ..................................................................................................... 39<br />

3.7.2 Öffentlichkeitsarbeit ........................................................................................................ 39<br />

3.7.3 Projekte zu historischen phonetischen Geräten .............................................................. 41<br />

3.7.4 Geschichte der mechanischen Sprachsynthese.............................................................. 43<br />

4 Drittmittelprojekte <strong>und</strong> haushaltfinanzierte Forschung .................................................................. 44<br />

4.1 Drittmittelprojekte .................................................................................................................... 44<br />

4.2 Haushaltfinanzierte Forschung ................................................................................................. 45<br />

5 Veröffentlichungen ......................................................................................................................... 46<br />

5.1 Bücher, Buchbeiträge............................................................................................................... 46<br />

5.2 Veröffentlichungen in Zeitschriften .......................................................................................... 46<br />

5.3 TU-Informationen <strong>und</strong> Lehrmaterial ......................................................................................... 47<br />

5.4 Konferenzveröffentlichungen ................................................................................................... 47<br />

5.5 Vorträge (ungedruckt)............................................................................................................... 49

Inhaltsverzeichnis<br />

5.6 Patente ..................................................................................................................................... 51<br />

5.7 Forschungsberichte.................................................................................................................. 51<br />

5.8 Zeitungsbeiträge <strong>und</strong> Kurzmitteilungen.................................................................................... 51<br />

6 Promotionen................................................................................................................................... 52<br />

7 Habilitationen.................................................................................................................................. 52<br />

8 <strong>Diplom</strong>- <strong>und</strong> <strong>Studienarbeiten</strong>.......................................................................................................... 52<br />

8.1 <strong>Diplom</strong>-/Masterarbeiten............................................................................................................ 52<br />

8.2 <strong>Studienarbeiten</strong> ........................................................................................................................ 52<br />

9 Auszeichnungen <strong>und</strong> Ehrungen ..................................................................................................... 53<br />

9.1 Verleihung der Ehrenmedaille der <strong>Technische</strong>n <strong>Universität</strong> <strong>Dresden</strong> an ....................................<br />

Herrn Dr.-Ing. Rolf Dietzel, 26. Oktober 2009 .......................................................................... 53<br />

9.2 Innovationspreis Medizintechnik für ein TU-Projekt, 29. Oktober 2009................................... 55<br />

10 Wissenschaftliche Veranstaltungen ......................................................................................... 57<br />

10.1 Zwanzigste Konferenz Elektronische Sprachsignalverarbeitung, ............................................<br />

<strong>Dresden</strong>, 21. – 24. 9. 2009................................................................................................... 57<br />

10.1.1 Einordnung....................................................................................................................... 57<br />

10.1.2 Fachteil der ESSV, 21. – 23. 9. 2009 ............................................................................... 57<br />

10.1.3 Traditionstag, 23. / 24. 9. 2009 ........................................................................................ 58<br />

10.1.4 Zur Zukunft der ESSV ...................................................................................................... 60<br />

10.2 didacta 2009 – die Bildungsmesse Hannover, 10. – 14. 2. 2009......................................... 60<br />

10.3 Statusseminare des BMBF-Projekts „Sprachsteuerung für Mess- <strong>und</strong> Prüfgeräte“<br />

<strong>Dresden</strong>, 05. 03. <strong>und</strong> 03. 09. 2009 ...................................................................................... 61<br />

10.4 EURONOUNCE-Meetings in Bratislava, Wehlen <strong>und</strong> Poznan ............................................. 62<br />

10.5 Japanisch-deutscher Kooperationsworkshop, <strong>Dresden</strong>, 8./9. Dezember 2009................... 64<br />

10.6 ECESS-Treffen, <strong>Dresden</strong>, 18. - 19. Juni 2009 ...................................................................... 65<br />

10.7 Statusseminare des Projektes "Untersuchung des Einsatzes von Verfahren zur Analyse<br />

zeitlicher Verläufe bei der Extraktion perzeptueller musikalischer Attribute", .......................<br />

<strong>Dresden</strong>, 12. 05. <strong>und</strong> 03. 07. 2009 ...................................................................................... 65<br />

10.8 Tschechisch-deutscher Kooperationsworkshop, <strong>Dresden</strong>, 14. – 21. November 2009........ 66<br />

10.9 Wissenschaftliche Veranstaltungen zur Lautsprecherforschung......................................... 66<br />

10.9.1 Weiterbildungsveranstaltung „Assessment of Signal Distortion in Audio Systems“,<br />

<strong>Dresden</strong>, 5. – 7. 11. 2009 ................................................................................................ 66<br />

10.9.2 Gastvorlesung in Taiwan.................................................................................................. 67<br />

10.9.3 ALMA Symposium auf der Prolight + So<strong>und</strong> .................................................................. 67<br />

10.9.4 Weitere Schulungen, öffentliche Workshops <strong>und</strong> Seminare .......................................... 67<br />

11 Reisen....................................................................................................................................... 68<br />

12 Aktivitäten in der wissenschaftlichen Gemeinschaft ............................................................... 72<br />

12.1 Akademische Selbstverwaltung........................................................................................... 72<br />

12.2 Mitarbeit in Gremien ............................................................................................................ 72<br />

12.3 Mitarbeit in Programmkomitees .......................................................................................... 72<br />

5

6<br />

Mitarbeiterinnen <strong>und</strong> Mitarbeiter<br />

1 Mitarbeiterinnen <strong>und</strong> Mitarbeiter<br />

Hochschullehrer<br />

Telefon<br />

Prof. Dr.-Ing. habil. Rüdiger Hoffmann 32747<br />

Prof. Dr.-Ing. habil. W. Klippel<br />

Prof. Dr.-Ing. habil Dieter Mehnert<br />

Wissenschaftliche Mitarbeiterinnen <strong>und</strong> Mitarbeiter<br />

Honorarprofessor<br />

externer Mitarbeiter<br />

33106<br />

Dr.-Ing. Ute Feldmann bis 30.09.2009<br />

Dipl.-Ing. Oliver Jokisch 32289<br />

PD Dr.-Ing. Ulrich Kordon 32240<br />

Dipl.-Ing. Mathias Kortke 34849<br />

Dr.-Ing. Matthias Wolff 36298<br />

Wissenschaftliche Mitarbeiterinnen <strong>und</strong> Mitarbeiter auf Drittmittelstellen, Doktoranden, WHK<br />

Dr. phil. Hongwei Ding bis 30.08.2009<br />

Dipl.-Ing. Frank Duckhorn BMBF 34839<br />

Dipl.-Ing. Thomas Fehér AiF 32721<br />

MSc. Hamurabi Gamboa Rosales Stipendium/WHK 34839<br />

Dipl.-Ing. Hussein Hussein Stipendium/WHK/Beuth-Hochschule 32289<br />

für Technik Berlin<br />

Dipl.-Ing. Stephan Hübler seit 14.4.2009, mufin GmbH 32799<br />

Dipl.-Slaw. Rainer Jäckel EU 34283<br />

Dipl.-Ing. Dietmar Richter Microtech Gefell GmbH 32275<br />

Dipl.-Ing. Guntram Strecha BMBF 34849<br />

Dipl.-Inf. Constanze Tschöpe FhG 36298<br />

Dipl.-Ing. Sören Wittenberg AiF 32275<br />

Ingenieure<br />

Dipl.-Ing. Steffen Kürbis 33395<br />

Gastwissenschaftlerinnen <strong>und</strong> Gastwissenschaftler<br />

Dr. Joan Ma Humboldt-Stiftung 32799<br />

Dr. Liliya Tsirulnik DAAD (01.09. – 31.10.2009)<br />

Doc. PhDr. Jan Volín, Ph.D.<br />

DAAD-Förderprogramm Ostpartner-<br />

Mgr. Radek Skarnitzl, Ph.D.<br />

schaften – Kooperation mit der<br />

Karlsuniversität Prag<br />

(14.11. – 21.11.2009)

Stipendiaten<br />

Dr.-Ing. Udo Hain<br />

Dipl. Medienwirtin Karina Matthes<br />

Dr.-Ing. Rico Petrick<br />

Mitarbeiterinnen <strong>und</strong> Mitarbeiter<br />

exist-Gründerstipendium seit<br />

01.06.2009<br />

Dipl.-Ing. Katja Krampitz exist-Gründerstipendium 01. 06. -<br />

31.08.2009<br />

Dipl.-Inf. Niels Baumbach<br />

Dipl.-Wirtsch.-Ing. Toni Homuth<br />

Robert Granich<br />

exist-Gründerstipendium bis<br />

30.09.2009<br />

ABM/AGH E (Historische akustisch-phonetische Sammlung)<br />

Dipl.-Ing. Hans-Dieter Keil bis 31.3.2009 ABM<br />

seit 1.7.2009 AGH E<br />

Sekretärin<br />

32449<br />

32721<br />

Barbara Wrann 37656<br />

7

2 Lehre<br />

2.1 Vorlesungen, Übungen, Praktika<br />

8<br />

Lehre<br />

Im Sommersemester 2009 <strong>und</strong> im Wintersemester 2009/2010 wurden die folgenden Lehrveranstaltungen<br />

durchgeführt:<br />

2.1.1 Pflichtfächer im Gr<strong>und</strong>- <strong>und</strong> Hauptstudium<br />

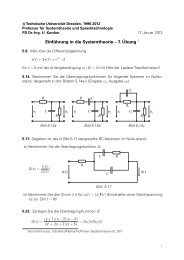

Vorlesung Systemtheorie I (Prof. Hoffmann)<br />

2 SWS Vorlesung, 1 SWS Übung<br />

Studiengänge Elektrotechnik, Informationssystemtechnik, Mechatronik u. Nebenfach<br />

WS 09/10<br />

3. Semester<br />

300 Hörer<br />

Vorlesung Systemtheorie II (Prof. Hoffmann) SS 09<br />

2 SWS Vorlesung, 2 SWS Übung 4. Semester<br />

Studiengänge Elektrotechnik, Informationssystemtechnik, Mechatronik <strong>und</strong> Nebenfach<br />

336 Hörer<br />

Vorlesung Systemtheorie III (Stochastische Signale <strong>und</strong> Systeme)<br />

(Prof. Hoffmann)<br />

2 SWS Vorlesung, 2 SWS Übung<br />

Studienrichtung Informationstechnik, Wahlfach für Studiengänge Informationssystemtechnik<br />

<strong>und</strong> Mechatronik<br />

Vorlesung Signalverarbeitung (Prof. Hoffmann)<br />

2 SWS Vorlesung, 1 SWS Übung<br />

Studienrichtung Informationstechnik, Studiengang Informationssystemtechnik <strong>und</strong><br />

Nebenfach<br />

Praktikum Mikrorechentechnik II (Mitwirkung)<br />

Versuch „Akustischer Schalter“ (PD Dr. Kordon <strong>und</strong> Mitarbeiter)<br />

Studiengang Elektrotechnik<br />

Übung Gr<strong>und</strong>lagen der Elektrotechnik (Mitwirkung)<br />

(PD Dr. Kordon, Dipl.-Ing. Kortke)<br />

2.1.2 Wahlobligatorische Fächer<br />

Doktorandenseminar Systemtheorie <strong>und</strong> Sprachtechnologie<br />

2 SWS Seminar<br />

Vorlesung Signalanalyse <strong>und</strong> –erkennung (Prof. Hoffmann)<br />

2 SWS Vorlesung, 1 SWS Übung<br />

Vorlesung <strong>Technische</strong> Sprachkommunikation (PD Dr. Kordon)<br />

2 SWS Vorlesung<br />

WS 09/10<br />

5. Semester<br />

40 Hörer<br />

WS 09/10<br />

5. Semester<br />

60 Hörer<br />

SS 09<br />

4. Semester<br />

40 Teilnehmer<br />

WS 09/10<br />

1. Semester<br />

24 Teilnehmer<br />

SS 09 <strong>und</strong><br />

WS 09/10<br />

10 Teilnehmer<br />

SS 09<br />

6. Semester<br />

20 Hörer<br />

SS 09<br />

6. Semester<br />

21 Hörer

Lehre<br />

Praktikum Akustik<br />

(gemeinsam mit der Professur Kommunikationsakustik)<br />

3 SWS Praktikum<br />

Hauptseminar Systemtheorie-Sprachtechnologie-Kommunikationsakustik<br />

(gemeinsam mit der Professur Kommunikationsakustik,<br />

Koordinator: Dipl.-Ing. Jokisch)<br />

1 SWS Seminar<br />

Akustische Mustererkennung (Dr. Wolff)<br />

2 SWS Vorlesung<br />

Vorlesung Sprachsynthese (PD Dr. Kordon)<br />

1 SWS Vorlesung<br />

Audiosignalverarbeitung<br />

(PD Dr.-Ing. Kordon/Dipl.-Ing. Kürbis)<br />

2 SWS Vorlesung, 1 SWS Praktikum<br />

Praktikum <strong>Technische</strong> Sprachkommunikation (PD Dr. Kordon)<br />

3 SWS Praktikum<br />

Vorlesung Aktive Steuerung von Schall <strong>und</strong> Schwingungen (Prof. Klippel)<br />

2 SWS Vorlesung<br />

Bewertung von Signalverzerrungen in Audiosystemen (Prof. Klippel)<br />

Blockveranstaltung<br />

2.1.3 Lehrveranstaltungen für andere Studiengänge (Nebenfach)<br />

Vorlesung Einführung in die Systemtheorie (PD Dr. Kordon)<br />

2 SWS Vorlesung, 1 SWS Übung<br />

2.1.4 Externe Lehrangebote<br />

Konzipieren, Generieren <strong>und</strong> Explorieren akustisch-phonetischer Korpora<br />

(Dipl.-Slaw. Jäckel)<br />

Vortrag im Hauptseminar Angewandte Phonetik (Institut für Germanistik)<br />

Sprachverarbeitung (PD Dr. Kordon)<br />

Lehrauftrag BTU Cottbus<br />

WS 09/10<br />

7. Semester<br />

2 Teilnehmer<br />

WS 09/10<br />

7. Semester<br />

3 Hörer<br />

WS 09/10<br />

7. Semester<br />

4 Hörer<br />

WS 09/10<br />

7. Semester<br />

5 Hörer<br />

WS 09/10<br />

7. Semester<br />

11 Teilnehmer<br />

WS 09/10<br />

7. Semester<br />

SS 09<br />

3 Hörer<br />

WS 09/10<br />

ca. 80 Hörer<br />

WS 09/10<br />

3. Semester<br />

36 Hörer<br />

27.05.09<br />

ca. 60 Hörer<br />

WS 09/10<br />

ca. 30 Hörer<br />

9

2.2 <strong>Studienarbeiten</strong><br />

10<br />

Lehre<br />

Im Berichtszeitraum wurden am Institut für Akustik <strong>und</strong> Sprachkommunikation 3 <strong>Studienarbeiten</strong><br />

angefertigt. Die Themen, die Bearbeiter <strong>und</strong> die Betreuer der Arbeiten sind im Abschnitt 8.2 aufgeführt.<br />

2.3 <strong>Diplom</strong>arbeiten<br />

Im Berichtszeitraum wurden am Institut für Akustik <strong>und</strong> Sprachkommunikation 5 <strong>Diplom</strong>arbeiten angefertigt.<br />

Die Themen, die Bearbeiter <strong>und</strong> die Betreuer der Arbeiten sind im Abschnitt 8.1 aufgeführt.<br />

2.4 Studienwerbung <strong>und</strong> Führungen<br />

Schnupperstudium am 8. Januar 2009<br />

Vorlesungen:<br />

• Einführung in die Systemtheorie (Vorlesung 3. Semester) PD Dr. Kordon<br />

• Systemtheorie I (Vorlesung 3. Semester) Prof. Hoffmann<br />

• Spracherkennung I (Vorlesung 7. Semester) Dr. Wolff<br />

Laborbesichtigung mit Experimenten<br />

• Labor für Spracherkennung <strong>und</strong> Sprachsynthese PD Dr. Kordon<br />

Betreuung von Schülerpraktika<br />

Zwei Schüler absolvierten an der Professur jeweils ein zweiwöchiges Betriebspraktikum. Dabei wurden<br />

die Aufbereitung <strong>und</strong> Digitalisierung historischer Sprach- <strong>und</strong> Musikaufnahmen der historischen<br />

akustisch-phonetischen Sammlung weiter fortgeführt.<br />

Sommeruniversität<br />

Im Rahmen der Sommeruniversität fanden im Juni <strong>und</strong> Juli 2009 (25.06., 02.07., 09.07., 16.07.) vier<br />

Veranstaltungen statt an denen insgesamt 52 Schülerinnen <strong>und</strong> Schüler teilnahmen). Diese Veranstaltungen<br />

wurden in Zusammenarbeit mit dem Lehrstuhl für Kommunikationsakustik durchgeführt.<br />

Von der Professur für Systemtheorie <strong>und</strong> Sprachtechnologie erfolgte eine Einführung in die Sprachanalyse<br />

<strong>und</strong> Sprachsynthese durch PD Dr. Kordon <strong>und</strong> Dipl.-Ing. Wittenberg.<br />

Es wurde das Labor für Spracherkennung <strong>und</strong> Sprachsynthese besichtigt.<br />

Lange Nacht der Wissenschaften<br />

Am 19. Juli 2009 beteiligte sich die Professur zum wiederholten Male mit<br />

• der Präsentation von Experimenten im Spracherkennungs- <strong>und</strong> Sprachsyntheselabor <strong>und</strong><br />

• der Vorstellung der historischen akustisch-phonetischen Sammlung unter dem Titel „Forschen<br />

wie Professor Higgins“<br />

• Demonstration der adaptiven Lautsprechersteuerung (Prof. Klippel)<br />

an der Langen Nacht der Wissenschaften.<br />

Es konnten wieder mehrere h<strong>und</strong>ert Besucher an diesem Abend begrüßt werden.

Lehre<br />

Besuch einer Schülergruppe des HOGA-Gymnasiums<br />

an der Fakultät Elektrotechnik <strong>und</strong> Informationstechnik<br />

am 5.2.2009<br />

Anteil der Professur Systemtheorie <strong>und</strong> Sprachtechnologie:<br />

Fachvortrag „Denken in Systemen“<br />

Herr Prof. R. Hoffmann (Inst. für Akustik <strong>und</strong> Sprachkommunikation) demonstriert am Beispiel seines<br />

Fachgebietes, der Mensch-Maschine-Kommunikation mittels natürlicher Sprache, unsere prinzipielle<br />

Vorgehensweise bei der Beschreibung von Systemen sowie zur Lösung ingenieurtechnischer Aufgaben<br />

Stammtisch der VDE-Hochschulgruppe<br />

am 16.06.2009<br />

„Sprachsynthese – wie baue ich mir eine Stimme?“<br />

Vortrag <strong>und</strong> Diskussion PD Dr.-Ing. U. Kordon<br />

Es konnten ca. 15 Teilnehmer begrüßt werden.<br />

Besuch einer Gruppe von Schülern des Goethe-Insituts<br />

an der Fakultät Elektrotechnik <strong>und</strong> Informationstechnik<br />

am 27.08.2009<br />

60 Schüler <strong>und</strong> 10 Betreuer des Goethe-Instituts<br />

Anteil der Professur Systemtheorie <strong>und</strong> Sprachtechnologie:<br />

Vortrag: Dipl.-Ing. Wittenberg<br />

Demonstration des Spracherkenners: Dipl.-Ing. Duckhorn<br />

Exkursion von Studenten der HTW <strong>Dresden</strong><br />

am 10.09.2009<br />

Vorstellung des Arbeitsgebietes Sprachtechnologie<br />

Ausstellung SprachSignale in den <strong>Technische</strong>n Sammlungen der Stadt <strong>Dresden</strong><br />

Führung durch die Ausstellung<br />

am 2.10.2009<br />

führte Dipl.-Ing. Fehér 35 Schüler des Schiller-Gymnasiums Pirna durch die Ausstellung SprachSignale<br />

Vortrag im Rahmen des Turmfestes<br />

am 8.11.2009<br />

Professor Hoffmann<br />

Von legendären sprechenden Köpfen zu elektronischen „talking heads“<br />

Vortrag<br />

am 6.12.2009<br />

PD Dr.-Ing. Kordon<br />

Wie „hört“ <strong>und</strong> „spricht“ ein Computer“?<br />

11

3 Forschungsbericht<br />

12<br />

Forschungsbericht<br />

3.1 Verarbeitung <strong>und</strong> Erkennung sprachlicher <strong>und</strong> nicht<br />

sprachlicher Signale<br />

In diesem Abschnitt berichten wir über die verschiedenen Arbeiten, die im Rahmen der Weiterentwicklung<br />

<strong>und</strong> Anwendung unserer Plattform UASR (Unified Approach to Signal Synthesis and<br />

Recognition) durchgeführt wurden.<br />

Zunächst wird auf die Weiterentwicklung der theoretischen Basis eingegangen. Diese Ergebnisse<br />

sind im Zusammenhang mit den Anwendungen auf nicht sprachliche Signale entstanden. Wie aus<br />

den vorhergehenden Jahresberichten bekannt ist, hat sich dieser Anwendungsbereich stark ausgedehnt.<br />

Danach erfolgt die Beschreibung der Arbeiten, die im Berichtszeitraum im Rahmen des vom BMBF<br />

geförderten Projekts „Sprachsteuerung für Mess- <strong>und</strong> Prüfgeräte (SSMG)“ durchgeführt wurden <strong>und</strong><br />

die Umsetzung des UASR in Hardware zum Ziel haben. Diese Arbeiten stehen in engem Zusammenhang<br />

mit den Projekten zu nicht sprachlichen Signalen.<br />

3.1.1 Theorie der akustischen Mustererkennung<br />

Auf dem Gebiet der akustischen Mustererkennung wurde im Berichtszeitraum die theoretische<br />

Gr<strong>und</strong>lage weiterentwickelt. Dies betrifft speziell eine verbesserte mathematische Formulierung von<br />

Hidden-Markov-Modellen, welche die Lücke zur Theorie der Finite-State-Transducers (endliche Transduktoren)<br />

schließt.<br />

Eigenschaften von Prüfobjekten äußern sich als typische Ausprägungen <strong>und</strong> zeitliche Abfolgen von<br />

Signalereignissen. Mit Hilfe von Verfahren der Signalanalyse, Merkmalextraktion, -kompression <strong>und</strong><br />

statistischen Mustererkennung werden automatisch Modelle der Messsignale erstellt. Diese Modelle<br />

können zur Beurteilung unbekannter Prüfobjekte benutzt werden. Es werden Hidden-Markov-Modelle<br />

(HMM) <strong>und</strong> Support Vector Machines (SVM) oder in einfachen Fällen Gaussian Mixture Models<br />

(GMM) eingesetzt. Da diese Verfahren lernfähig <strong>und</strong> problemunabhängig sind, eignen sie sich im Prinzip<br />

für jede akustische Diagnose. Sie benötigen wenig oder gar kein a-priori-Wissen, sind skalierbar<br />

<strong>und</strong> echtzeitfähig. Fallen Daten mehrerer Sensoren an, können diese kombiniert werden, um eine<br />

Gesamtaussage zu treffen.<br />

Anhand einer speziellen Prüfaufgabe, der Erkennung eines bevorstehenden Ausfalls von Magnetventilen,<br />

soll die Verfahrensweise genauer erläutert werden. Das Schaltgeräusch eines Ventils beim Öffnen<br />

<strong>und</strong> Schließen ist in Abbildung 3.1 dargestellt. In dessen Signalstruktur ist das Auftreten von Ereignissen<br />

besonders deutlich erkennbar (Abbildung 3.1, oben: mit den vier Ereignissen E0 – „geschlossen“,<br />

E1 – „öffnen“, E2 – „offen“, E3 – „schließen“). Bei der Merkmalextraktion werden aus<br />

dem Signal in gleichmäßigen Abständen einzelne Merkmalvektoren <strong>und</strong> somit insgesamt eine Merkmalvektorfolge<br />

gebildet(Abbildung 3.1, Mitte). Die interessierenden Eigenschaften liegen nicht nur in<br />

einem Spektrum (räumliche Eigenschaften), sondern auch in der Folge von Spektren (zeitliche Struktur).<br />

Eine kurze Folge von Merkmalvektoren beschreibt ein akustisches Ereignis (z. B. E1: öffnen).<br />

Diese Ereignisse werden bei HMMs in Form von Verteilungsdichtefunktionen beschrieben.<br />

Die Modellierung von Folgen solcher Ereignisse, also der Signalstruktur, erfolgt als Markov-Kette erster<br />

Ordnung (typisch für Folgenklassifikatoren). Jeder mögliche Zustandsübergang tritt mit einer bestimmten<br />

Wahrscheinlichkeit auf (Abbildung 3.1 unten). Die Zustandsfolge in diesem Beispiel ist offensichtlich,<br />

sie muss jedoch nicht bekannt sein, da das System in der Lage ist, diese selbst zu lernen.<br />

Im Ablauf der Arbeiten konnte die HMM-Theorie weiter entwickelt werden. Dies führte zu einer einheitlichen<br />

Darstellung zur Bestimmung der Ausgabewahrscheinlichkeit <strong>und</strong> der EM-Schätzformeln in<br />

den Wahrscheinlichkeits-, Max/Mal-, logarithmischen <strong>und</strong> tropischen Halbringen (Forward/Backward-<br />

vs. Viterbi-Algoritmus, Baum-Welch- vs. Viterbi-Training, Abbildung 3.2).

Forschungsbericht<br />

Abbildung 3.1: Ablauf der Signalklassifikation mit Unterteilung des Signals in Ereignisse (oben), Darstellung<br />

der Merkmalvektorfolge nach Kurzzeit-FFT (Mitte) <strong>und</strong> statistischer Modellierung (unten).<br />

13

14<br />

Forschungsbericht<br />

Abbildung 3.2: Vereinheitlichte Darstellung von Forward/Backward- <strong>und</strong> Viterbi-Algorithmus,<br />

Details siehe [1].<br />

Die Formeln zur HMM-Parameterschätzung können dadurch folgendermaßen dargestellt werden:<br />

mit<br />

In Abhängigkeit von dem gewählten Gewichtshalbring stellen diese Formeln gleichzeitig das Baum-<br />

Welch- <strong>und</strong> das Viterbi-Training dar. Eine genauere Erläuterung findet man in [1].<br />

[1] C. Tschöpe, M. Wolff: Statistical Classifiers for Structural Health Monitoring. IEEE Sensors<br />

Journal 9 (2009) 11, pp. 1567 - 1576.<br />

3.1.2 Sprachsteuerung für Mess- <strong>und</strong> Prüfgeräte<br />

Fortführung der DSP-Portierung des Spracherkenners<br />

Im Berichtsjahr 2009 wurde der C++ Spracherkenner, welcher 2008 auf den Digitalen Signalprozesser<br />

TMS320C6727 von Texas Instruments portiert wurde, optimiert <strong>und</strong> an die FPGA-Impementierung<br />

der Merkmalanalyse durch das Fraunhofer Institut für zerstörungsfreie Prüfung (IZfP) angepasst. Hierzu<br />

wurden folgende Schritte durchgeführt:<br />

1. Der Ablaufplan des Spracherkenners, wie er im Jahresbericht 2009 abgedruckt war, musste<br />

an die Implementierung der Merkmalextraktion auf dem FPGA sowie den neuen Entwurf der<br />

akustischen Nutzerschnittstelle angepasst werden.<br />

2. In Abbildung 3.3 ist der veränderte Ablaufplan dargestellt. Zum Einen wurde in den Pfad der<br />

Merkmale für die Voice activity detection (VAD) ein Block mit Normalisierung <strong>und</strong> Hauptkomponentenanalyse<br />

(PCA) eingefügt. Hierdurch kann die Dimenstion der Merkmale von 30 auf<br />

10 reduziert werden. Somit wird Speicherplatz <strong>und</strong> Rechenzeit für die Berechnung der Mahalanobisdistanzen<br />

der VAD gespart. Zum Anderen wurde die Entscheidung ob der Merkmals-

Forschungsbericht<br />

vektor verwendet wird oder nicht ans Ende der Merkmalextraktion verschoben (also nach den<br />

Block GMM – gewichtete Summe). Dadurch konnte der VAD Puffer 1 eingespart werden <strong>und</strong><br />

dessen Aufgabe (die Vektoren um die Verzögerungszeit der VAD zu puffern) wurde vollständig<br />

vom SFA Puffer übernommen. So reduziert sich die gesamte Verzögerung um die Verzögerung<br />

der Delta-Berechnung. Außerdem wird die Merkmalextraktion im FPGA nicht mehr<br />

durch die VAD beeinflusst werden.<br />

3. Die DSP-Software wurde in das FPGA Demonstrationsprogramm des IzfP integriert. Hierfür<br />

wurden die berechneten Mahalanobisdistanzen aus dem FPGA übernommen <strong>und</strong> in den Ablauf<br />

der Suche eingefügt. Im Weiteren wurde die Synchronisation mit der akustischen Nutzerschnittstelle<br />

realisiert <strong>und</strong> die Übertragung von Erkennungsergebnissen sowie Debug-<br />

Information zum Steuerprogramm auf dem PC über USB ermöglicht.<br />

4. Die Spracherkennung wurde um die Verwendung von kontextfreien Grammatiken erweitert.<br />

Dadurch kann in Grammatiken der Form „Größe Zahl Einheit“ eine Beziehung zwischen Größe<br />

<strong>und</strong> Einheit abgebildet werden (was in regulären Grammatiken nicht möglich ist). Die Suche<br />

verarbeitet diese Grammatiken mit einem integrierten Kellerautomaten.<br />

5. Ein kleiner Speichermanager im DSP für temporäre Daten beschleunigt den Speicherzugriff.<br />

Alle Daten, die für die Suche benötigt werden passen nicht in den internen Speicher des<br />

DSPs. Da dieser aber deutlich geringere Zugriffszeiten als der externe Speicher hat wurde ein<br />

Speichermanager implementiert, der Restkapazitäten im internen Speicher für die Suche<br />

nutzt. Dadurch konnte der Echtzeitfaktor für die Suche von 50 - 70% auf 15 - 40% reduziert<br />

werden.<br />

Voice activity detection (VAD) für den DSP-Spracherkenner<br />

Der DSP-Spracherkenner wurde um eine Voice Activity Detection (VAD) erweitert. Diese verwendet<br />

die primären Merkmale des Spracherkenners. Dadurch wird eine zweite Merkmalextraktion für die<br />

VAD nicht benötigt. Die Verarbeitung der Merkmalvektoren ist analog zu Verarbeitung in dem Spracherkennungszweig<br />

aufgebaut (Hauptkomponentenanalyse, Mahalanobisdistanz, GMM). So wurde der<br />

Implementierungsaufwand deutlich reduziert. Die Entscheidung ob ein Vektor als Sprache oder Pause<br />

detektiert wird fällt auf das GMM mit der größten Wahrscheinlichkeit. Anschließend wird diese Entscheidung<br />

noch durch einen Zustandsautomaten über mehrere Vektoren geglättet. Dabei fügt dieser<br />

bestimmte Restriktionen (minimale Sprach- <strong>und</strong> Pausenlänge, Vor- <strong>und</strong> Nachlauf) in die Folge der<br />

Entscheidungen ein. Wenn der Signalpegel innerhalb eines Sprachabschnitts einen bestimmten<br />

Schwellwert überschreitet, wird dieser Abschnitt endgültig als Sprache markiert <strong>und</strong> der Spracherkennung<br />

zugeführt.<br />

DSP-Portierung von Algorithmen zur HMM-basierten Sprachsynthese<br />

Für das BMBF-Projekt „Sprachsteuerung für Mess- <strong>und</strong> Prüfgeräte“ wurde bereits im vorangegangenen<br />

Berichtszeitraum eine HMM-basierte Sprachsynthese entwickelt. Um den Speicherverbrauch zu<br />

minimieren, verwendet das Synthesesystem die Datenbasen (speziell: die Hidden-Markov-Modelle)<br />

des Erkennungssystems. Aufgr<strong>und</strong> der Verwendung dieser sprecherunabhängigen Modelle ist eine<br />

Konvertierung zum Zielsprecher notwendig. Um den Rechenaufwand zu Minimieren erfolgt die Konvertierung<br />

an den vom HMM emittierten Merkmalvektoren durch eine lineare Transformation in Form<br />

einer Multiplikation mit einer sprecherabhängigen Konvertierungsmatrix.<br />

15

16<br />

Forschungsbericht<br />

Abbildung 3.3: Blockschaltbild der Erkenner-Hardware

Forschungsbericht<br />

Im aktuellen Berichtszeitraum wurden die Algorithmen des Synthesesystems auf die Zielplattform<br />

portiert. Der verwendete DSP besitzt eine 32-bit Fließkommaeinheit, sodass die im Experimentiersystem<br />

vorliegenden Algorithmen doppelter Genauigkeit (64-bit) auf einfache Genauigkeit (32-bit) reduziert<br />

wurden. Folgende Algorithmen wurden portiert:<br />

1 Periodenmarkenfolge aus der Gr<strong>und</strong>frequenzkontur erzeugen,<br />

2 Merkmalvektorfolge anhand der Zustandsfolge aus den HMMs generieren,<br />

3 inverse Hauptkomponentenanalyse (PCA).<br />

4 Sprecheradaption: Transformation der Merkmalvektorfolge in eine Folge von mel-line cepstral<br />

quefrencies (M-LCQ).<br />

5 Synchronisieren der M-LCQ- <strong>und</strong> Periodenmarkenfolge.<br />

6 Glättung der M-LCQ-Vektorfolge.<br />

7 Synthesefilter:<br />

a) Denormalisierung.<br />

b) M-LCQ zu Mel-Cepstrum Transformation<br />

c) Mel-Cepstrum-Synthesefilter.<br />

Die Rechengenauigkeit einiger Algorithmen nach der Reduktion der Bitbreite auf 32 bit war so gering<br />

(besonders 7b), dass diese Algorithmen inhaltlich umgestellt werden mussten. Die portierten Algorithmen<br />

wurden auf der Zielplattform getestet. Die Rechengenauigkeit der gesamten Verarbeitungskette<br />

ergibt sich aus der Differenz (siehe Abbildung 3.4, schwarzes Signal mit rechter Ordinate) zwischen<br />

den Synthesesignalen erzeugt mit den Experimentiersystem (siehe Abbildung 3.4, graues Signal<br />

mit linker Ordinate) <strong>und</strong> der portierten Synthese.<br />

Abbildung 3.4: Beispiel für Signalfehler bei der HMM-Sprachsynthese durch Verwendung von 32 Bit<br />

anstelle von 64 Bit Gleitkomma-Arithmetik (grau: Originalsignal, schwarz: Fehlersignal)<br />

17

3.2 Sprachsynthese<br />

3.2.1 Sprachsynthesesystem DRESS<br />

18<br />

Forschungsbericht<br />

Die Entwicklungsarbeiten am <strong>Dresden</strong>er Sprachsynthesesystem DRESS konzentrierten sich im Berichtsjahr<br />

auf die Einbeziehung der Korpussynthese, die im Rahmen des Promotionsvorhabens von<br />

Herrn Gamboa bearbeitet wird. Dabei wurde eine Maximum-Likelihood-Bausteinauswahl entwickelt,<br />

die auf einer Mappinganalyse der Verkettungssubkosten (VK), der BAYES-Klassifikation (BK) <strong>und</strong><br />

der Maximum-Likelihood (ML)-Methode basiert. Der Hauptvorteil dieses neuen Bausteinauswahlverfahrens<br />

ist, dass kein langwieriges Training mehr notwendig ist, um die gewichteten Koeffizienten für<br />

die VK zu bestimmen.<br />

Mappinganalyse: Das Mapping erfolgt über eine Berechnung (offline) der VK zwischen den Bausteinen<br />

in der Datenbank, die keine oder die ungewünschten Verzerrungen aufweisen, wenn sie verkettet<br />

werden. Die VK werden durch die Abstandsberechnung zwischen den Eigenschaften der Bausteine<br />

wie Multiple-Centroid-Analyse (MCAs), Linear Spectral Frequencies (LSF) <strong>und</strong> MFCC an der linken<br />

<strong>und</strong> rechten Grenze abgeschätzt. Bei der Anwendung einer Datenbank wird das Mapping der VK, die<br />

keine Verzerrungen bei der Verkettung zeigen, durch die Abstandsberechnungen zwischen den Bausteinen<br />

durchgeführt, die in einem Wort oder Satz der Datenbank aufeinander folgen. Das Mapping<br />

der VK der ungewünschten Verzerrungen erfolgt über einen festgelegten Satz an Bausteinen. Diese<br />

Bausteine entstammen aus verschiedenen Wörtern <strong>und</strong> Sätzen der Datenbank <strong>und</strong> somit aus verschiedenen<br />

phonetischen Kontexten. Daher sind sie mehrheitlich nicht richtig verkettet.<br />

BAYES-Klassifikation: Nach dem Mapping der VK müssen die glatten <strong>und</strong> verzerrten Verkettungsflächen<br />

festgelegt werden. Dazu kommt die Unterscheidungsfunktion eines BAYES-Klassifikators mit<br />

normalverteilten Merkmalvektoren zur Anwendung. Die Abbildung 3.5 zeigt eine zweidimensionale<br />

Mappinganalyse, wobei beide Verkettungsflächen durch die Trennfunktion d12( x r ) abgegrenzt werden.<br />

Abbildung 3.5: Trennfunktion.<br />

Bausteinauswahlprozess: Der Vorgang der Bausteinauswahl besteht aus verschiedenen Stufen, die<br />

in Abbildung 3.6 zu sehen sind. Zunächst werden die Bausteinkandidaten in der großen Datenbank<br />

durch den Backward-Oracle-Matching-Algorithmus gesucht. Dieser wählt alle Bausteinfolgen aus, die<br />

der linguistisch-phonetischen Umsetzung des zu synthetisierenden Textes entsprechen. Danach werden<br />

die MCAs, LSF <strong>und</strong> MFCC der gef<strong>und</strong>enen Bausteine an den Grenzen zum vorhergehenden (linke<br />

Grenze) <strong>und</strong> nachfolgenden Baustein (rechte Grenze) berechnet <strong>und</strong> in einem Vektor abgebildet.<br />

Im Anschluss wird der Abstand zwischen dem Vorgänger <strong>und</strong> dem Kandidatenbaustein des gewünschten<br />

zu synthetisierten Sprachsignals berechnet.

Forschungsbericht<br />

Abbildung 3.6: Ablauf der Maximum-Likelihood-Bausteinauswahl.<br />

Der berechnete VK-Abstandsvektor der Bausteine wird von dem BK verarbeitet. Der BK klassifiziert<br />

die Verkettung zwischen den Bausteinen in glatte <strong>und</strong> verzerrte Verkettungstypen mit Hilfe der entsprechenden<br />

Trennfunktion. Die Übergänge aus der Netzmatrix, von deren Bausteinen festgestellt<br />

wurde, dass sie nicht verzerrungsfrei verketten <strong>und</strong> dessen VK laut Trennfunktion nicht in der glatten<br />

Verkettungsfläche liegen, werden entfernt (Abbildung 3.6). Dies bedeutet, dass sie nicht mehr für den<br />

Bausteinauswahlprozess berücksichtigt werden. Durch den Ausschluss der verzerrt verkettenden<br />

Bausteine verringert sich der Zeit- <strong>und</strong> Rechenaufwand der Bausteinauswahl. Danach werden die<br />

noch vorhandenen Bausteine durch die entsprechende vorher erhaltene Verteilung des glatten Verkettungstyps<br />

aus der Mappinganalyse mit Hilfe der ML-Methode verarbeitet. Dabei wird die Wahrscheinlichkeit<br />

einer glatten Verkettung zwischen den Bausteinen berechnet. Die erhaltenen Wahrscheinlichkeiten<br />

der glatt verkettenden Bausteine werden als einzige dglatt( x r ) Verkettungkosten in der Netzmatrix<br />

beibehalten (Abbildung 3.7).<br />

Abbildung 3.7 zeigt die Entfernung der Übergänge zwischen den Bausteinen mit verzerrtem Verkettungstyp.<br />

Schließlich wird nach der Anwendung der ML-Bausteinauswahl im nächsten Schritt genau<br />

die Bausteinfolge durch die Anwendung des Viterbi-Algorithmus ausgesucht, die in der Netzmatrix<br />

minimale Ziel- <strong>und</strong> Verkettungskosten aufweist, um das erwünschte Sprachsignal mit möglichst geringen<br />

Verzerrungen über die konkatenative Sprachsynthese zu erhalten.<br />

Abbildung 3.7: Entfernung der Übergänge zwischen den Bausteinen mit verzerrtem Verkettungstyp<br />

<strong>und</strong> Einführung von Wahrscheinlichkeit der glatten Verkettungen als Verkettungskosten.<br />

19

20<br />

Forschungsbericht<br />

3.2.2 Prosodische Analyse <strong>und</strong> Resynthese<br />

Die Natürlichkeit der synthetisierten Sprache hängt von der automatischen Extraktion der prosodischen<br />

Eigenschaften <strong>und</strong> der prosodischen Modellierung ab. Ziel der im Rahmen des Promotionsvorhabens<br />

von Herrn Hussein durchgeführten Untersuchungen ist die Übertragung einer Zielprosodie im<br />

Rahmen einer Resynthese.<br />

Abbildung 3.8: Resynthese der extrahierten Akzente <strong>und</strong> Phrasen mit Hilfe eines Cepstrum-Vocoders.<br />

Die Akzent <strong>und</strong> Phrasen wurden durch die Analyse der F0-Kontur mit Hilfe des Fujisaki-Models markiert.<br />

Die Periodenmarken (PM) dienen als prosodische Merkmale für den Cepstrum-Vocoder. Um das<br />

Konzept der „Analyse durch Resynthese“ zu implementieren, wurden die Periodenmarken von verschiedenen<br />

Positionen des Akzent- <strong>und</strong> Phrasenmarkierungsalgorithmus (siehe Abbildung 3.8) berechnet.<br />

Diese Positionen sind: A - originale PM; B - PM der berechneten F0-Kontur; C - Konversion<br />

der Fujisaki-Parameter zu PM; D - Konversion der modifizierten Fujisaki-Parameter zu PM.<br />

Ein Hörtest (Preference test) wurde zur Prüfung der Qualität der resynthetisierten Sprachsignale<br />

durchgeführt. 20 Personen haben an diesem Hörtest teilgenommen; jede Person hat 60 Paare von<br />

Sprachsignalen verglichen. Die Ergebnisse des Hörtestes sind in Abbildung 3.9 für jedes Paar <strong>und</strong> für<br />

alle resynthetisierten Sprachsignale dargestellt.<br />

Abbildung 3.9: Ergebnisse des Hörtests

Forschungsbericht<br />

3.3 Verarbeitung akustischer Signale (akustisches Frontend)<br />

3.3.1 Robuste Spracherkennung in Räumen durch Beamforming<br />

Spracherkennung in realen Räumen ist bis heute ein großes Problem. Erkennungsraten von ungestörten<br />

Signalen im Bereich von 90 % <strong>und</strong> mehr verschlechtern sich in realen Räumen, je nach Sprecher-<br />

Mikrofon-Abstand (SMA) <strong>und</strong> Nachhallzeit des Raumes, auf bis zu unter 30 %, wie in Abbildung 3.11.<br />

(„einkanalig“) deutlich zu sehen ist. Gr<strong>und</strong> dafür ist der Nachhall des Raumes, wodurch ein „Verwaschen“<br />

des Zeitsignals <strong>und</strong> auch des Spektrums zu beobachten ist.<br />

Eine bekannte Methode zur Verringerung der als Störschall arbeitenden Reflexionen ist das Beamforming.<br />

Dabei werden mehrere Mikrofonsignale zu einem einzelnen Signal verrechnet <strong>und</strong> dadurch<br />

eine Richtwirkung erzielt. Diese Richtwirkung bewirkt, dass seitlich eintreffender Schall (Raumreflexionen)<br />

gedämpft wird, während frontal einfallender Schall (das gewünschte Sprachsignal) ungedämpft<br />

passieren kann. An dieses Gr<strong>und</strong>prinzip anknüpfend, gibt es eine Vielzahl von Beamformingalgorithmen.<br />

In Abbildung 3.11 sind aktuelle Messungen in realen Räumen gezeigt, deren Ergebnisse einem Spracherkenner<br />

zugeführt wurden. Gemessen wurde die Erkennungsrate eines Kommandoworterkenners.<br />

Getestet wurden 2 Beamformingalgorithmen. Der Delay and Sum Beamformer (DSB), eine relativ<br />

einfache Variante des Beamformings, sowie der Minimum Variance Distortionless Response<br />

Beamformer (MVDRB).<br />

Abbildung 3.10: Schematische Darstellung des MVDRB.<br />

Der MVDRB arbeitet im Frequenzbereich (schematische Darstellung siehe Abbildung 3.10) <strong>und</strong> kann<br />

über die frequenzabhängigen Wichtungsfaktoren ( ) an das Störschallfeld angepasst werden.<br />

Des Weiteren kann die Ausrichtung des Beamformers geändert werden. Dadurch ist es möglich auf<br />

Quellen zu fokussieren, die sich nicht direkt vor der Mikrofonanordnung befinden. Letzteres ist ebenfalls<br />

mit dem DSB möglich, allerdings bietet der DSB keine Möglichkeit der Anpassung an das Schallfeld.<br />

ω j<br />

Wi<br />

e<br />

Das Ergebnis der Messungen ist in Abbildung 3.11 zu sehen. Sowie eine zunehmende Nachhallzeit,<br />

als auch ein zunehmender SMA verschlechtern die Erkennungsergebnisse deutlich. Durch die Nutzung<br />

der Beamformer bleibt dieser Trend zwar erhalten, aber die absoluten Ergebnisse liegen deutlich<br />

über denen der einkanalig aufgenommenen Signale. Vor allem im mittleren Bereich der Nachhallzeit<br />

(0,45 s, Abbildung 3.11 oben rechts) erreicht der MVDRB eine Verbesserung um ca. 20%. Diese<br />

Nachhallzeit entspricht einem durchschnittlichen Wohnzimmer.<br />

Weitere Verbesserungen können im Anschluss mit Hilfe von einkanaligen Algorithmen, sowie Algorithmen<br />

auf Feature- <strong>und</strong> Modellebene erreicht werden.<br />

21

22<br />

Forschungsbericht<br />

Abbildung 3.11 : Erkennungsraten des DSB <strong>und</strong> des MVDRB im Vergleich mit einkanaligen Aufnahmen<br />

bei verschiedenen Abständen <strong>und</strong> in verschiedenen Räumen. Nachhallzeiten:<br />

links oben: 0,25 s; rechts oben: 0,45 s; links unten: 0,7 s; rechts unten: 0,95 s.<br />

In Zusammenarbeit mit Industriepartnern <strong>und</strong> weiteren Forschungseinrichtungen der TU <strong>Dresden</strong><br />

wird an einem Prototypen für ein Sprachgesteuertes „Public Terminal“ (Informationsterminal) gearbeitet.<br />

Dieses Terminal wird einen MVDR-Beamformer wie oben beschrieben nutzen um den Störschall<br />

zu filtern, den Sprecher vor dem Terminal zu orten <strong>und</strong> dann akustisch auf ihn zu fokussieren.<br />

Weitere Aspekte dieses Projektes werden im Folgenden erläutert.<br />

3.3.2 Multimodales, personalisiertes Bedienkonzept für<br />

Public Terminals – Mobiles Endgerät<br />

Infolge zunehmender Akzeptanz von elektronischen "Info-Punkten" <strong>und</strong> anderen öffentlichen Automaten<br />

(Public Terminals) steigt deren Nutzung, was zu Wartezeiten an diesen Automaten führen kann.<br />

Durch die Verbesserung des Bedienprozesses kann eine schnelle Bereitstellung der gesuchten Informationen<br />

erreicht <strong>und</strong> die Wartezeit anderer Benutzer gesenkt werden. Im Rahmen des Kooperationsprojekts<br />

"Multimodales, personalisiertes Bedienkonzept für Public Terminals" 1 mit der voice INTER<br />

connect GmbH <strong>und</strong> dem Institut für Angewandte Informatik der TU <strong>Dresden</strong> wird an der Verbesserung<br />

des Bedienprozesses durch die Integration einer Sprachein- <strong>und</strong> ausgabe geforscht. Dieses multimodale<br />

Bedienkonzept soll zusätzlich auf in der Nähe befindliche mobile Endgeräte übertragen werden<br />

<strong>und</strong> so die gleichzeitig Bearbeitung mehrer Benutzer erlauben. Durch das ohnehin ständige Mit-<br />

1 Förderung durch die Arbeitsgemeinschaft industrieller Forschungsvereinigungen (AiF) „Otto von Guericke“ e.V.<br />

im Rahmen des Förderprogramms PRO INNO II - Förderung der Entwicklung innovativer Produkte <strong>und</strong> Verfahren“;<br />

Fördernummer: ProInno KF 0033704LF8

Forschungsbericht<br />

führen von mobilen Endgeräten (z.B. Mobiltelefon) erlaubt dies die intuitive Abfrage standortbezogener<br />

Informationen mit dem eigenen, vertrauten Endgerät ohne Zusatzkosten. Da dieser Service nur in<br />

der Nähe des Automaten bereitgestellt wird, kann von einem Location Based Service (standortbezogener<br />

Dienst) gesprochen werden. Zur drahtlosen Kommunikation ist Bluetooth angedacht, da so<br />

keine Funknetzinfrastruktur vorausgesetzt werden muss.<br />

Infolge der Vielfalt an mobilen Endgeräten ist das<br />

angestrebt Ziel nur mit standardisierten Techniken<br />

möglich. Eine von vielen Herstellern implementierte<br />

Technik ist J2ME (Java Plattform 2, Micro Edition)<br />

von Sun Microsystems. Speziell definierte Konfigurationen<br />

wie zum Beispiel CLDC (Connected Limited<br />

Device Configuration) beschreiben dabei die minimale<br />

notwendige Konfiguration für die Laufzeitumgebung<br />

(z.B. notwendiger Speicher). Ergänzt werden<br />

die Konfigurationen durch Profile, wie z.B. das Mobile<br />

Information Device Profile (MIDP). Diese definieren<br />

die minimale Hardwareausstattung (Bildschirmgröße,<br />

Eingabemöglichkeiten usw.) der Endgeräte.<br />

Neben diesen definierten Minimalausstattungen<br />

können Java Specification Requests (JSR), also Anforderungen<br />

auf eine neue Spezifikation bzw. Änderung<br />

oder Erweiterung einer bestehenden Spezifikation<br />

eingereicht werden, die dann im Rahmen des<br />

Java Community Process (JCP) zu Spezifikationen<br />

führen die z.B. den Zugriff auf die Bluetooth- (JSR-<br />

082) oder der Audioschnittstelle (JSR-135) regeln.<br />

Abbildung 3.12: Keine Wartezeit bei der parallelen<br />

Benutzung eines mobilen Endgerätes am<br />

öffentlichen Automaten.<br />

Im Berichtsjahr konnten folgende Funktionalitäten im mobilen Endgeräte realisiert <strong>und</strong> getestet werden:<br />

- visuelle Inhalte des Automaten drahtlos empfangen <strong>und</strong> darstellen<br />

- Aufnahme <strong>und</strong> Wiedergabe akustischer Informationen<br />

- digitale Signalverarbeitung<br />

- Übertragung von Sprachdaten an den Spracherkenner im Automaten<br />

- Empfang der Automatenreaktion in visueller <strong>und</strong> akustischer Repräsentation<br />

3.3.3 Nichtlineares Übertragungsverhalten von<br />

Kondensatormikrofonen<br />

Mikrofone mit Röhrenverstärkern erfreuen sich nach wie vor großer Beliebtheit. Ihr Klang wird als<br />

warm <strong>und</strong> druckvoll beschrieben. Viele Toningenieure ziehen oft Mikrofone in dieser traditionellen<br />

Technologie modernen Transistormikrofonen vor, obwohl Röhrenmikrofone aus messtechnischer<br />

Sicht ein höheres Eigenrauschen <strong>und</strong> ein schlechteres Großsignalverhalten besitzen.<br />

In der Studienarbeit von Herrn Peter Vanselow wurde untersucht, ob die subjektiv empf<strong>und</strong>enen Qualitätsunterschiede<br />

zwischen Röhren- <strong>und</strong> Transistormikrofon allein durch die unterschiedlichen nichtlinearen<br />

Übertragungseigenschaften erklärt werden können.<br />

Dazu wurden mit der Software MATLAB Audiosignale, die mit Messmikrofonen aufgenommenen<br />

wurden, mit den nichtlinearen Kennlinien von Elektronenröhren <strong>und</strong> Ausgangstransformatoren „verzerrt“<br />

<strong>und</strong> durch Hörversuche subjektiv beurteilt.<br />

Die Ergebnisse zeigen, dass Unterschiede von den Versuchspersonen erst bei sehr hohen Schalldruckpegeln<br />

festgestellt werden konnten. In einigen Fällen wirkten sich die nichtlinearen Kennlinien<br />

als Qualität steigernd aus. Besonders der quadratische Anteil der Röhrenkennlinie führte in einigen<br />

Fällen zu einer höheren Audioqualität. Dagegen führten die kubischen Signalanteile, die besonders<br />

durch den Ausgangstransformator erzeugt wurden, immer zu einer Verschlechterung der Audioqualität.<br />

23

24<br />

Forschungsbericht<br />

3.3.4 Untersuchungen zur Signalseparation für Zweikanalmikrofone<br />

Die Separation von Signalen aus einem Signalgemisch ist ein Gr<strong>und</strong>problem der gesamten Audiotechnik.<br />

Die Spracherkennung fordert für eine gute Erkennungsrate ein möglichst reines Sprachsignal<br />

ohne Störgeräusche oder gar andere Stimmen, welche sich mit dem zu erkennendem Signal überlagern.<br />

In der Studienarbeit von Herrn Kevin Gebhardt wurden verschiedene Algorithmen zur Signaltrennung<br />

unter Verwendung von zweikanaligen TWIN- Mikrofonen getestet. Die Signaltrennung erfolgte stets<br />

im Frequenzbereich. Mittels zweikanaliger FFT <strong>und</strong> Overlapp-Add wurden einzelne Signalabschnitte in<br />

ihre spektralen Komponenten zerlegt <strong>und</strong> entsprechend der Richtungsinformationen, die aus den<br />

Unterschieden beider Signale gewonnen wurden, bewertet.<br />

Durch gezielte Generierung von Nullstellen in der Richtcharakteristik des Summensignals beider Mikrofone<br />

konnten die Signale einzelner diskreter Störsignalquellen fast vollständig eliminiert werden.<br />

Bei Existenz von vielen gleichzeitigen Störsignalquellen im seitlichen <strong>und</strong> hinteren Schalleinfallsbereich<br />

des Mikrofons brachte eine spektrale Trennung der Schallanteile gute Erfolge. Besonders gute<br />

Ergebnisse konnten dann erzielt werden, wenn sich die Spektren von Nutz- <strong>und</strong> Störsignal deutlich<br />

unterschieden.<br />

3.4 Anwendungen von Sprachtechnologie in<br />

Interaktionsforschung <strong>und</strong> Didaktik<br />

3.4.1 Überblick<br />

Sprachtechnologiekomponenten der TU <strong>Dresden</strong> werden zunehmend bei Problemstellungen der<br />

Mensch-Mensch- bzw. Mensch-Technik-Interaktion erprobt, wobei eine interdisziplinäre Kooperation<br />

mit Kollegen aus nichttechnischen Wissenschaftsgebieten zum Tragen kommt.<br />

Die vorgestellten Forschungsarbeiten folgen internationalen Ansätzen aus den 1990er Jahren <strong>und</strong><br />

einem aktuellen Trend, der sich u. a. in neu kreierten sowie hochrangig besetzten Veranstaltungsreihen,<br />

wie z. B. ISCA Workshops on Speech and Language Technology in Education (SLaTE 2007 <strong>und</strong><br />

2009) oder ICMI Workshops on Child, Computer and Interaction (WOCCI 2008 <strong>und</strong> 2009) manifestiert,<br />

bei denen das <strong>IAS</strong> mit Beiträgen präsent war. Wie in den Vorjahren wirkte das <strong>IAS</strong> außerdem an<br />

der europäischen COST-Aktion 2102 (Cross-Modal Analysis of Verbal and Non-verbal Communication)<br />

einschließlich der Workshops mit.<br />

Der Berichtszeitraum 2009 umfasste folgende Aktivitäten, die in den Unterabschnitten 3.4.2 –3.4.7<br />

dargestellt werden:<br />

• Fortführung der Forschungs- <strong>und</strong> Entwicklungsarbeiten für den Aussprachetrainer („Automat<br />

zur Akzentreduktion“, Akronym AzAR). Das AzAR-Projekt markierte 2004 den Auftakt für unser<br />

neues Arbeitsfeld, wobei die im Berichtszeitraum laufende, dritte Projektphase im Rahmen<br />

des EU-Projekts EURONOUNCE (2007-2009) gefördert wurde <strong>und</strong> auf slawische sowie<br />

deutsche Sprachressourcen fokussiert war.<br />

• Erweiterung der Aussprachetrainertechnologie auf die Zielgruppe Vorschulkinder <strong>und</strong> Fertigstellung<br />

des 2008 begonnenen LiSA-Prototyps. Start des EXIST-Projekts „Innovative Produkte<br />

zur Förderung der kindlichen Sprachkompetenz“ (BMWT). Im Rahmen des neuen Projekts<br />

werden u. a. die Robustheit des Sprachinterfaces, das Nutzerverhalten sowie Markteintrittsbarrieren<br />

untersucht.<br />

• Fortsetzung der Kooperationsbeziehungen zum Sprachtrainingsprojekt der Beuth-Hochschule<br />

Berlin (Prof. Mixdorff). Unter der Bezeichnung CALL (Computer-Aided Language Learning)<br />

wird Sprachtechnologie im Kontext des Fremdsprachenerwerbs von Mandarin-Chinesisch untersucht.<br />

Ein weiteres Teilprojekt betrifft eine sprachübergreifende Prosodiemodellierung in<br />

Zusammenarbeit mit japanischen <strong>Universität</strong>en (Quantitative Cross-Language Prosody Modeling).<br />

• Fortführung des Projekts zur Untersuchung prosodischer Beeinträchtigungen bei Dysarthrien,<br />

die durch das Parkinson-Syndrom hervorgerufen werden. Dieses Projekt wird seit 2008 durch<br />

Frau Dr. Ma im Rahmen ihres Humboldt-Stipendiums betreut <strong>und</strong> erfolgt in Kooperation mit<br />

der Klinik <strong>und</strong> Poliklinik für Neurologie des <strong>Universität</strong>sklinikums <strong>Dresden</strong> (Prof. Storch).

Forschungsbericht<br />

3.4.2 Euronounce/ Intelligent Pronunciation Tutoring System<br />

Gefördert von der Europäischen Kommission, Agentur für Kultur, Bildung <strong>und</strong> audiovisuelle Medien<br />

(EACEA) im Rahmen des Programms Lebenslanges Lernen<br />

Projektnummer: 135379-LLP-1-2007-1-DE-KA2-KA2MP<br />

Subprogramm: KA2, Languages<br />

Förderzeitraum: 01.11.2007 – 31.12.2009<br />

Partner: TU <strong>Dresden</strong>, Institut für Akustik <strong>und</strong> Sprachkommunikation (Projektkoordinator)<br />

Adam-Mickiewicz-<strong>Universität</strong> Poznan, Institut für Linguistik<br />

Slowakische Akademie der Wissenschaften in Bratislava, Institut für Informatik<br />

REZO Computer Service GmbH & Co. KG<br />

Schenck Workshops Mülheim/ Ruhr (für Goethe-Institut <strong>Dresden</strong>/ Weimar)<br />

Verband der Sächsischen Bildungsinstitute (VSBI)<br />

Private Fachoberschule <strong>und</strong> Berufsfachschule Roudnice nad Labem, CZ<br />

Nachauftragnehmer:<br />

VoiceInterConnect GmbH <strong>Dresden</strong><br />

Institut für Informatik <strong>und</strong> Automatisierung der Russischen Akademie der Wissenschaften<br />

St. Petersburg (SPIIRAS)<br />

Arbeitsschwerpunkte im Jahr 2009<br />

1. Fertigstellung der multilingualen Datenbasen<br />

Wichtigstes Projektziel ist die Entwicklung eines datenbasierten multilingualen Aussprachetrainers,<br />

der für die Sprachenpaare Deutsch-Russisch, Deutsch-Polnisch, Deutsch-Slowakisch <strong>und</strong> Deutsch-<br />

Tschechisch Curricula <strong>und</strong> Feedbacktechnologie zur Bewertung der Aussprachequalität bereitstellen<br />

soll.<br />

Datenbasen sind insbesondere die Entwicklungs- <strong>und</strong> Trainingsdaten, Testdaten <strong>und</strong> Curriculardaten.<br />

Pro Sprachenpaar wurden jeweils 18 Sprecherinnen/ Sprecher mit nach Niveaustufen (A1 – B1, B2 –<br />

C2 des Europäischen Referenzrahmens) variierendem Testmaterial aufgenommen. Z. B. wurden für<br />

die Zielsprache Deutsch zur Erzeugung der Analyse-, Trainings- <strong>und</strong> Testdaten folgende Subkorpora<br />

aufgezeichnet: Veith-Test (140 Sätze <strong>und</strong> Wortgruppen), PhonDat - Lesetest (293 phonetisch ausgewogene<br />

Sätze <strong>und</strong> zwei Textpassagen), Akzenttest (175 phonetisch reiche Sätze), Prosodietest (119<br />

Sätze), Lesetext: H. Chr. Andersen, „Das Feuerzeug“ (ca. 1800 Dz.), Teststimuli zur Erzeugung spontaner<br />

Äußerungen (freies Interpretieren idiomatischer Redewendungen) sowie ein Interview zur Lernbiografie<br />

der Sprecherin. Zusätzlich wurden Referenzaufnahmen mit Muttersprachlern zur Entwicklung<br />

der HMM-basierten Aligner-Technologie sowie für die Integration der Curriculardaten in die Lernanwendung<br />

realisiert.<br />

2. Annotierung der Sprachaufzeichnungen, automatisches Alignieren der Phonem- <strong>und</strong> Wortlabel<br />

2.1 Inventare<br />

Die applikative Ausrichtung des Projektes erfordert die Erzeugung akustisch-phonetischer Korpora, die<br />

geeignet sind, interlinguale Effekte systematisch zu erfassen, die im Prozess der Aneignung einer<br />

Fremdsprache mit hoher interpersoneller Konstanz auftreten. Unter dem speziellen Aspekt der Abbildung<br />

systembedingter Interferenzen wurden zunächst Annotierungsstandards erarbeitet, die die Vergleichbarkeit<br />

der Ergebnisse für die betrachteten Sprachenpaare (Source /L1/, Target /L2/) garantieren<br />

sollen. Für jedes Sprachenpaar wurde ein gemischtes X-SAMPA – Inventar erstellt, das eine wechselseitige<br />

Zuordnung der Phoneme auf der Basis kategorialer Merkmale ermöglicht. Bereits aus der Kontrastierung<br />

der Phoneminventare sind Kandidaten für Segmentsubstitutionen erkennbar.<br />

25

26<br />

Forschungsbericht<br />

Abbildung 3. 13: Auszug aus dem gemischten Lautinventar für das Sprachenpaar Tschechisch –<br />

Deutsch. Die tschechischen silbischen Sonoranten /=l/, /=m/ <strong>und</strong> /=r/, das labio-dentale /F/ (Allophon<br />

von /m/) <strong>und</strong> der palatale Nasal /J/ haben im Deutschen Inventar keine Entsprechungen.<br />

2.2 Symbolische Repräsentation segmenteller Aussprachefehler<br />

Ein Teil der regelmäßig auftretenden Abweichungen von der zielsprachlichen Aussprache-norm kann<br />

in die Segmentebene (Phoneme, Allophone) projiziert werden. Es handelt sich dabei einerseits um<br />

Substitutionen <strong>und</strong> Indels (Einfügungen oder Löschungen von Segmenten), andererseits um Verletzungen<br />

der Distributions- <strong>und</strong> Verkettungsregeln über bestimmte Segmente, die in der Oberflächenform<br />

als segmentelle Abweichungen auffallen. Für die Zwecke der Annotierung L1 – bedingter Abweichungen<br />

von der Standardlautung wurde die von Bonaventura, Howarth <strong>und</strong> Menzerath (Bonaventura,<br />

Howarth & Menzel: 2000 1 , 2000 2 ) vorgeschlagene Prozedur modifiziert. In einem ersten Schritt<br />

wurden die Aufzeichnungen (Teilkorpora Veith-Sätze, Veith-Wortgruppen <strong>und</strong> Akzenttest) automatisch<br />

segmentiert. Die Phonemlabel wurden entsprechend der für die Zielsprache vereinbarten kanonischen<br />

Transkription mithilfe des vicAligners zugeordnet <strong>und</strong> anschließend in der Datenbank-<br />

Entwicklungsumgebung WiGE manuell angepasst. In einem weiteren Schritt wurden die auffälligen<br />

Segmente markiert. Dabei kommen folgende Fallentscheidungen in Betracht: (1) das auffällige Segment<br />

entspricht einer Einheit des muttersprachlichen Inventars, (2) das auffällige Segment repräsentiert<br />

einen Übergangszustand, ist aber einem zielsprachlichen Segment hinreichend ähnlich. Im ersten<br />

Fall wird das entsprechende Phonemsymbol aus dem L1-Inventar verwendet. Im Fall der Übereinstimmung<br />

der SAMPA-Symbole erhält das Label ein Suffix. Da zu beobachtende Interferenzen häufig<br />

in einem breiten Spektrum variieren (wie z. B. die Ersetzungen der Frikative /x-C/, /h/ <strong>und</strong> der vorderen<br />

labialen Vokale /y:/, Y/, /2:/, /9/ bei Sprechern mit russischem Akzent), musste eine pragmatische Lösung<br />

gef<strong>und</strong>en werden. Alle auftretenden Varianten werden aufgr<strong>und</strong> des Höreindrucks entweder<br />

einem muttersprachlichen oder einem zielsprachlichen Phonem zugeordnet.

Forschungsbericht<br />

Neben den Substitutionen treten Einfügungen (z. B. /j/ nach hohen vorderen Vokalen) <strong>und</strong> Löschungen<br />

von Segmenten sowie segmentübergreifende Fehler auf (Kontaktassimilation, Kontrahierung<br />

benachbarter Segmente bzw. Vereinfachung von Konsonantenclustern, die i. d. R. L1-spezifischen<br />

Mustern folgen).<br />

Model Inventory for the notation of mispronunciation-hypotheses<br />

• target language phonemes:<br />

standard-notation as given in the target language model set (phoneme-set)<br />

• source language phonemes:<br />

notation as given in the source language model set (phoneme-set) but expanded by the suffix<br />

„<strong>und</strong>erscore one“ '_1'<br />

e.g. 'r_1', 'd^z'_1'<br />

• sample for the notation of mispronunciation-hypotheses<br />

text: der Aal das All<br />

transcription: d e 6 {a: l; a:-a l} d a s {a l; a-a_1 l-l_1; a-a: l; a l -@}<br />

Abbildung 3. 14: Konventionen zur Fehlernotation (VoiceInterConnect, 07/28/2009)<br />

Wenn ein Sprecher ein Segment eingefügt hat, z. B. wenn das Wort sehen als „sej*en“ ausgesprochen<br />

wurde, ist die Transkription /z|e:-E:|-j| @-e_5|n/.<br />

Wurde dagegen ein Phonem, das in der Standardtranskription enthalten ist, vom Sprecher nicht realisiert<br />

(Elision), z. B. Kunstgewerbe als „Kuns*gewerbe“, wurde /k |u_5| n |s-z |–t |g |@-i_5|v|E|6-r_5|b|@/<br />

annotiert.<br />

Abbildung 3. 15: Fehlernotation in Wafesurfer-Labelspur (Sequenz „gewusst haben willst“, Index 5<br />

entspricht L1 RU)<br />

Ein Teil der Aufnahmen wurde im Praat-TextGrid-Format annotiert. Dabei erfolgte die Markierung der<br />

abweichenden Segmente in einer Kopie der kanonischen Labelspur durch Einsetzen der L1spezifischen<br />

Label.<br />

27

28<br />

Forschungsbericht<br />

Abbildung 3. 16: Fehlernotation in Praat-TextGrid (Substitution von /N/ durch /N/ + /g/ in der Wortform<br />

„klingelte“)<br />

Die annotierten Korpora wurden einer kontrastiven Untersuchung unterzogen. Für jede Richtung innerhalb<br />

eines Sprachenpaares wurden die im Laufe der Aneignung der Zielsprache regulär auftretenden<br />

Fehlermuster in den Datenkorpora identifiziert, phonologisch beschrieben <strong>und</strong> klassifiziert.<br />

Die Trainingsdaten für die Entwicklung akustischer Modelle wurden entsprechend den Spezifikationen<br />

in Form kanonisch annotierter Aufnahmen im Format 16 kHz/ 44.1 kHz, 16 bit, PCM, little endian,<br />

bereitgestellt.<br />

3. Implementierung, Entwicklung der Feedback-Funktionen<br />

Mit dem Erkennertraining wurden die Partner VoiceInterConnect GmbH <strong>und</strong> SPIIRAS (Institut für beauftragt.<br />

Der HMM – basierte Phonemerkenner wurde an muttersprachlichen Daten trainiert. Das<br />

Nutzerfeedback wird aus den Konfidenzmaßen des Aligners generiert. Der Aligner segementiert das<br />

akustische Eingangssignal <strong>und</strong> labelt die Segmente in Übereinstimmung mit der erwarteten bzw. –<br />

bei Vorliegen von Alternativen – der wahrscheinlichsten Phonemfolge. Das akustische Feedbacksystem<br />

wertet sowohl den Output des Aligners als auch gr<strong>und</strong>legende Parameter des Eingangssignals<br />

aus. Die Erzeugung des korrektiven Feedbacks in der Lernapplikation basiert neben dem automatisch<br />

erzeugten akustischen Feedback auf phonetisch-phonologischem bzw. didaktischem Wissen. Das<br />

Feedbacksystem ist in der Lage, Aussprachealternativen zu unterscheiden, die im Sprachmodell hinterlegt<br />

sind. Für die innerhalb der einbezogenen Sprachenpaare (L1-L2) systematisch auftretenden<br />

Aussprachefehler wurden akustische Modelle trainiert <strong>und</strong> Transkriptionen nach einem im Rahmen<br />

des Projekts EURONOUNCE entwickelten Notationssystem codiert.<br />

Weitere Feedback-Funktionen der im Projekt EURONOUNCE verwendeten Testplattform Azar3.0 sind<br />

eine interaktive Formant-Target-Chart,<br />

4. Datenbankeditor, Datenbank-Infrastruktur<br />

Der von dem Partner REZO Computer Service entwickelte Datenbankeditor ermöglicht den Remote -<br />

Zugriff auf Curriculardaten, Tutorials <strong>und</strong> visuelle Inhalte, insbesondere das Eingeben, Editieren <strong>und</strong><br />

Verwalten aller Inhaltskomponenten. Die Autoren der Inhaltskomponenten legen Navigationsstrukturen<br />

an, ordnen den Themenbereichen Übungen zu <strong>und</strong> transferieren die Inhaltsdaten auf den Projektserver.<br />

Im Datenbankeditor werden mithilfe eines Wörterbuchs die kanonischen SAMPA - Transkriptionen<br />

ausgegeben <strong>und</strong> ggf. vom Autor editiert. Aus der Datenbank können Leselisten erstellt werden,

Forschungsbericht<br />

die in der Entwicklungsumgebung WiGE (VoiceInterConnect) weiter verarbeitet werden. Dabei bleiben<br />

die in der Datenbank angelegten Satznummern bzw. Indizes erhalten. Die in WiGE-rec erhaltenen<br />

Referenzaufnahmen im wav-Format <strong>und</strong> die in WiGE-align automatisch erzeugten (<strong>und</strong> ggf. manuell<br />

korrigierten) Labeldateien im Lab-Format werden zur Datenbank transferiert. Aus den Daten wird ein<br />

codierter Datenstream generiert, der in die Lernanwendung eingelesen wird.<br />

Abbildung 3. 17: Navigationsstruktur (1. <strong>und</strong> 2. Ebene) des Curriculums „Speech training L1 PL - L2<br />

DE“ in der Editoransicht.<br />

5. Contententwicklung, Curricula, Tutorials<br />

Für jede Sprachversion wurde ein Beispielcurriculum bereitgestellt, das eine systematische Einführung<br />

in das Lautsystem der Zielsprache, einen Übungsteil zu den Bereichen Lautsystem, Silben- <strong>und</strong><br />

Wortprosodie (Silbenstrukturen, prosodische Wortformen <strong>und</strong> Betonungsregeln), Sprechrhythmus<br />

<strong>und</strong> Satzintonation beinhaltet. Ausgehend von den im Ergebnis der Analyse repräsentativer Teile der<br />

Sprachkorpora ermittelten Interferenzen wurden spezifische Aufgaben für Lernende mit den Muttersprachen<br />

Tschechsisch, Plnisch, Slowakisch <strong>und</strong> Russisch aufgenommen. Für die Zielsprache<br />

Deutsch wurde zusätzlich ein kommunikativ orientiertes Curriculum mit dem Titel „Phonetik-Theater“<br />