1.2 Garbage-Collection

1.2 Garbage-Collection

1.2 Garbage-Collection

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

Fachbereich Informatik<br />

Integrierte Schaltungen und Systeme<br />

Prof. Dr.-Ing. Sorin Huss<br />

Diplomarbeit<br />

Entwicklung eines Gargbage-Collectors für<br />

rekonfigurierbare Hardwarestrukturen<br />

Felix Madlener<br />

madlener@iss.tu-darmstadt.de<br />

Matr.-Nr.: 948463<br />

Betreuer : Dipl.-Inform. Andreas Kühn<br />

Abgabe : 8.6.2005

Zusicherungen zur Diplomarbeit gemäß §19 Abs. 6 der<br />

Diplomprüfungsordung<br />

Hiermit versichere ich, die vorliegende Diplomarbeit ohne Hilfe Dritter nur mit den<br />

angegebenen Quellen und Hilfsmitteln angefertigt zu haben. Alle Stellen, die aus Quellen<br />

entnommen wurden, sind als solche kenntlich gemacht worden. Diese Arbeit hat in<br />

gleicher oder ähnlicher Form noch keiner Prüfungsbehörde vorgelegen.<br />

Darmstadt, den 8.6.2005<br />

Felix Madlener

Inhaltsverzeichnis<br />

Abbildungsverzeichnis<br />

v<br />

1 Einleitung 1<br />

1.1 Motivation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1<br />

<strong>1.2</strong> <strong>Garbage</strong>-<strong>Collection</strong> . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3<br />

1.3 Überblick . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3<br />

2 Begriffe und Strukturen 5<br />

2.1 Konfigurationsmöglichkeiten eines FPGA . . . . . . . . . . . . . . . . 5<br />

2.2 Objektorientierte Konzepte . . . . . . . . . . . . . . . . . . . . . . . . 6<br />

2.3 Strukturierung der Hardware . . . . . . . . . . . . . . . . . . . . . . . 8<br />

2.3.1 Layer 1: Logik-Ebene . . . . . . . . . . . . . . . . . . . . . . 8<br />

2.3.2 Layer 2: Struktur-Ebene . . . . . . . . . . . . . . . . . . . . . 9<br />

2.3.3 Layer 3: Protokolle . . . . . . . . . . . . . . . . . . . . . . . . 11<br />

2.3.4 Layer 4: Middleware . . . . . . . . . . . . . . . . . . . . . . . 11<br />

2.3.5 Layer 5: Applikation . . . . . . . . . . . . . . . . . . . . . . . 12<br />

2.3.6 Layer 6: SW-Engineering . . . . . . . . . . . . . . . . . . . . 12<br />

2.4 Beispiel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13<br />

2.5 Vereinfachte Repräsentation eines Programms . . . . . . . . . . . . . . 13<br />

3 <strong>Garbage</strong>-<strong>Collection</strong> in Software 17<br />

3.1 Statische Reservierung . . . . . . . . . . . . . . . . . . . . . . . . . . 18<br />

3.2 Explizite Reservierung . . . . . . . . . . . . . . . . . . . . . . . . . . 19<br />

3.3 Referenzzählung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19<br />

3.4 Mark-Sweep <strong>Collection</strong> . . . . . . . . . . . . . . . . . . . . . . . . . . 20<br />

3.5 Erweiterungen der Mark-Sweep-<strong>Collection</strong> . . . . . . . . . . . . . . . 21<br />

3.5.1 Fragmentierung . . . . . . . . . . . . . . . . . . . . . . . . . . 21<br />

3.5.2 Nebenläufigkeit . . . . . . . . . . . . . . . . . . . . . . . . . . 22<br />

3.5.3 Generational <strong>Collection</strong> . . . . . . . . . . . . . . . . . . . . . 23

iv<br />

INHALTSVERZEICHNIS<br />

4 <strong>Garbage</strong>-<strong>Collection</strong> in Hardware 25<br />

4.1 Einordnung der <strong>Garbage</strong>-<strong>Collection</strong> . . . . . . . . . . . . . . . . . . . 26<br />

4.2 Traversierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27<br />

4.3 Fragmentierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 31<br />

4.4 Nebenläufigkeit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32<br />

4.5 Generational <strong>Collection</strong> . . . . . . . . . . . . . . . . . . . . . . . . . . 34<br />

4.6 Der Algorithmus der Hardware-<strong>Garbage</strong>-<strong>Collection</strong> (HW-GC) . . . . . 34<br />

5 Analyse des HW-GC-Algorithmus 39<br />

5.1 Objektstruktur . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 40<br />

5.2 Softwarebasiertes Simulationsmodell . . . . . . . . . . . . . . . . . . . 41<br />

5.3 Qualitative Betrachtung . . . . . . . . . . . . . . . . . . . . . . . . . . 45<br />

5.3.1 Warten auf den nächsten <strong>Garbage</strong>-<strong>Collection</strong>-Zyklus . . . . . . 46<br />

5.3.2 Die Traversierung im Mark-Prozess . . . . . . . . . . . . . . . 47<br />

5.3.3 Der Sweep-Prozess . . . . . . . . . . . . . . . . . . . . . . . . 48<br />

5.3.4 Funktionalität des HW-GC-Algorithmus . . . . . . . . . . . . . 49<br />

5.4 Quantitative Betrachtung . . . . . . . . . . . . . . . . . . . . . . . . . 49<br />

5.4.1 Laufzeit der Traversierung . . . . . . . . . . . . . . . . . . . . 50<br />

5.4.2 PageMiss . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 52<br />

5.5 Häufigkeit der GC-Zyklen . . . . . . . . . . . . . . . . . . . . . . . . 55<br />

6 Zusammenfassung 57<br />

6.1 Ergebnisse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 57<br />

6.2 Ausblick . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 58<br />

Literaturverzeichnis 59

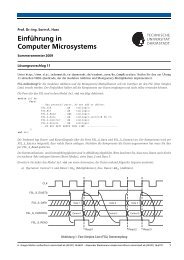

Abbildungsverzeichnis<br />

1.1 Flexibilität und Effizienz bei verschiedenen Architekturen . . . . . . . . 2<br />

2.1 Abstraktionsebenen der Entwurfsmethodik . . . . . . . . . . . . . . . . 9<br />

2.2 Struktur eines Virtex2 Pro FPGA . . . . . . . . . . . . . . . . . . . . . 10<br />

2.3 Schematischer Aufbau eines Objekts und der Computing Page . . . . . 12<br />

2.4 Programmablauf und Objektgraph . . . . . . . . . . . . . . . . . . . . 15<br />

3.1 Inkorrekter Objektgraph bei nebenläufiger <strong>Garbage</strong>-<strong>Collection</strong> . . . . . 23<br />

4.1 Traversierungsreihenfolge eines Objektgraphen mit sequenzieller Traversierung<br />

mit Tiefensuche (a) und nebenläufiger Traversierung (b) . . . 28<br />

4.2 Lokalisierter Bus zur <strong>Garbage</strong>-<strong>Collection</strong> . . . . . . . . . . . . . . . . 29<br />

4.3 Ablauf einer Traversierung im HW-GC-Algortihmus . . . . . . . . . . 30<br />

4.4 Algorithmus zur Hardware-<strong>Garbage</strong>-<strong>Collection</strong> in VHDL-Pseudocode . 37<br />

5.1 Objektgraphen mit verschiedener Anzahl an ausgehenden Kanten . . . 43<br />

5.2 Minimaler aufspannender Graph . . . . . . . . . . . . . . . . . . . . . 44<br />

5.3 Erreichbare Knoten in Zufallsgraphen . . . . . . . . . . . . . . . . . . 45<br />

5.4 Verschiedene Traversierungen . . . . . . . . . . . . . . . . . . . . . . 52<br />

5.5 Neuer Objektgraph nach löschen der Kante a) zum Zeitpunkt 5 . . . . . 53<br />

5.6 Neuer Objektgraph nach löschen der Kante b) zum Zeitpunkt 4 . . . . . 53

Kapitel 1<br />

Einleitung<br />

1.1 Motivation<br />

Ziel dieser Arbeit ist der Entwurf eines Verfahrens zur automatischen Speicherverwaltung<br />

(<strong>Garbage</strong>-<strong>Collection</strong>). Diese Speicherverwaltung ist Teil eines neuartigen, objektorientierten<br />

Entwicklungsansatzes für rekonfigurierbare Hardwarestrukturen.<br />

Herkömmliche Hardware ist statisch aufgebaut. Das Logikdesign und damit auch die<br />

Funktionalität müssen bereits bei der Produktion des entsprechenden Chips vollständig<br />

definiert sein. Die Funktionalität einer solchen Architektur kann dann nicht mehr<br />

geändert werden. Dynamische Strukturen und Programme, wie sie im Bereich der Softwareentwicklung<br />

üblich sind, lassen sich somit nicht direkt in einer effizienten Hardwarestruktur<br />

abbilden.<br />

Üblicherweise können vor allem datenflussintensive, aber in ihrer Funktionalität statische<br />

Programme, von den Vorteilen einer Hardwareimplementierung profitieren. Solche<br />

Vorteile sind beispielsweise eine höhere Ausführungsgeschwindigkeit und ein geringerer<br />

Stromverbrauch. Kontrollflussintensive Algorithmen erfordern hingegen die Flexibilität<br />

eines generischen Prozessors mit darauf ablaufenden Programmen.<br />

Mit der Entwicklung von dynamisch rekonfigurierbaren Hardwarestrukturen, wie zum<br />

Beispiel dem Field Programmable Gate Array (FPGA), ist es erstmals möglich auch<br />

in Hardwareimplementierungen dynamische Strukturen umzusetzen. Die Funktionalität<br />

eines FPGAs wird durch seine Konfiguration festgelegt. Sie kann beliebig modifiziert<br />

werden, indem man das FPGA mit einem vorher generierten Datenstrom rekonfiguriert.<br />

Darüberhinaus bieten FPGAs die Möglichkeit zur partiellen Rekonfiguration. Während<br />

bei einer normalen Rekonfiguration immer der gesamte Chip beeinflusst wird, erlaubt<br />

es die partielle Rekonfiguration, nur einzelne Teile des Logikdesigns im laufenden<br />

Betrieb auszutauschen. Der übrige Chip kann dabei ohne Unterbrechung weiterlaufen.<br />

Wie in Abbildung 1.1 veranschaulicht, sind diese dynamisch rekonfigurierbaren Strukturen<br />

in Bezug auf Flexibilität und Effizienz zwischen den flexiblen, aber ineffizienten

2 KAPITEL 1. EINLEITUNG<br />

Software<br />

Flexibilität<br />

Rekonfigurierbare Hardware<br />

Effizienz<br />

Hardware<br />

Abbildung 1.1: Flexibilität und Effizienz bei verschiedenen Architekturen<br />

Softwareprogrammen und den statischen, aber effizienten Hardwareimplementierungen<br />

angeordnet.<br />

Um diese Architektur sinnvoll einzusetzen, ist neben der Verfügbarkeit der Hardware<br />

auch eine Entwurfsmethodik notwendig, die es ermöglicht, die Vorteile der Plattform<br />

voll auszunutzen und umzusetzen.<br />

Die bisherigen Entwurfsmethodiken für dynamisch rekonfigurierbare Strukturen basieren<br />

auf einer Erweiterung der Werkzeuge und Konzepte, wie sie für klassische Hardware<br />

zum Einsatz kommen. Ihre Ausgangsbasis ist also ein effizienter Entwurfsprozess,<br />

der in Bezug auf die Flexibilität jedoch stark eingeschränkt ist. Mit diesen Werkzeugen<br />

können, aufgrund ihrer völlig anderen konzeptionellen Ausrichtung, die Möglichkeiten<br />

zur Flexibilität nicht zufriedenstellend umgesetzt werden.<br />

Diese Arbeit ist Teil eines Projekts zur Entwicklung einer Entwurfsmethodik, die versucht<br />

Konzepte zur Softwareentwicklung auf dynamisch rekonfigurierbare Strukturen<br />

abzubilden. Der schematischen Einordnung aus Abbildung 1.1 folgend, wird also nicht<br />

mehr ein hardwarenaher Entwurfsansatz um Rekonfigurationsmöglichkeiten erweitert,<br />

sondern Ansätze zur flexiblen Entwicklung von Software werden auf dynamisch und<br />

partiell rekonfigurierbare Strukturen übertragen.<br />

Als besonders geeignet hat sich hierfür der objektorientierte Entwicklungsansatz [1]<br />

erwiesen.

<strong>1.2</strong>. GARBAGE-COLLECTION 3<br />

<strong>1.2</strong> <strong>Garbage</strong>-<strong>Collection</strong><br />

Im Rahmen dieser Diplomarbeit wird untersucht, wie gut sich die <strong>Garbage</strong>-<strong>Collection</strong> als<br />

wichtiges Element einer objektorientierten Entwurfsmethodik in dynamisch rekonfigurierbare<br />

Hardwarestrukturen übertragen lässt. Unter <strong>Garbage</strong>-<strong>Collection</strong> versteht man<br />

eine automatische Verwaltung von verfügbaren Hardwareressourcen, die durch Rekonfiguration<br />

die vom Benutzer gewünschte Funktionalität annehmen können. Die <strong>Garbage</strong>-<br />

<strong>Collection</strong> soll auf bewährten Konzepten und Algorithmen aus dem Softwareentwurf<br />

basieren und sich in das Gesamtprojekt zur Entwicklung einer objektorientierten Entwurfsmethodik<br />

für Hardware integrieren.<br />

Neben der Analyse allgemeiner Eigenschaften einer <strong>Garbage</strong>-<strong>Collection</strong> für Hardware<br />

soll eine konkrete Implementierung auf FPGAs der Firma Xilinx zur Evaluation dienen.<br />

Außerdem wird untersucht, welche allgemeinen Richtlinien und Eigenschaften sich für<br />

die Konvertierung einer Applikation aus Software in eine hardwarenahe Applikation<br />

finden lassen.<br />

1.3 Überblick<br />

In Kapitel 2 wird vorgestellt, wie sich objektorientierte Konzepte in einen hardwarebasierten<br />

Entwurfsansatz übertragen lassen. Es wird auf die Rahmenbedingungen der<br />

Hardware eingegangen und ein Abstraktionsmodell vorgestellt, das in den Entwurfsmethodiken<br />

verwendet wird.<br />

In Kapitel 3 werden die bestehenden Konzepte und Ansätze zur Speicherverwaltung<br />

analysiert. Ein Schwerpunkt dieser Analyse ist der Mark-Sweep-Algorithmus, der sich<br />

als günstigste Ausgangsbasis für eine <strong>Garbage</strong>-<strong>Collection</strong> in Hardware erwiesen hat.<br />

In Kapitel 4 wird beschrieben, wie sich die einzelnen Aspekte der <strong>Garbage</strong>-<strong>Collection</strong><br />

in Hardware abbilden lassen. Es wird erläutert, welche Konzepte übernommen werden<br />

können und inwieweit sie abgeändert werden müssen, um eine effiziente und kompakte<br />

Hardwareimplementierung zu gestatten. Die dabei entwickelten Algorithmen werden<br />

vorgestellt und erläutert.<br />

Kapitel 5 analysiert die gewonnen Algorithmen. Es wird ein informeller Beweis für die<br />

Korrektheit angegeben und versucht allgemeine Aussagen und Metriken für die Leistungsfähigkeit<br />

einer <strong>Garbage</strong>-<strong>Collection</strong> anzugeben.<br />

Schließlich liefert Kapitel 6 eine kurze Zusammenfassung der Ergebnisse dieser Arbeit<br />

und weist auf offene Fragestellungen und Optimierungspotenziale hin.

4 KAPITEL 1. EINLEITUNG

Kapitel 2<br />

Begriffe und Strukturen<br />

In diesem Kapitel wird die allgemeine Struktur der Hardware vorgestellt, in welcher<br />

die <strong>Garbage</strong>-<strong>Collection</strong> eingebettet ist. Es wird erläutert, wie sich die objektorientierten<br />

Konzepte auf diese Plattform abbilden lassen.<br />

Die existierenden, rekonfigurierbaren Strukturen sind nicht auf die speziellen Eigenschaften<br />

solcher Entwicklungsmethodiken ausgelegt. Um ein System sinnvoller Größe<br />

zu realisieren, ist es deshalb nötig, die Gegebenheiten der vorhandenen Hardware optimal<br />

auszunutzen. Die wesentlichen Teile dieser Konzepte beruhen auf den Arbeiten von<br />

Kühn [2].<br />

2.1 Konfigurationsmöglichkeiten eines FPGA<br />

Als dynamisch rekonfigurierbare Plattform kommt das FPGA Virtex2 Pro V2P30 der<br />

Firma Xilinx zum Einsatz. Die Konfiguration dieser FPGAs basiert auf den Methoden<br />

der klassischen Hardwarewicklung, wie sie auch beim Entwurf von integrierten Schaltungen<br />

zum Einsatz kommen. Zunächst erfolgt ein Logikentwurf in einer abstrakten<br />

Hardwarebeschreibungssprache wie VHDL oder Verilog. Durch Simulation lassen sich<br />

diese Beschreibungen auf hoher Abstraktionsebene evaluieren. Mit Hilfe eines Synthesewerkzeugs<br />

wird aus der Hardwarebeschreibung eine logische Netzliste generiert.<br />

Hierzu kam das Programm Synplify Pro 8.0 der Firma Synplicity [7] zum Einsatz. Diese<br />

Netzliste wird mit herstellerspezifischen Entwicklungstools (Xilinx ISE 6.3 [5]) auf<br />

dem FPGA platziert und verdrahtet. Dabei entsteht ein Bitstream-File. Dieser Bitstream<br />

wird auf das FPGA geladen, das somit konfiguriert ist.<br />

Um nur Teile des FPGAs partiell zu konfigurieren, existieren zwei verschiedene Entwurfswege.<br />

Beide basieren auf dem Entwurfsprozess zur Konfiguration des gesamten<br />

FPGAs. Der “Small Bit Manipulation Design Flow” ermöglicht es, einzelne Logikgatter<br />

neu zu konfigurieren. Großflächige Rekonfigurationen oder Änderungen in der<br />

Verdrahtung einzelner Logikblöcke sind damit nicht möglich. Komplexere Änderun-

6 KAPITEL 2. BEGRIFFE UND STRUKTUREN<br />

gen erlaubt der “Module Based Design Flow”. Dabei werden definierbare Bereiche des<br />

FPGAs zu Modulen zusammengefasst, die sich unabhängig voneinander ersetzen lassen.<br />

Da dieser Design Flow es zulässt, die Verdrahtung zu ändern, muss sichergestellt<br />

werden, dass bei der Rekonfiguration nicht Signalkonflikte an der Schnittstelle mit anderen<br />

Modulen auftreten. Ein Beispiel hierfür wäre eine Signalsenke, die bei der Rekonfiguration<br />

durch ein schreibendes Signal ersetzt wird. Es würde zu einem Konflikt<br />

zweier Treiber auf der Leitung kommen, der einen Hardwaredefekt auslösen kann. Um<br />

in jedem Fall die Signalintegrität zu gewährleisten, werden zur Kommunikation zwischen<br />

den Modulen Bus Macros verwendet. Diese Kommunikationsblöcke bilden die<br />

Schnittstelle zwischen zwei Modulen. Sie nutzen Tri-State-Logikressourcen, um die Signalintegrität<br />

zu gewährleisten. Bus Macros sind während der gesamten Laufzeit des<br />

FPGAs konstant. Eine Kommunikation zweier Module ist ausschließlich über Bus Macros<br />

möglich.<br />

Da der “Small Bit Manipulation Design Flow” kein dynamisches Ändern der Verdrahtung<br />

ermöglicht, ist er für eine Entwurfsmethodik mit hoher Flexibilität als Ziel ungeeignet.<br />

Deshalb wurde für diese Arbeit der “Module Based Design Flow” als Ausgangsbasis<br />

gewählt. Darüber hinaus bietet die eingeschränkte und konstante Schnittstelle eine<br />

direkte Analogie zu den Schnittstellen eines Softwareobjektes, wie in Abschnitt 2.2 beschrieben.<br />

Neben dem FPGA kommt außerdem ein Host-System zum Einsatz, das die erforderlichen<br />

Rekonfigurationen durchführt, das FPGA mit Daten beschickt, sowie die Ergebnisse<br />

ausliest. Die Kommunikation mit dem Host-System erfolgt über eine RS-232<br />

Schnittstelle. Die verwendete FPGA-Plattform AlphaData ADM-XPL [6] würde auch<br />

eine Kommunikation über den schnelleren PCI-Bus gestatten. Auf diese Möglichkeit<br />

wurde verzichtet, da die Pins der entsprechenden Datenleitungen physikalisch weit über<br />

das FPGA verteilt liegen. Eine Schnittstellenerweiterung sämtlicher Module wäre notwendig,<br />

um die Leitungen in einem zentralen Kommunikationsmodul zusammenzuführen.<br />

Um auf diese zusätzliche Komplexität innerhalb der rekonfigurierbaren Module zu<br />

verzichten, wird die RS-232 Schnittstelle bevorzugt, die mit zwei Leitungen (Senden<br />

und Empfangen) zur Kommunikation mit dem Host-System auskommt.<br />

2.2 Objektorientierte Konzepte<br />

Ziel des Projektes, in das diese Arbeit eingebunden ist, ist es zu untersuchen, welche<br />

objektorientierten Konzepte sich auf Hardware abbilden lassen und welche Modifikationen<br />

dabei vorzunehmen sind. Betrand Meyer hat insgesamt 15 Regeln und Prinzipien<br />

aufgestellt, die eine objektorientierte Entwicklung kennzeichnen [1]. Die meisten dieser<br />

Regeln kommen erst bei der Entwicklung eines konkreten Programms zum Einsatz. So<br />

sagt etwa die “Few Interfaces”-Regel aus, dass Objekte so wenig wie möglich miteinander<br />

kommunizieren.

2.2. OBJEKTORIENTIERTE KONZEPTE 7<br />

Einige dieser Prinzipien haben auch Einfluss auf die Konzeption der Laufzeitumgebung,<br />

hier also des FPGAs. Insbesondere gilt:<br />

1. Ein objektorientiertes System besteht aus unabhängigen Objekten.<br />

2. Ein Objekt fasst eine Menge von konzeptionell zusammenhängenden Methoden<br />

zusammen. Diese können über definierte Schnittstellen von anderen Objekten aus<br />

aufgerufen werden<br />

3. Die Schnittstellen eines Objektes werden durch eine Klasse beschrieben. Ein Objekt<br />

ist eine konkrete Instanz dieser Klasse.<br />

4. Die Schnittstellen sollen so kompakt und einfach wie möglich sein.<br />

5. Die Modifikation eines Objektes durch externe Prozesse ist ausschließlich über<br />

seine Schnittstellen möglich.<br />

6. Ein Objekt hat keine Kenntnis über den internen Zustand eines anderen Objekts<br />

(Geheimnisprinzip).<br />

7. Die Objekte werden zur Laufzeit bei Bedarf erzeugt. Zu diesem Zeitpunkt wird<br />

auch der Speicher reserviert, den dieses Objekt benötigt.<br />

8. Wenn ein Objekt von keinem anderen Objekt aus mehr erreichbar ist, sind seine<br />

Daten wegen des Geheimnisprinzips nicht mehr zugänglich. Das Objekt kann<br />

gelöscht, sein Speicherplatz wieder freigegeben werden.<br />

Aus diesen Punkten ergibt sich, weshalb der Ansatz der Objektorientierung sich besonders<br />

gut auf rekonfigurierbare Hardwarestrukturen abbilden lässt: Betrachtet man<br />

die rekonfigurierbaren Module als Objekte eines objektorientierten Systems, so lassen<br />

sich diese Punkte weitgehend direkt abbilden. Der modulare Entwurfsprozess fordert<br />

bereits, dass die Kommunikation zwischen den Modulen ausschließlich über definierte<br />

und kompakte Schnittstellen stattfindet, womit Punkt 4 und 5 erfüllt sind. Kommunikation<br />

außerhalb dieser Schnittstellen ist auf dem FPGA aus physikalischen Gründen nicht<br />

möglich, womit das Geheimnisprinzip aus Punkt 6 erfüllt wird. Das Erzeugen neuer<br />

Objekte und das zugehörige Allozieren von Speicher in Software ist identisch mit dem<br />

dynamischen Rekonfigurieren einzelner Module des FPGAs.<br />

Wie in Punkt 8 der Aufzählung beschrieben, kommt es vor, dass Objekte nicht mehr<br />

benötigt werden und der von ihnen verwendete Speicher freigegeben werden kann. Die<br />

Analogie in dem hardwarebasierten Ansatz ist das Freigeben der Logikressourcen eines<br />

Moduls. In der Praxis wird die Freigabe realisiert, indem solche Module in eine<br />

Liste übernommen werden. Die Liste enthält sämtliche Positionen, die bei der nächsten<br />

entsprechenden Anforderung rekonfiguriert werden können.

8 KAPITEL 2. BEGRIFFE UND STRUKTUREN<br />

Um zu erkennen, welche Objekte nicht mehr benötigt und bei Bedarf gelöscht werden<br />

können, ist es notwendig zu überprüfen, welches Objekt welche anderen Objekte erreichen<br />

kann. Diese Informationen unterliegen als Bestandteil eines Objekts auch dem<br />

Geheimnisprinzip, sind also eigentlich nicht frei von außen abzufragen.<br />

Um trotzdem eine Aussage bezüglich freizugebender Objekte treffen zu können, gibt<br />

es zwei verschiedene Ansätze. Die eine Möglichkeit ist es, das Geheimnisprinzip etwas<br />

abzuschwächen. Jedes Objekt erlaubt dann eine Abfrage, welche anderen Objekte<br />

es noch erreichen kann. Dieser Ansatz ist beispielsweise für Systeme üblich, in denen<br />

Objekte manuell gelöscht werden. Die andere Möglichkeit ist es, die <strong>Garbage</strong>-<br />

<strong>Collection</strong> auf Systemebene zu implementieren. Als Teil der Laufzeitumgebung, die<br />

erst solche Mechanismen wie das Geheimnisprinzip bereitstellt, lassen sich die nötigen<br />

Daten ermitteln, ohne dass eine Implementierung das Geheimnisprinzip verletzen kann.<br />

Es ist üblich, das Erkennen von Objekten, die nicht mehr benötigt werden, zu automatisieren.<br />

Diese Mechanismen zur automatischen Speicherverwaltung werden als<br />

<strong>Garbage</strong>-<strong>Collection</strong> bezeichnet. Diese Arbeit konzentriert sich auf die Entwicklung einer<br />

<strong>Garbage</strong>-<strong>Collection</strong> auf Systemebene. Die Vorteile gegenüber einer Implementierung<br />

auf Anwendungsebene sind zum einen die bessere Effizienz und zum anderen eine<br />

einfache Umgebung für den Entwickler, für den dieser Prozess transparent abläuft.<br />

2.3 Strukturierung der Hardware<br />

Um eine elegante Übertragung der Softwarekonzepte zu gestatten, bietet es sich an,<br />

auf dem FPGA mehrere aufeinander aufbauende Abstraktionsebenen zu definieren, wie<br />

sie in Abbildung 2.1 aufgeführt sind. In den unteren hardwarenahen Ebenen werden die<br />

Mechanismen implementiert, die es erlauben auf den oberen Ebenen vollständig von der<br />

Hardware zu abstrahieren. Die Aufgaben und Bestandteile der einzelnen Layer werden<br />

im Folgenden kurz erläutert.<br />

2.3.1 Layer 1: Logik-Ebene<br />

Die Logik-Ebene stellt die Hardwareressourcen zur Verfügung. Wie erläutert, ist hier<br />

eine Architektur erforderlich, die eine partielle, dynamische Rekonfiguration der Ressourcen<br />

ermöglicht.<br />

In dieser Arbeit kommt ein FPGA der Firma Xilinx zum Einsatz (V2P30 [3]). Die<br />

Virtex2 Reihe bietet als leistungsfähige Baureihe der Firma Xilinx die nötigen Ressourcen,<br />

um verschiedene Ansätze zu evaluieren. Basiseinheiten der Logikressourcen<br />

auf diesem FPGA sind frei konfigurierbare CLBs (Configurable Logic Block), die aus<br />

vier Eingangssignalen ein Ausgangssignal mit Hilfe einer Boole’schen Wahrheitstabelle<br />

bilden. Für taktsynchrone Designs befindet sich hinter jedem CLB ein FlipFlop, das

2.3. STRUKTURIERUNG DER HARDWARE 9<br />

Layer 6<br />

Layer 5<br />

Layer 4<br />

Layer 3<br />

Layer 2<br />

Layer 1<br />

Engineering<br />

Application<br />

Middleware<br />

Protokolle<br />

Structured Hardware<br />

Unstructured Hardware<br />

Abstraktionsgrad<br />

Abbildung 2.1: Abstraktionsebenen der Entwurfsmethodik<br />

optional verwendet werden kann. Die Verbindung der CLBs ist über Verdrahtungsressourcen<br />

realisiert, die sich ebenfalls konfigurieren lassen. Zusätzlich bietet die Virtex-2<br />

Plattform komplexere logische Einheiten an. Dies sind zum Beispiel dedizierte Multiplizierer,<br />

Frequenzvervielfacher und sogar PowerPC-Cores. Auf den Einsatz der komplexeren<br />

Einheiten wird in dieser Arbeit verzichtet, um den vorgestellten Entwurfsansatz so<br />

flexibel wie möglich zu halten. Partielle Rekonfiguration ist erst seit kurzem verfügbar<br />

und nur innerhalb gewisser Randbedingungen möglich [4], auf die im nächsten Layer<br />

eingegangen wird.<br />

2.3.2 Layer 2: Struktur-Ebene<br />

In der Struktur-Ebene werden die Logikressourcen von Layer 1 in passende rekonfigurierbare<br />

Module unterteilt und die Busstruktur zur Kommunikation festgelegt. Die<br />

Randbedingungen der verwendeten Hardwarearchitektur bestimmen dieses Design maßgeblich.<br />

Xilinx-FPGAs besitzen eine rechteckige Struktur von ungefähr 92*160 Elementen<br />

(die genauen Maße unterscheiden sich je nach verwendetem Typ). Zur Orientierung<br />

verwendet Xilinx ein X-Y-Koordinaten-System wie in Abbildung 2.2 dargestellt.<br />

Rekonfigurierbare Module müssen die vollständige Höhe des FPGAs abdecken und besitzen<br />

eine horizontale Breite, die ein Vielfaches von Vier darstellen muss. Ein FPGA<br />

mit 92*160 Elementen besitzt damit maximal 40 rekonfigurierbare Elemente der Größe<br />

92*4 Zellen.<br />

Wie bereits erwähnt, muss die Kommunikation zwischen den rekonfigurierbaren Blöcken<br />

über dedizierte Routingressourcen erfolgen. Um die Signalintegrität an der Schnittstelle<br />

auch während der Rekonfiguration eines Moduls sicherzustellen, müssen zur Kom-

10 KAPITEL 2. BEGRIFFE UND STRUKTUREN<br />

Y<br />

n<br />

rekonf.<br />

Modul<br />

3<br />

rekonf.<br />

Modul<br />

2<br />

rekonf.<br />

Modul<br />

1<br />

rekonf.<br />

Modul<br />

0<br />

Arbiter<br />

X<br />

Abbildung 2.2: Struktur eines Virtex2 Pro FPGA<br />

munikation Bussysteme mit Tri-State-Treibern verwendet werden. Die Anzahl der Tri-<br />

State-Treiber ist eng begrenzt und limitiert die maximal mögliche Schnittstelle zwischen<br />

jeweils zwei nebeneinanderliegenden Modulen.<br />

Deshalb ist zur Kommunikation der Module untereinander ein Bussystem realisiert,<br />

welches gegenüber einer direkten Punkt-zu-Punkt Verbindung aller Module auf Kosten<br />

der Geschwindigkeit mit weniger Verdrahtungsressourcen auskommt. Insgesamt verwendet<br />

die Implementierung einen 40 Bit breiten Datenbus.<br />

Neben den frei konfigurierbaren Logikblöcken ist mit dem Arbiter ein statisches Modul<br />

implementiert. Der Arbiter bildet die Laufzeitumgebung für ein Programm, das in<br />

den Modulen realisiert ist. Er fungiert als Busmaster und bildet das Interface zum Host-<br />

System.<br />

Die aktuelle Implementierung besitzt zur Evaluation 15 frei konfigurierbare Module.

2.3. STRUKTURIERUNG DER HARDWARE 11<br />

2.3.3 Layer 3: Protokolle<br />

Die komplexen Busstrukturen machen fortgeschrittene Protokolle erforderlich, die als<br />

eigene Abstraktionsebene aufgefasst werden. Im Rahmen dieser Protokolle wird jedem<br />

rekonfigurierbaren Modul eine Adresse zugeteilt, die mit ihrer geometrischen Position<br />

auf dem Chip identisch ist. Das Modul 3 liegt also beispielsweise zwischen den Modulen<br />

4 und 5. Module sind von rechts nach links durchnummeriert, der Arbiter besitzt die<br />

Adresse 0. In Abbildung 2.2 sind die Adressen über den einzelnen Spalten angegeben.<br />

Aktuell besitzen die Adressen eine Breite von vier Bit, die ausreicht, bis zu 15 Module<br />

anzusprechen.<br />

Die Kommunikation über den Bus enthält damit immer die Adresse des Zielmoduls.<br />

Dazu wird optional eine Absenderadresse mitgeschickt, um beispielsweise einen Rückgabewert<br />

wieder zurück zu senden. Im Normalfall besitzt ein Objekt mehrere unterschiedliche<br />

Methoden, die von außen zugänglich sind. Alle Methoden eines Objekts<br />

besitzen eine eindeutige Identifikationsnummer (ID), die beim Aufruf ebenfalls übertragen<br />

wird. Schließlich müssen auch noch die Argumente des Prozeduraufrufs übertragen<br />

werden.<br />

Die Adresse des Ziels, sowie die Absenderadresse sind jeweils vier Bit breit. Ebenso<br />

das Signal zur Auswählen der Methode, womit ein Objekt maximal 16 verschiedene<br />

Methoden besitzen kann. Die Argumente sind als 16 Bit breiter Bus realisiert.<br />

Zusammengefasst gilt also, dass bei jeder Kommunikation die Adresse des Zielblocks,<br />

optional eine Absenderadresse, Daten für einen Prozeduraufruf, und die ID der aufgerufenen<br />

Prozedur versendet werden. Zusätzliche Kommunikationsstrukturen für Reset-<br />

Signale und ähnliches sind ebenfalls erforderlich.<br />

Außerdem sind verschiedene weitere Kommunikationsstrukturen implementiert, die<br />

beispielsweise ein globales Reset-Signal zu allen Komponenten leiten. Die Möglichkeit,<br />

eine zusätzliche Leitung für die <strong>Garbage</strong>-<strong>Collection</strong> zu verwenden ist gegeben. In<br />

dieser Arbeit werden zwei weitere globale Signale eingeführt, die in Kapitel 4 vorgestellt<br />

werden.<br />

2.3.4 Layer 4: Middleware<br />

Die Kombination aus den rekonfigurierbaren Modulen und den Mechanismen zur Protokollverwaltung<br />

bildet den Middleware-Layer.<br />

Wichtigstes Element der Middleware sind die ComputingPages, die einen Containertyp<br />

für die darin eingebetteten eigentlichen Objekte bilden. Abbildung 2.3 gibt einen<br />

schematischen Überblick über die Einbettung der Objekte. Die ComputingPages bieten<br />

ein abstraktes und vereinfachtes Interface zu den Objekten an. Sie implementieren erforderliche<br />

Verwaltungsmechanismen wie Adressdekodierung für den Bus, und Prozedurdekodierung.<br />

Auch Teile der <strong>Garbage</strong>-<strong>Collection</strong>, die als Teil jedes Objekts realisiert<br />

sind, sind auf diesem Layer angesiedelt.

12 KAPITEL 2. BEGRIFFE UND STRUKTUREN<br />

Computing Page<br />

RightIn<br />

LeftOut<br />

Protokoll Decoder<br />

RightOut<br />

LeftIn<br />

Objekt<br />

Adresse : 4 Bit<br />

Funktion 0(Arg:16 Bit)<br />

Funktion 1(Arg:16 Bit)<br />

Funktion 15(Arg:16 Bit)<br />

Abbildung 2.3: Schematischer Aufbau eines Objekts und der Computing Page<br />

Darüber hinaus ist der Arbiter ein Teil der Middleware. Er steuert als Busmaster die<br />

Kommunikation zwischen den verschiedenen ComputingPages. Der Arbiter verwaltet<br />

die freien ComputingPages und deaktiviert das Bussystem für die Rekonfiguration einer<br />

ComputingPage. Die systemweiten Komponenten der <strong>Garbage</strong>-<strong>Collection</strong> sind ebenfalls<br />

als Teil des Arbiters implementiert. Im Sinne der Kommunikationsprotokolle aus<br />

dem Protokoll-Layer (Layer 3) besitzt der Arbiter die Adresse 0. Geometrisch ist er auf<br />

dem Chip am rechten Rand angeordnet. Eine Rekonfiguration zur Laufzeit ist für den<br />

Arbiter nicht vorgesehen.<br />

2.3.5 Layer 5: Applikation<br />

Die Applikations-Ebene kann auch als Anwendungsebene bezeichnet werden. Sie ist<br />

die Basis zur Entwicklung von Programmen, während die darunterliegenden Layer für<br />

einen Anwender weitgehend transparent und unzugänglich sind. Der Applikations-Layer<br />

belegt den rekonfigurierbaren Block einer ComputingPages mit individuellen Funktionsblöcken.<br />

Jede aktive ComputingPage bildet ein Objekt einer Klasse.<br />

2.3.6 Layer 6: SW-Engineering<br />

Durch Verknüpfung der einzelnen Objekte untereinander entstehen vollständige Threads<br />

und Programme. Die Verknüpfung der Objekte untereinander folgt dabei dem objektorientierten<br />

Paradigma der Modularisierung. Das heißt, die Objekte können einzig über<br />

Prozeduraufrufe auf andere Objekte zugreifen. Dazu muss das aufrufende Objekt die<br />

Adresse des Zielobjektes kennen. Ein Objekt kann durch Aufrufen eines Konstruktors

2.4. BEISPIEL 13<br />

die Anzahl der Objekte im Gesamtsystem erhöhen. Zum Start eines Programms wird ein<br />

initiales Objekt vom Host-System aus erstellt. Diese Objekte werden als Wurzelknoten<br />

bezeichnet und leben während der gesamten Programmausführung. Es ist ohne weiteres<br />

möglich mehrere Wurzelknoten und damit mehrere Threads oder Programme parallel<br />

auf dem FPGA ablaufen zu lassen.<br />

2.4 Beispiel<br />

Die Struktur des Anwendungessystems soll an einem Beispiel verdeutlicht werden. Abbildung<br />

2.4 zeigt das Programmablaufdiagramm für folgendes Codesegment:<br />

c l a s s a : Root {<br />

. . .<br />

Math m = new Math ( ) ;<br />

m. run ( ) ;<br />

P r i n t p = new P r i n t ( ) ;<br />

p . p r i n t (m) ;<br />

}<br />

c l a s s S q r t {<br />

i n t run ( i n t Op1 ) {<br />

return s q r t ( Op1 ) ;<br />

}<br />

c l a s s Math {<br />

void run ( ) {<br />

S q r t s = new S q r t ( ) ;<br />

r e s = s . g e t S q r t ( 3 . 1 4 1 ) ;<br />

s=NULL;<br />

return ( ) ;<br />

}<br />

}<br />

c l a s s P r i n t {<br />

p r i n t ( C l a s s a ) {<br />

. . .<br />

}<br />

}<br />

Das Beispiel beginnt während der Ausführung von Objekt “a” der Klasse “Root”.<br />

Man beachte, dass die Freigabe des Objektes “s” der Klasse “Sqrt” zu keinem vorher<br />

festgelegten Zeitpunkt erfolgt. Der Zeitpunkt wird durch die nächste, der Zuweisung<br />

“s = NULL” folgende, Aktivierung der <strong>Garbage</strong>-<strong>Collection</strong> bestimmt. Sobald mit<br />

“s = NULL” die Referenz auf das Objekt der Klasse “Sqrt” überschrieben wurde,<br />

ist dieses nicht mehr erreichbar und kann freigegeben werden.<br />

2.5 Vereinfachte Repräsentation eines Programms<br />

Für die <strong>Garbage</strong>-<strong>Collection</strong> ist die Verknüpfung zwischen den Objekten von besonderer<br />

Bedeutung, weil sie angibt, welche Objekte nicht mehr erreichbar sind und somit freigegeben<br />

werden können. Zwei Objekte sind dann miteinander verknüpft, wenn ein Objekt<br />

auf die Methoden eines anderen Objektes zugreifen kann. Hinreichende Bedingung für<br />

die Verknüpfung ist es, wenn ein Objekt A die Adresse eines anderen Objektes B kennt.<br />

Für eine Untersuchung der Eigenschaften eines <strong>Garbage</strong>-<strong>Collection</strong>-Algorithmus bietet<br />

es sich an, vom gegebenen Programm zu einem gerichteten Objektgraphen zu abstrahieren.<br />

Jeder Knoten des Graphen repräsentiert ein Objekt und die ausgehenden gerichteten<br />

Kanten geben an, welche anderen Objekte von ihm aus über ihre Adressen

14 KAPITEL 2. BEGRIFFE UND STRUKTUREN<br />

erreichbar sind. Der Graph kann über mehrere ausgezeichnete Wurzelknoten verfügen,<br />

die jeweils die Wurzel eines Threads repräsentieren.<br />

Der Objektgraph für das Beispiel aus Abschnitt 2.4 ist in Abbildung 2.4 dargestellt.<br />

Man sieht, dass verschiedene Operationen, wie Konstruktoraufrufe und lokale Variablenzuweisungen<br />

(“s = NULL”) den Objektgraphen verändern.<br />

Der Graph abstrahiert von der Funktionalität der Objekte, die für eine <strong>Garbage</strong>-<strong>Collection</strong><br />

unerheblich ist. Er beschränkt sich auf die Darstellung der Erreichbarkeit der<br />

Objekte. Die Wurzelknoten eines Programms, die im FPGA von extern erstellt werden,<br />

bilden auch die Wurzelknoten des Graphen.<br />

Im allgemeinen Fall können keine weiteren Aussagen bezüglich der Graphenstruktur<br />

gemacht werden. Trotzdem lassen sich einige zusätzliche heuristische Annahmen<br />

treffen, die darauf beruhen, dass Programme üblicherweise nach gewissen Regeln implementiert<br />

werden. In den meisten Systemen existieren langlebige Objekte, in denen<br />

für kurze Zeit temporäre Objekte angelegt werden. Diese temporären Objekte werden<br />

nur im Rahmen einer Operation benötigt und danach wieder gelöscht. Außerdem hat<br />

sich herausgestellt, dass ein Objekt meist mindestens ebensolang existiert, wie weitere<br />

von ihm erstellte Objekte (Kindobjekte).<br />

Dadurch entsteht eine hierarchische Objektstruktur, die einem Baum der Graphentheorie<br />

ähnelt. Die Tiefe eines Knotens, die als die Anzahl der Kanten zwischen einer<br />

Wurzel und dem Knoten definiert ist, korrespondiert mit seiner Lebensdauer. Die Blätter<br />

des Baums besitzen die höchste Tiefe und sind die kurzlebigsten Objekte. Sie werden<br />

als erstes wieder gelöscht.<br />

Trotzdem bleibt die Baumstruktur nur eine näherungsweise Beschreibung für die meisten<br />

Objektgraphen. Referenzen, die diese Baumstruktur zerstören, kommen ebenfalls<br />

vor, sind jedoch gegenüber den regulären Kanten, eher selten. Für die Entwicklung einer<br />

<strong>Garbage</strong>-<strong>Collection</strong> ist diese vereinfachte Sicht damit zumeist unzulänglich. Sie eignet<br />

sich jedoch gut für statistische Analysen der <strong>Garbage</strong>-<strong>Collection</strong>. Hierzu zählen etwa<br />

Aussagen über die Effizienz oder der Versuch, einen günstigen Zeitpunkt zum Start der<br />

<strong>Garbage</strong>-<strong>Collection</strong> zu finden.<br />

Es gibt verschiedene Untersuchungen, die versuchen, zur Optimierung der <strong>Garbage</strong>-<br />

<strong>Collection</strong> weitere Aussagen über die Struktur des Graphen zu treffen und von ihnen<br />

zu profitieren. Einige für diese Arbeit relevante Untersuchungen werden in Kapitel 5<br />

vorgestellt.

2.5. VEREINFACHTE REPRÄSENTATION EINES PROGRAMMS 15<br />

Instanzierung<br />

Procedure(Source,Target [,Operands,...])<br />

Dispatcher / Arbiter a : Root m : Math s : Sqrt p : Print<br />

Create(Math)<br />

Constructor(0,m)<br />

a<br />

Return(a,m)<br />

run(a,m)<br />

run(a,m)<br />

m<br />

a<br />

Create(Sqrt)<br />

Constructor(0,s)<br />

Return(m,s)<br />

m<br />

a<br />

getSqrt(m,s,"3.141")<br />

getSqrt(m,s,"3.141")<br />

Return(m,"1.77")<br />

Return(m,"1.77")<br />

Return(a)<br />

Return(a)<br />

m<br />

s<br />

a<br />

Create(Print)<br />

Constructor(0,p)<br />

Return(a,p)<br />

m<br />

s<br />

a<br />

print(a,p,"1.77")<br />

print(a,p,"1.77")<br />

m<br />

a<br />

p<br />

Abbildung 2.4: Programmablauf und Objektgraph

16 KAPITEL 2. BEGRIFFE UND STRUKTUREN

Kapitel 3<br />

<strong>Garbage</strong>-<strong>Collection</strong> in Software<br />

Mit dem Begriff <strong>Garbage</strong>-<strong>Collection</strong> (GC) bezeichnet man die automatische Speicherverwaltung<br />

eines objektorientierten Systems. Aufgabe der GC ist es, Objekte, die nicht<br />

mehr verwendet werden können, zu löschen und ihren Speicherbereich zur Wiederverwendung<br />

freizugeben. Ein Objekt kann dann nicht mehr verwendet werden, wenn es<br />

in anderen Objekte keine Referenzen auf dieses Objekt mehr gibt, es also nicht mehr<br />

erreichbar ist. Meyer [1] bietet einen kurzen Überblick über die Entwicklung der GC<br />

und ihre Verwendung in objektorientierten Systemen.<br />

Man unterscheidet zwischen zwei Prozessen: Der Mutator verändert den Inhalt des<br />

Speichers. Er enthält das eigentliche Programm und sollte idealerweise ohne Unterbrechung<br />

laufen. Der Collector implementiert die <strong>Garbage</strong>-<strong>Collection</strong>. Seine Aufgabe ist<br />

es zu gewährleisten, dass der Mutator immer in der Lage ist, ausreichend Speicher zu allozieren.<br />

Der Collector sollte den Mutator so wenig wie möglich behindern, ohne dabei<br />

seine Funktionalität einzubüßen.<br />

Die Funktionalität einer GC lässt sich in zwei Anforderung aufteilen:<br />

Definition 3.0.1 (Korrektheit)<br />

Jedes Objekt, das von der <strong>Garbage</strong>-<strong>Collection</strong> gelöscht wird, ist zuvor von keinem anderen<br />

Objekt aus mehr erreichbar.<br />

Definition 3.0.2 (Vollständigkeit)<br />

Alle nicht mehr erreichbaren Objekte werden erkannt und freigegeben.<br />

Die Bedingung der Vollständigkeit wird oft zugunsten einer effizienteren GC-Implementierung<br />

abgeschwächt. Mögliche Neuformulierungen der Vollständigkeit fordern<br />

dann, dass jedes nicht erreichbare Objekt irgendwann einmal gelöscht wird. Es wird<br />

nicht mehr gefordert, dass dies bereits beim nächsten GC-Lauf stattfindet. Eine andere<br />

Möglichkeit zur Abschwächung ist die Forderung, dass die GC in jedem Schritt ein<br />

garantiertes Minimum an nicht mehr erreichbaren Objekten löscht. Wichtig ist es, die

18 KAPITEL 3. GARBAGE-COLLECTION IN SOFTWARE<br />

Anforderungen des Mutators zum Allozieren neuer Objekte erfüllen zu können, solange<br />

Speicherbereiche existieren, die nicht mit aktiven Objekten belegt sind.<br />

Wie in Kapitel 2 erläutert, lassen sich die ComputingPages als Objekte einer objektorientierten<br />

Entwurfsmethodik interpretieren.<br />

Der Analogie folgend bildet das rekonfigurierbare FPGA den Speicher, in dem diese<br />

Objekte abgelegt sind. Auch die Konzepte der <strong>Garbage</strong>-<strong>Collection</strong> lassen sich mit dieser<br />

Analogie auf FPGAs übertragen. Ihre Aufgabe ist es, die verfügbaren rekonfigurierbaren<br />

Ressourcen zu verwalten.<br />

Neben der Korrektheit und Vollständigkeit ist das wesentliche Merkmal eines guten<br />

Algorithmus zur GC, dass das Programm bei seiner Ausführung so kurz wie möglich unterbrochen<br />

wird. Das Instantiieren eines neuen Objektes (die Anforderung eines freien<br />

Speicherbereiches) soll möglichst unterbrechungsfrei stattfinden. Dazu sind verschiedene<br />

Ansätze zur <strong>Garbage</strong>-<strong>Collection</strong> entwickelt worden, die im Folgenden kurz vorgestellt<br />

werden. Zusätzlich wird die Relevanz der Ansätze für rekonfigurierbare Hardware<br />

diskutiert, bevor in Kapitel 4 ein Ansatz für eine effiziente <strong>Garbage</strong>-<strong>Collection</strong> in rekonfigurierbarer<br />

Hardware entwickelt und in Kapitel 5 genauer untersucht wird.<br />

3.1 Statische Reservierung<br />

Bei der statischen Speicherreservierung gibt es keine eigentliche <strong>Garbage</strong>-<strong>Collection</strong>.<br />

Trotzdem soll dieses Prinzip hier der Vollständigkeit halber erwähnt werden. Bei dieser<br />

Art der Speicherverwaltung wird bereits beim Programmstart der gesamte benötigte<br />

Speicher reserviert. Dynamische Programme, bei denen der Speicherbedarf zur Laufzeit<br />

wachsen kann, sind damit nicht möglich. Vorteil dieser Art von Speicherverwaltung<br />

ist ihre Einfachheit: Man benötigt keine <strong>Garbage</strong>-<strong>Collection</strong> und kann daher harten<br />

Echtzeit-Anforderungen genügen, die man durch externe Speicherverwaltung nicht<br />

mehr erfüllen kann. Diese Art der Speicherverwaltung entspricht am ehesten dem klassischen<br />

Ansatz zur Entwicklung von Hardwaredesigns und ist häufig in “Embedded<br />

Systems” anzutreffen .<br />

Charakteristika einer statischen Reservierung<br />

• Keine dynamische Speicherreservierung und Freigabe<br />

• Sehr einfach<br />

• Erfüllt harte Echtzeit-Anforderung<br />

• Keine dynamischen Programme möglich<br />

• Analogie zur Klassischer Hardwareentwicklung

3.2. EXPLIZITE RESERVIERUNG 19<br />

3.2 Explizite Reservierung<br />

Bei der expliziten Speicherreservierung werden die Aufgaben der GC vom Programmierer<br />

übernommen. Dieser kann durch Kenntnis des Programmablaufs bestimmen, wann<br />

ein Objekt nicht mehr verwendet wird. Daraufhin gibt er den vorher vom Objekt belegten<br />

Speicher mit einem entsprechenden Befehl explizit frei. Bekanntestes Beispiel für<br />

dieses Konzept ist die Sprache C [8] mit den Befehlen malloc() und free(). In der Hardwareentwicklung<br />

entspricht es am ehesten den bestehenden Ansätzen zur Ausnutzung<br />

von dynamisch rekonfigurierbarer Hardware, bei denen ebenfalls der Entwickler die<br />

Rekonfiguration steuert. Vorteil dieser Variante ist die gute Kontrolle über das Zeitverhalten<br />

der Speicherverwaltung. Ein wesentlicher Nachteil ist die Komplexität der Softwareentwicklung.<br />

In großen Projekten ist es oft sehr schwer, den Überblick über die<br />

instantiierten Objekte zu behalten. Vergisst der Entwickler Objekte freizugeben, kann<br />

dies zu schwer nachvollziehbaren Fehlern (Memory Leaks) führen, die ein typisches<br />

Problem vieler Anwendungen bilden, die diese Art der Speicherverwaltung nutzen.<br />

Charakteristika einer expliziten Reservierung<br />

• Beispiel: “free” und “malloc” aus C<br />

• Einfach zu implementieren<br />

• Teilweise deterministisches Timing (in kritischen Teilen kein “free” verwenden)<br />

• Analogie zur normalen Hardware-Rekonfiguration<br />

3.3 Referenzzählung<br />

Die Referenzzählung [9] war der erste automatische Ansatz zur <strong>Garbage</strong>-<strong>Collection</strong>. Zu<br />

jedem Objekt wird ein Zähler mitgeführt, der angibt, wieviele Referenzen noch auf dieses<br />

Objekt verweisen. Wenn der Zähler auf Null geht, gibt es keine Referenzen mehr<br />

und das Objekt kann gelöscht werden. Um den Referenzzähler aktuell zu halten, ist<br />

es erforderlich, bei jeder Zuweisung einer Referenz (oder auch deren Löschen) den<br />

Referenzzähler zu inkrementieren und dekrementieren. Damit ist dieser Ansatz relativ<br />

zeitaufwändig. Vorteil des Ansatzes ist, dass sich der Mehraufwand gleichmäßig<br />

über das Programm verteilt und die Latenz einer Operation gut einschätzbar ist. Der<br />

Ansatz ermöglicht also die Einhaltung von weichen Echtzeitbedingungen. Als wesentlicher<br />

Nachteil bleibt zu erwähnen, dass die Referenzzählung nicht in der Lage ist eine<br />

zyklisch verkettete Liste korrekt als <strong>Garbage</strong> zu erkennen, weil alle diese Objekte noch<br />

einen Referenzähler > 0 besitzen.

20 KAPITEL 3. GARBAGE-COLLECTION IN SOFTWARE<br />

Charakteristika der Referenzzählung<br />

• Einfacher Ansatz<br />

• Kann keine Zyklen erkennen<br />

• Bei jeder Zuweisung ändert sich die Referenz (Häufiger Aufruf)<br />

• Weiche Echtzeitbedingungen<br />

3.4 Mark-Sweep <strong>Collection</strong><br />

Das Verfahren der Mark-Sweep-<strong>Collection</strong> ist heute das am häufigsten verwendete Verfahren<br />

zur automatisierten <strong>Garbage</strong>-<strong>Collection</strong>. Der Begriff Mark-Sweep-<strong>Collection</strong> wird<br />

in viele Arbeiten synonym mit dem Begriff <strong>Garbage</strong>-<strong>Collection</strong> verwendet.<br />

Bei diesem Verfahren arbeitet der Collector-Prozess in zwei Phasen: In der ersten Phase<br />

(Mark) werden ausgehend von der Wurzel alle erreichbaren Knoten (die Objekte)<br />

markiert. In der zweiten Phase wird der gesamte Speicher einmal linear durchlaufen<br />

(Sweep). Objekte, die nach diesen beiden Phasen nicht als erreichbar markiert sind,<br />

werden wieder freigegeben.<br />

Gegenüber der Referenzzählung gibt es bei diesem Verfahren keine Probleme mit isolierten<br />

Zyklen, weil sie ausgehend von der Wurzel aus nicht erreichbar sind und somit<br />

während der Mark-Phase auch nicht markiert werden.<br />

Das Verfahren ermöglicht es, ausgehend von einem beliebigen Knoten, kleinere Teilbäume<br />

zu traversieren. Damit kann man ohne den Aufwand einer vollständigen Traversierung<br />

nicht mehr erreichbare Objekte finden und freigeben. Diese Idee ist unter dem<br />

Begriff Generational <strong>Collection</strong> bekannt und wird in Kapitel 3.5.3 näher erläutert.<br />

Hauptnachteil der Mark-Sweep-<strong>Collection</strong> ist ihr schlechtes Echtzeitverhalten. Sie erfordert<br />

eine vollständige Traversierung des Objekt-Graphen im Mark-Prozess und eine<br />

lineare Traversierung des kompletten Speichers im Sweep-Prozess für einen Collector-<br />

Aufruf. Dadurch kann es zu starken Verzögerungen im Ablauf des Mutators kommen.<br />

Ein weiterer Nachteil dieser Art von <strong>Garbage</strong>-<strong>Collection</strong>ist die Fragmentierung des<br />

Speichers. Durch das Löschen von Objekten inmitten des linear angeordneten Speichers<br />

entstehen Lücken. Fordert die nächste Allozierung mehr Speicher an, als in einer<br />

einzelnen Lücke vorhanden ist, muss die Allozierung verhindert werden, obwohl insgesamt<br />

ausreichend freier Speicher vorhanden wäre. Um die Fragmentierung zu beseitigen<br />

muss der belegte Speicher so weit umsortiert werden, dass ausreichend zusammenhängender<br />

freier Speicher vorhanden ist. Eine effiziente Strategie für die Problematik der<br />

Fragmentierung zu finden, ist eine weitere Aufgabe eines GC-Algorithmus.<br />

In der Praxis hat sich die Mark-Sweep-<strong>Collection</strong> durchgesetzt. Grund dafür ist, neben<br />

der einfachen Implementierung, die gute Erweiterbarkeit um die Nachteile des Verfahrens<br />

zu vermindern oder zu beseitigen.

3.5. ERWEITERUNGEN DER MARK-SWEEP-COLLECTION 21<br />

Auch für Hardware bietet sich die Mark-Sweep-<strong>Collection</strong> an. Sie ermöglicht Erweiterungen<br />

und Mechanismen zur Nebenläufigkeit, die sich besonders gut für eine direkte<br />

Abbildung auf die inhärent nebenläufige Hardwareumgebung eignen. Das Problem der<br />

Fragmentierung ist aufgrund der homogenen Struktur der ComputingPages vernachlässigbar<br />

für unsere Implementierung vernachlässigbar.<br />

Charakteristika der Mark-Sweep-<strong>Collection</strong><br />

• Auch bekannt als <strong>Garbage</strong>-<strong>Collection</strong><br />

• Idee: Objekte bilden einen Baum, der traversiert wird<br />

• Findet auch isolierte Zyklen<br />

• Fragmentierung des Speichers<br />

• Ungünstiges Echtzeit-Verhalten<br />

• Normalerweise suspendiert der Prozess während dem Mark-Schritt<br />

• Zum nebenläufigen Algorithmus erweiterbar<br />

3.5 Erweiterungen der Mark-Sweep-<strong>Collection</strong><br />

Im Folgenden werden die Konzepte der wichtigsten Erweiterungen für die Mark-Sweep-<br />

<strong>Collection</strong> vorgestellt. Es wird zusätzlich jeweils kurz erwähnt, inwiefern sie für eine<br />

Hardwareimplementierung von Interesse sein könnten.<br />

3.5.1 Fragmentierung<br />

Die Copying <strong>Collection</strong> [10] ist ein Ansatz, das Problem der Fragmentierung des Speichers<br />

zu beseitigen. Bei dieser Art der <strong>Garbage</strong>-<strong>Collection</strong> werden zwei disjunkte, gleich<br />

große Speicherbereiche für das Programm (den Mutator) reserviert. Alle Objekte liegen<br />

gemeinsam in einem der beiden Speicherbereiche, der im Lauf der Programmlaufzeit<br />

fragmentiert. Während des GC-Zyklus werden alle aktiven Objekte in den anderen Bereich<br />

verschoben und dort wieder hintereinander im Speicher abgelegt. Danach wechseln<br />

die beiden Speicherbereiche ihre Funktion und der Speicher wird durch den Mutator<br />

bis zum nächste GC-Lauf wieder fragmentiert.<br />

Für die Hardwareimplementierung ist das Problem der Fragmentierung vernachlässigbar,<br />

da die technischen Rahmenbedingungen nur eine kleine Zahl gleichförmig großer<br />

ComputingPages zulassen.

22 KAPITEL 3. GARBAGE-COLLECTION IN SOFTWARE<br />

3.5.2 Nebenläufigkeit<br />

Eine wichtige Methode, die schlechten Echtzeitverhältnisse der Mark-Sweep-<strong>Collection</strong><br />

zu verbessern ist, Mutator und Collector als nebenläufige Prozesse zu realisieren. Im<br />

Idealfall kann der Mutator so ohne Unterbrechungen ablaufen, während der Collector<br />

parallel nicht mehr erreichbare Objekte findet und freigibt. Der Mutator muss nur unterbrochen<br />

werden, wenn der Collector nicht ausreichend schnell freie Objekte finden<br />

kann.<br />

Für eine dedizierte Hardwareimplementierung bietet sich ein solcher Ansatz an, da<br />

man die nebenläufigen Strukturen der Plattform optimal nutzen kann.<br />

Die Implementierung eines nebenläufigen Algorithmus ist sehr komplex. Insbesondere<br />

der Beweis der Korrektheit eines solchen Algorithmus erfordert aufwändige formale<br />

Verifikationsmethoden, wie sie zum Beispiel von Dijkstra [11] angewandt werden.<br />

Es lassen sich jedoch einige gemeinsame Aspekte für eine nebenläufige <strong>Garbage</strong>-<br />

<strong>Collection</strong> finden, die ein korrekter Algorithmus aufweisen muss. Huelsbergen [12],<br />

Ben-Ari [13], Doligez [14] und Domani [15] geben einige Beispiele für solche Algorithmen<br />

zusammen mit einem formalen oder semi-formalen Beweis ihrer Korrektheit.<br />

Für einen solchen Beweis muss man über atomare Operationen verfügen, die im Rahmen<br />

des GC-Algorithmus zum Einsatz kommen. Ohne solche Operationen lassen sich<br />

keine Aussagen und Invarianten über die Funktionalität eines nebenläufigen Algorithmus<br />

bilden. Für eine Hardwareimplementierung bietet das synchrone Systemdesign und<br />

das Kommunikationsprotokoll über den Arbiter eine passende Ausgangsbasis für atomare<br />

Operationen der <strong>Garbage</strong>-<strong>Collection</strong>.<br />

Neben atomaren Operationen muss man darüber hinaus die Funktionalität des Mutators<br />

während eines aktiven Collector-Zyklus in gewissem Rahmen einschränken. Normalerweise<br />

schränkt man entweder die Möglichkeiten zum Schreiben in den Speicher<br />

(write-barrier) oder das Lesen aus dem Speicher (read-barrier) ein. Ohne diese Einschränkungen<br />

könnte der Mutator durch Änderungen an der Objektstruktur während<br />

des aktiven Mark-Prozess die Korrektheit des Algorithmus verletzen. Abbildung 3.1<br />

illustriert dieses Problem an einem Beispiel. Die Zahlen geben die Reihenfolge der Traversierung<br />

während des Mark-Schrittes an, wobei von a) nach b) im Mutator eine Kante<br />

gelöscht und von b) nach c) eine neue Kante hinzugefügt wird. Der Algorithmus erkennt<br />

den Knoten “X” nicht als aktives Objekt, obwohl es offensichtlich erreichbar ist.<br />

Darüber hinaus bilden diese Barrieren die Basis für formelle Beweise zur Korrektheit<br />

einer nebenläufigen <strong>Garbage</strong>-<strong>Collection</strong>.<br />

Ein weiterer Nachteil der nebenläufigen Algorithmen bleibt neben ihrer höheren Komplexität<br />

gegenüber sequenziellen Verfahren, dass man bei ihnen die Vollständigkeit der<br />

<strong>Garbage</strong>-<strong>Collection</strong> aufgeben muss. Da der Mutator während der Mark-Traversierung<br />

weiter auf die Objektstruktur Zugriff hat, kann es dazu kommen, dass ein Objekte noch<br />

als erreichbar gekennzeichnet ist, obwohl es noch vor dem Ende der Traversierung durch<br />

den Mutator gelöscht wird. Solche Objekte werden im nächsten GC-Zyklus erkannt.

3.5. ERWEITERUNGEN DER MARK-SWEEP-COLLECTION 23<br />

1<br />

1<br />

1<br />

2 2 5<br />

2<br />

5<br />

3 4<br />

3 4 6<br />

X<br />

a) b) c)<br />

Abbildung 3.1: Inkorrekter Objektgraph bei nebenläufiger <strong>Garbage</strong>-<strong>Collection</strong><br />

Eine Erweiterung der Barrieren, um auch diese Problem-Konstellationen zu vermeiden,<br />

würde wieder direkt zu einem sequenziellen Algorithmus zurückführen.<br />

Üblicherweise nimmt man den Nachteil der nicht mehr erfüllbaren Vollständigkeit in<br />

Kauf, da man in den meisten Szenarien nicht in einem GC-Zyklus sämtlichen freizugebenden<br />

Speicher benötigt, sondern nur ausreichend viel freien Speicher, um bis zum<br />

übernächsten GC-Zyklus neue Objekte allozieren zu können.<br />

3.5.3 Generational <strong>Collection</strong><br />

Ein weiterer Ansatz, das schlechte Echtzeit-Verhalten der Mark-Sweep-<strong>Collection</strong> zu<br />

verbessern, ist die Generational <strong>Collection</strong>, die zuerst von Lieberman [18] vorgeschlagen<br />

wurde und auch unter dem Begriff Generation Scaveging bekannt ist. Dabei wird<br />

der Objektgraph in verschiedene Objekt-Klassen partitioniert. Die Klassen sind dabei<br />

über die Lebensdauer ihrer Objekte definiert.<br />

Der Mark-Sweep Prozess findet nun innerhalb der einzelnen Partitionen statt, wobei<br />

die Partition mit den kurzlebigeren Objekten entsprechend häufiger aufgeräumt wird<br />

als die der langlebigen Objekte. Dadurch wird erreicht, dass man eine kürzere Zeit für<br />

einen GC-Zyklus benötigt, da die einzelnen Partitionen weniger Objekte als das gesamte<br />

Programm enthalten. Zugleich wird die Wahrscheinlichkeit, ausreichend viele Objekte<br />

freizugeben, um ausreichend freien Speicher zur Verfügung zu haben, nicht zu sehr<br />

verringert, weil man in den häufig traversierten kurzlebigen Objekten auch die meisten<br />

wieder freizugebenden Kandidaten finden wird.<br />

Die Generational <strong>Collection</strong> erfordert in zwei Punkten einen Mehraufwand des GC-<br />

Algorithmus. Kanten, die im ursprünglichen Objektgraphen zwischen Objekten zweier

24 KAPITEL 3. GARBAGE-COLLECTION IN SOFTWARE<br />

verschiedener Partitionen liegen, müssen während der Traversierung zusätzlich überwacht<br />

werden, um zu verhindern, dass ein Objekt, welches nur aus einer anderen Partition<br />

heraus erreichbar ist, nicht versehentlich freigegeben wird.<br />

Ein zweites und grundlegenderes Problem ist die Vorhersage der Lebensdauer eines<br />

Objektes und damit seine Einordnung in die korrekte Partition von Objekten. In einem<br />

beliebigen Programm ist die Lebensdauer nicht vorhersehbar, weshalb hier Heuristiken<br />

zum Tragen kommen müssen.<br />

Der einfachste Ansatz, die Lebensdauer vorherzusagen, ist die so genannte weak generational<br />

hypothesis [18]. Sie besagt, dass: “Junge Objekte kürzer leben”. Das ermöglicht<br />

einfache Implementierungen, die auch in der Praxis zu guten Ergebnissen führen<br />

[16], [17]. Die Annahme beruht auf der intuitiven Beobachtung, dass in einem typischen<br />

Programm meist eine Gruppe von langlebigen Objekte existiert, die viele kurzlebige<br />

temporäre Objekte erstellen, die nach der Verwendung nicht mehr benötigt werden. Zur<br />

Implementierung werden neue Objekte immer in der kurzlebigen Klasse eingeordnet<br />

und zu den langlebigen Objekten verschoben, sobald sie einen GC-Zyklus überstanden<br />

haben.<br />

Komplexere Heuristiken verwenden noch weitere Informationen, wie zum Beispiel<br />

die Art der Referenz eines Objektes auf ein anderes [19]. Dabei wird ausgenutzt, dass<br />

Referenzen, die auf dem Stack des Programms liegen, meist zu kurzlebigeren Objekten<br />

führen als Referenzen im globalen Speicher.<br />

Charakteristika der Generational-<strong>Collection</strong><br />

• Bekannt als “Generation Scaveging”<br />

• Verbessert Echtzeit-Verhalten<br />

• Basiert auf der zukünftigen Lebensdauer der Objekte<br />

• Aufwändige Heuristiken

Kapitel 4<br />

<strong>Garbage</strong>-<strong>Collection</strong> in Hardware<br />

In diesem Kapitel wird ein <strong>Garbage</strong>-<strong>Collection</strong>-Algorithmus für Hardware (HW-GC)<br />

entworfen und entwickelt. Er eignet sich für eine hardwarebasierte Laufzeitumgebung,<br />

wie sie zum Beispiel in Embedded Systems vorkommen kann. Der Algorithmus basiert<br />

auf den Erkenntnissen, die in softwarebasierten Ansätzen entwickelt und in Kapitel 3<br />

vorgestellt worden sind. Er soll dabei besondere Rücksicht auf die Rahmenbedingungen<br />

der verwendeten Evaluationsplattform auf Basis eines FPGAs der Firma Xilinx nehmen.<br />

Diese Einschränkung durch äußere Rahmenbedingungen ist für die Entwicklung hardwarenaher<br />

Mechanismen typisch und stellt keinen Nachteil für die vorgestellten Methodiken<br />

dar, mit denen die bestehenden Algorithmen auf die Hardware adaptiert werden.<br />

In Kapitel 2 wurde bereits detailliert auf die Rahmenbedingungen der verwendeten<br />

Plattform eingegangen. Wesentlichen Einfluss auf die Entwicklung des Algorithmus haben<br />

die folgenden Punkte:<br />

• Die rekonfigurierbaren Module sind nebeneinander angeordnet.<br />

• Kommunikation zwischen den Modulen erfolgt ausschließlich über ein festgelegtes<br />

Interface, das möglichst kompakt gehalten wird.<br />

• Die Module verwenden ein gemeinsames Bussystem zum Datenaustausch. Das<br />

Kommunikationsprotokoll sieht vor, dass sämtliche Kommunikation über den zentralen<br />

Arbiter läuft.<br />

Diese Arbeit konzentriert sich auf die Mark-Sweep Ansätze (siehe Kapitel 3.4). Hauptgrund<br />

für diese Entscheidung ist die Tauglichkeit der Mark-Sweep <strong>Garbage</strong>-<strong>Collection</strong><br />

für eine Erweiterung zur Nebenläufigkeit. Selbst entworfene Hardware bietet ohnehin<br />

Nebenläufigkeit, so dass dieser Ansatz eine einfache und effiziente Implementierung<br />

eines nebenläufigen <strong>Garbage</strong>-<strong>Collection</strong>-Algorithmus verspricht. Des weiteren ist<br />

die Kommunikation zwischen einzelnen Objekten verhältnismäßig teuer. Ein Ansatz,<br />

der auf Reference-Counting (Abschnitt 3.3) basiert, erfordert eine Aktualisierung der

26 KAPITEL 4. GARBAGE-COLLECTION IN HARDWARE<br />

Referenz-Zähler bei jeder Zuweisung. Er wird durch die Kommunikation deutlich mehr<br />

beeinflusst als ein Mark-Sweep Ansatz, der nur zu wenigen Zeitpunkten aktiviert werden<br />

muss, um wieder Objekte freizugeben.<br />

4.1 Einordnung der <strong>Garbage</strong>-<strong>Collection</strong><br />

Eine weitere grundlegende Entscheidung ist die Einordnung der <strong>Garbage</strong> <strong>Collection</strong> in<br />

das Schichtenmodell aus Kapitel 2. Wie dort erläutert, lässt sich ein GC-Mechanismus<br />

entweder als Teil der Laufzeitumgebung in der Middleware, oder aber auf Anwendungsebene<br />

im Applikations-Layer implementieren.<br />

Wenn die <strong>Garbage</strong>-<strong>Collection</strong> auf Anwendungsebene realisiert wird, lässt sie sich innerhalb<br />

einer ComputingPage als normales Objekt realisieren. Als Mark-Sweep-Algorithmus<br />

benötigt die <strong>Garbage</strong>-<strong>Collection</strong> für jedes Objekt Zugriff auf deren Liste aller<br />

erreichbaren Objekte. Auf Anwendungsebene erfolgt das Auslesen dieser Liste über<br />

öffentlichen Methoden, die sämtliche Objekte implementieren müssen. Um den dabei<br />

entstehenden, erheblichen Kommunikationsaufwand zu vermeiden, ist die <strong>Garbage</strong>-<br />

<strong>Collection</strong> als Teil der Laufzeitumgebung realisiert. Sie verfügt über zusätzliche, eigene<br />

Kommunikationsmöglichkeiten (Drähte).<br />

Die Mechanismen zur Speicherverwaltung werden als Teil des Arbiters implementiert,<br />

der wiederum als Teil der Middleware parallel zu den frei konfigurierbaren ComputingPages<br />

existiert. Diese Lösung erlaubt es, spezielle Kommunikations- und Traversierungsstrukturen<br />

zu implementieren, welche die <strong>Garbage</strong>-<strong>Collection</strong> wesentlich beschleunigen.<br />

Eine zweite Entscheidung betrifft Systeme, die aus mehreren FPGAs bestehen und<br />

damit auch über mehrere Arbiter verfügen. Hier gibt es ebenfalls zwei Möglichkeiten:<br />

• Separate <strong>Garbage</strong>-<strong>Collection</strong> pro Chip: Sind die Kommunikationskanäle für die<br />

GC völlig transparent, dann reicht ein GC-Prozess aus. Es müssen Mechanismen<br />

entwickelt werden, ineffiziente Graphen-Traversierungen zu vermeiden. Diese<br />

treten auf, wenn häufiger als nötig Kanten über die Chip-Grenzen hinweg traversiert<br />

werden. Weil diese Kommunikationsart teurer als Traversierungen innerhalb<br />

der Objekte eines Chips ist, sollte sie vermieden werden.<br />

• Alternativ gäbe es die Möglichkeit, eine gemeinsame <strong>Garbage</strong>-<strong>Collection</strong> pro<br />

Chip zu realisieren, die mit Hilfe zusätzlicher Logik entsprechend synchronisiert<br />

werden muss.<br />

Mechanismen zur Unterstützung mehrerer Chips werden in dieser Arbeit nicht weiter<br />

betrachtet.

4.2. TRAVERSIERUNG 27<br />

4.2 Traversierung<br />

Kernstück und Hauptunterschied zur <strong>Garbage</strong>-<strong>Collection</strong> in Software ist die Traversierung<br />

im Mark-Prozess. Im Gegensatz zu einer klassischen Software Umgebung existieren<br />

in dem FPGA-basierten System weder ein gemeinsamer Speicher noch eine zentrale<br />

Memory-Mangement-Unit (MMU). Dies erfordert die Entwicklung völlig neuer Mechanismen,<br />

um die Referenzen, die in den ComputingPages abgelegt sind, auszulesen<br />

und zur nächsten ComputingPage weiterzuverfolgen.<br />

Ausgangspunkt der <strong>Garbage</strong>-<strong>Collection</strong> ist eine zentrale Komponente, die sich in der<br />

hierarchischen Struktur aus Kapitel 2 ähnlich wie der Arbiter einordnen lässt. Aufgabe<br />

dieser Komponente ist es, eine Liste der Wurzelknoten zu halten. Die Wurzelknoten<br />

entstehen, wenn über das Host-Interface ein neuer Prozess gestartet wird. An Ende der<br />

Verarbeitung wird das Ergebnis des Prozesses an das Host-System gesendet und der<br />

Wurzelknoten wieder gelöscht. Darüber hinaus muss die zentrale GC-Komponente entscheiden,<br />

wann ein neuer GC-Zyklus erforderlich ist, weil nicht mehr ausreichend viele<br />

freie ComputingPages zur Verfügung stehen. Um einen neuen GC-Zyklus zu starten,<br />

wird der normale Programmablauf gestoppt, der Mark- und der Sweep-Prozess werden<br />

durchgeführt und die nicht mehr erreichbaren Objekte werden der Liste der verfügbaren<br />

ComputingPages zugeteilt.<br />

Ein erster trivialer Ansatz zur Implementierung der Mark-Sweep-<strong>Collection</strong> wäre es,<br />

ausgehend von der zentralen Komponente sämtliche Referenzen des ersten Wurzelknotens<br />

auszulesen, lokal abzuspeichern und mit diesen Referenzen den Objektgraph weiter<br />

zu traversieren. Je nach verwendeter Speicherstruktur für die ausgelesenen Referenzen<br />

(Queue oder Stack) entsteht dadurch eine Breiten- oder Tiefensuche [20], die alle von<br />

der Wurzel aus erreichbaren Knoten besucht. In Abbildung 4.1 (linke Seite) wird solch<br />

eine Traversierung für einen einfachen Objektgraphen gezeigt. Für die Funktionalität<br />

der <strong>Garbage</strong>-<strong>Collection</strong> ist es zunächst unerheblich, ob eine Breiten- oder Tiefensuche<br />

implementiert wird.<br />

Der grundlegende Nachteil des beschriebenen Ansatzes ist die aufwändige Kommunikation.<br />

Es ist erforderlich, jede Referenz, die in einer aktiven ComputingPage vorkommt,<br />

zur zentralen <strong>Garbage</strong>-<strong>Collection</strong> -Komponente zu schicken. Sollte die gerade<br />

gelesene Referenz noch nicht als aktiv markiert sein, so muss in einem weiteren Kommunikationsschritt<br />

das referenzierte Objekt als aktiv markiert, und seine Referenzliste<br />

ausgelesen werden. Bei durchschnittlich n Referenzen pro ComputingPage und m aktiven<br />

ComputingPages auf dem FPGA ist es somit erforderlich, n ∗ m Referenzen zur<br />

zentralen Komponente hin und m Adressen zum Auslesen der nächsten zu traversierenden<br />

Komponente vom Arbiter zu den jeweiligen Objekten zurück zu schicken. Es sind<br />

also insgesamt n ∗ m + m Kommunikationsoperationen nötig.<br />

Unter Berücksichtigung der Randbedingungen, die eine Kommunikation mit dem Arbiter<br />

zu einer teuren Operation machen, ist ein Traversierungsschema wünschenswert,<br />

das mit wesentlich weniger Traversierungen auskommt. Eine effizientere Traversierung

28 KAPITEL 4. GARBAGE-COLLECTION IN HARDWARE<br />

wird durch verschiedene Ansätze ermöglicht. Durch eine nebenläufige Traversierung<br />

lassen sich mehrere Traversierungsschritte auf einmal durchführen. Im Idealfall lassen<br />

sich sämtliche Referenzen einer ComputingPage in einem einzigen Taktzyklus abarbeiten.<br />

Eine mögliche Traversierung hierfür ist in Abbildung 4.1 (rechte Seite) zu sehen.<br />

Anstelle von sieben Schritten bei der klassischen Tiefensuche (linke Seite) werden hier<br />

nur noch vier Schritte benötigt. Um diese Art der Traversierung zu gewährleisten, ist<br />

ein System notwendig, das es gestattet mit mehreren Modulen parallel zu kommunizieren.<br />

So ist in Schritt drei die zeitgleiche Aktivierung dreier verschiedener Knoten<br />

notwendig. Wegen den beschränkten Kommunikationsressourcen ist diese Forderung<br />

nicht erfüllbar.<br />

1<br />

1<br />

2<br />

6<br />

2<br />

2<br />

3<br />

5<br />

7<br />

3<br />

3 3<br />

4<br />

4<br />

a)<br />

b)<br />

Abbildung 4.1: Traversierungsreihenfolge eines Objektgraphen mit sequenzieller Traversierung<br />

mit Tiefensuche (a) und nebenläufiger Traversierung (b)<br />

In dieser Arbeit ist daher eine Struktur entwickelt worden, die durch Lokalisierung der<br />

Kommunikation eine mehrfache Nutzung des Bussystems innerhalb eines Zeitschritts<br />

erlaubt. Zudem wurde der Algorithmus dezentralisiert. Die Aufgabe der zentralen GC-<br />

Komponente ist es nur noch, die Traversierung in den Wurzelknoten anzustoßen, die<br />

ihrerseits die Traversierung in ihren erreichbaren Knoten selber anstoßen. Ein möglicher<br />

Flaschenhals der Kommunikation im Arbiter ist damit beseitigt.<br />

Die Idee dieses lokalisierten Ansatzes ist es, den Bus innerhalb jeder ComputingPage<br />

mit Hilfe von Registern in beide Richtungen zu isolieren. Anstelle eines einzigen<br />

Bussystems über alle Module hinweg, existieren damit mehrere kleinere Systeme. Jedes<br />

dieser kleineren Systeme kann somit zeitgleich genutzt werden. Eine bessere Auslastung<br />

der Systemressourcen ist nun möglich. Abbildung 4.2 verdeutlicht den Aufbau<br />

der Kommunikationsstrukturen zwischen beliebigen ComputingPages.<br />

Konkret enthält die Implementierung in jeder ComputingPage eine Liste aller Referenzen,<br />

die sie erreichen kann. Der GC besitzt nur die Liste der Wurzel-Knoten. Wenn ein<br />

GC-Zyklus startet, sendet er ein Signal zur Aktivierung an alle Wurzel-Knoten. Diese<br />

werden dadurch aktiviert, sie setzen ein Flag, das sie als besucht markiert und aktivieren<br />

ihrerseits alle ComputingPages aus der lokalen Referenzliste. Zur besseren Ausnutzung

4.2. TRAVERSIERUNG 29<br />

Computing Page (Adresse 3)<br />

Computing Page (Adresse 2)<br />

Computing Page (Adresse 1)<br />

LeftReferences RightReferences LeftReferences RightReferences<br />

LeftReferences<br />

RightReferences<br />

LeftOut<br />

RightIn<br />

LeftOut<br />

RightIn<br />

LeftOut<br />

RightIn<br />

LeftIn<br />

SweepOut<br />

Register<br />

RightOut LeftIn<br />

Register<br />

RightOut<br />

LeftIn<br />

Flag Flag Flag<br />

RightOut<br />

SweepIn SweepOut<br />

SweepIn SweepOut<br />

SweepIn<br />

Register<br />

Abbildung 4.2: Lokalisierter Bus zur <strong>Garbage</strong>-<strong>Collection</strong><br />

der Systemressourcen ist die Referenzliste aufgeteilt in Referenzen, die links, und solche,<br />

die rechts vom aktuellen Knoten liegen. Referenzen, die auf Objekte links von der<br />

aktuellen Position verweisen, brauchen nur über die lokalisierten Datenleitungen zu den<br />

linken Nachbarn gesendet werden. Der Bus in die rechte Richtung ist damit für andere<br />

Signale frei. Trotz einer besseren Ausnutzung der Ressourcen kann es zu Konflikten<br />

kommen, wenn ein Modul gleichzeitig ein von links kommendes Aktivierungssignal<br />

weiterleiten und selber ein Aktivierungssignal nach rechts senden will. Um hierbei Kollisionen<br />

zu vermeiden, dürfen Objekte den Bus nur dann selber verwenden, wenn sie<br />

nicht gerade ein anderes Signal weitersenden.<br />

Abbildung 4.3 zeigt beispielhaft eine Traversierung in der implementierten Datenstruktur.<br />

Jede der fünf nebeneinander angeordneten ComputingPages enthält ein Register<br />

mit Referenzen, die nach links und ein zweites Register für Referenzen, die nach<br />

rechts verweisen. Die Zahlen auf den Kanten entsprechend den Signalen, die zu einem<br />

festgelegten Zeitschritt auf den lokalisierten Bussystemen gesendet werden, die Zeilen<br />

entsprechen den einzelnen Zeitschritten der Traversierung. Zum Zeitschritt t = 4 tritt<br />

in der ComputingPage 3 einer der beschriebenen Buskonflikte auf. Das Modul muss<br />

das von rechts kommende Signal weiterleiten, und kann die eigene Referenz erst im<br />

nächsten Schritt versenden.<br />

Nach abgeschlossener Traversierung ist es im Sweep-Schritt erforderlich, der zentralen<br />

<strong>Garbage</strong>-<strong>Collection</strong>-Komponente im Arbiter mitzuteilen, welche ComputingPages bei<br />

der Traversierung aktiviert worden sind. Hierzu dient ein ein Bit breites Schieberegister,<br />

das als Sweep-Leitung bezeichnet wird. Bei der Traversierung wurde in jedem aktivierten<br />

Modul ein entsprechendes Flag gesetzt. Diese Flags sind in dem Schieberegister<br />

hintereinandergeschaltet und werden schrittweise zum Arbiter verschoben. Dieser setzt<br />

daraufhin für jedes nicht gesetzte Flag die korrespondierende ComputingPage auf die<br />

Liste der verfügbaren freien Logikressourcen.<br />

Ein weiteres Problem ist, dass bei der dezentralen Traversierung nicht fest steht, wann

30 KAPITEL 4. GARBAGE-COLLECTION IN HARDWARE<br />

Zeit<br />

ID 5 ID 4<br />

ID 3<br />

ID 2<br />

ID 1<br />

t=1<br />

1<br />

4<br />

5<br />

1<br />

3<br />

4<br />

5<br />

2<br />

FromArbiter<br />

ID 5<br />

ID 4<br />

ID 3<br />

ID 2<br />

ID 1<br />

t=2<br />

1<br />

4<br />

5<br />

1<br />

3<br />

4<br />

2<br />

5<br />

FromArbiter<br />

ID 5<br />

ID 4<br />

ID 3<br />