Diplomarbeit - Faculty of Computer Science - Technische Universität ...

Diplomarbeit - Faculty of Computer Science - Technische Universität ...

Diplomarbeit - Faculty of Computer Science - Technische Universität ...

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

TECHNISCHE UNIVERSITÄT DRESDEN<br />

Fakultät Informatik<br />

Institut für S<strong>of</strong>tware- und Multimediatechnik<br />

Pr<strong>of</strong>essur für <strong>Computer</strong>graphik und Visualisierung<br />

<strong>Diplomarbeit</strong><br />

Merkmalsbasiertes Morphing<br />

im Kontext einer webbasierten Bildergalerie<br />

Vorgelegt von: Christian Schubert<br />

Matrikelnummer: 3234139<br />

Abgabedatum: 31.12.2012<br />

Verantwortliche Hochschullehrer:<br />

Pr<strong>of</strong>. Dr. rer. nat. Stefan Gumhold<br />

Betreuer:<br />

Dipl.-Bioinf. Marcel Spehr, Pr<strong>of</strong>essur für <strong>Computer</strong>graphik und Visualisierung

Selbständigkeitserklärung<br />

Hiermit erkläre ich, dass die vorliegende Arbeit selbständig, unter Angabe aller Zitate und<br />

nur unter Verwendung der angegebenen Literatur und Hilfsmittel durch mich angefertigt<br />

wurde.<br />

Dresden, den 31.12.2012<br />

v

Inhaltsverzeichnis<br />

1 Einleitung 1<br />

1.1 Motivation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1<br />

1.2 Ziele . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2<br />

1.3 Struktur . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2<br />

2 Grundlagen 4<br />

2.1 Bilder . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4<br />

2.2 Morphing . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4<br />

2.2.1 Warping . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5<br />

2.2.2 Blending . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5<br />

2.2.3 Komposition . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5<br />

2.3 Warping-Ansätze . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7<br />

2.3.1 Klassifikation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7<br />

2.3.2 Strukturbasierte Methoden . . . . . . . . . . . . . . . . . . . . . . 9<br />

2.3.2.1 Gitternetze . . . . . . . . . . . . . . . . . . . . . . . . . . 9<br />

2.3.2.2 Dreiecksnetze . . . . . . . . . . . . . . . . . . . . . . . . . 10<br />

2.3.3 Strukturfreie Methoden . . . . . . . . . . . . . . . . . . . . . . . . 10<br />

2.3.3.1 Feldbasiertes Warping . . . . . . . . . . . . . . . . . . . . 11<br />

2.3.3.2 Kurvenbasiertes Warping . . . . . . . . . . . . . . . . . . 12<br />

2.3.4 Weitere Methode . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13<br />

2.4 Anwendungsgebiete und -beispiele . . . . . . . . . . . . . . . . . . . . . . 13<br />

2.4.1 Anwendungsgebiete . . . . . . . . . . . . . . . . . . . . . . . . . . 13<br />

2.4.2 S<strong>of</strong>tware . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 14<br />

2.4.3 Filme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15<br />

2.5 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17<br />

3 Forschungsarbeiten 18<br />

3.1 Image Morping for Space-Time Interpolation . . . . . . . . . . . . . . . . 18<br />

3.1.1 Beschreibung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 18<br />

3.1.2 Inhalt . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 18<br />

3.1.3 Prozessübersicht . . . . . . . . . . . . . . . . . . . . . . . . . . . . 20<br />

3.1.4 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . 21<br />

3.2 Silhouette-Aware Warping for Image-Based Rendering . . . . . . . . . . . 21<br />

vii

3.2.1 Beschreibung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 21<br />

3.2.2 Inhalt . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22<br />

3.2.3 Prozessübersicht . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25<br />

3.2.4 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . 26<br />

3.3 Photo Tourism: Exploring Photo Collections in 3D . . . . . . . . . . . . . 27<br />

3.3.1 Beschreibung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27<br />

3.3.2 Inhalt . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27<br />

3.3.3 Prozessübersicht . . . . . . . . . . . . . . . . . . . . . . . . . . . . 29<br />

3.3.4 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . 31<br />

3.4 Vergleich und Bewertung . . . . . . . . . . . . . . . . . . . . . . . . . . . 31<br />

3.5 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32<br />

4 Konzeption 34<br />

4.1 Ziel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34<br />

4.2 Zielkriterien . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34<br />

4.3 Allgemeiner Lösungsansatz . . . . . . . . . . . . . . . . . . . . . . . . . . 35<br />

4.4 Interpolationsansätze . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38<br />

4.4.1 Baryzentrische Interpolation . . . . . . . . . . . . . . . . . . . . . 38<br />

4.4.2 Bilineare Interpolation . . . . . . . . . . . . . . . . . . . . . . . . . 39<br />

4.4.3 Shepard-Interpolation . . . . . . . . . . . . . . . . . . . . . . . . . 40<br />

4.4.4 Gauß-Interpolation . . . . . . . . . . . . . . . . . . . . . . . . . . . 41<br />

4.4.5 Bilaterale Interpolation . . . . . . . . . . . . . . . . . . . . . . . . 42<br />

4.5 Gesamtstruktur . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 44<br />

4.6 Vorverarbeitung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 45<br />

4.6.1 Import . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 46<br />

4.6.1.1 Bildimport . . . . . . . . . . . . . . . . . . . . . . . . . . 46<br />

4.6.1.2 Grapherzeugung . . . . . . . . . . . . . . . . . . . . . . . 46<br />

4.6.1.3 Korrespondenzdetektion . . . . . . . . . . . . . . . . . . . 47<br />

4.6.2 Datenaufbereitung . . . . . . . . . . . . . . . . . . . . . . . . . . . 48<br />

4.6.2.1 Bildanpassung . . . . . . . . . . . . . . . . . . . . . . . . 48<br />

4.6.2.2 Bildmodifikation . . . . . . . . . . . . . . . . . . . . . . . 49<br />

4.6.2.3 Triangulierung . . . . . . . . . . . . . . . . . . . . . . . . 49<br />

4.6.3 Datenerzeugung . . . . . . . . . . . . . . . . . . . . . . . . . . . . 50<br />

4.6.3.1 Feldvorverarbeitung . . . . . . . . . . . . . . . . . . . . . 51<br />

4.6.3.2 Feldgenerierung . . . . . . . . . . . . . . . . . . . . . . . 51<br />

4.6.3.3 Feldnachbereitung . . . . . . . . . . . . . . . . . . . . . . 55<br />

4.6.4 Export . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 56<br />

4.6.4.1 Bildexport . . . . . . . . . . . . . . . . . . . . . . . . . . 56<br />

4.6.4.2 Feldexport . . . . . . . . . . . . . . . . . . . . . . . . . . 56<br />

4.6.4.3 Galerie-Export . . . . . . . . . . . . . . . . . . . . . . . . 56<br />

4.7 Präsentation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 57<br />

viii

4.7.1 Import . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 57<br />

4.7.2 Navigation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 57<br />

4.7.3 Rendering . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 57<br />

4.7.3.1 Blending . . . . . . . . . . . . . . . . . . . . . . . . . . . 58<br />

4.7.3.2 Morphing - Standard . . . . . . . . . . . . . . . . . . . . 59<br />

4.7.3.3 Morphing - Adaptiv . . . . . . . . . . . . . . . . . . . . . 59<br />

4.8 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61<br />

5 Implementierung 62<br />

5.1 Gesamtstruktur . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 62<br />

5.2 Datenformate . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 63<br />

5.2.1 P3P-Format . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 63<br />

5.2.1.1 Struktur . . . . . . . . . . . . . . . . . . . . . . . . . . . 63<br />

5.2.1.2 Generierung . . . . . . . . . . . . . . . . . . . . . . . . . 64<br />

5.2.2 WGL-Format . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 65<br />

5.2.2.1 Struktur . . . . . . . . . . . . . . . . . . . . . . . . . . . 65<br />

5.2.3 Korrespondenzfeld-Formate . . . . . . . . . . . . . . . . . . . . . . 67<br />

5.3 MorphGraphMaker . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 68<br />

5.3.1 Eigenschaften . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 68<br />

5.3.2 Systemanforderungen . . . . . . . . . . . . . . . . . . . . . . . . . 69<br />

5.3.3 Bibliotheken . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69<br />

5.3.4 Struktur . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 71<br />

5.3.5 Datenschicht . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 72<br />

5.3.6 Import . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 73<br />

5.3.7 Datenerzeugung . . . . . . . . . . . . . . . . . . . . . . . . . . . . 74<br />

5.3.8 Export . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 77<br />

5.3.9 Evaluation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 78<br />

5.3.10 Betriebsmodi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 80<br />

5.3.10.1 Dialog-Modus . . . . . . . . . . . . . . . . . . . . . . . . 80<br />

5.3.10.2 Batch-Modus . . . . . . . . . . . . . . . . . . . . . . . . . 85<br />

5.4 WebGLallery . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 91<br />

5.4.1 Eigenschaften . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 91<br />

5.4.2 Systemanforderungen . . . . . . . . . . . . . . . . . . . . . . . . . 92<br />

5.4.3 Bibliotheken . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 93<br />

5.4.4 Struktur . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 94<br />

5.4.5 Module . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 94<br />

5.4.5.1 Import . . . . . . . . . . . . . . . . . . . . . . . . . . . . 94<br />

5.4.5.2 Archiv . . . . . . . . . . . . . . . . . . . . . . . . . . . . 95<br />

5.4.5.3 Selektionsmodus . . . . . . . . . . . . . . . . . . . . . . . 95<br />

5.4.5.4 Präsentationsmodus . . . . . . . . . . . . . . . . . . . . . 95<br />

5.4.5.5 Renderer . . . . . . . . . . . . . . . . . . . . . . . . . . . 96<br />

ix

5.4.6 Bildübergang & Morphing . . . . . . . . . . . . . . . . . . . . . . . 98<br />

5.4.7 Benutzeroberfläche . . . . . . . . . . . . . . . . . . . . . . . . . . . 99<br />

5.4.7.1 Selektionsmodus . . . . . . . . . . . . . . . . . . . . . . . 99<br />

5.4.7.2 Präsentationsmodus . . . . . . . . . . . . . . . . . . . . . 100<br />

5.5 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 101<br />

6 Evaluation 102<br />

6.1 Ziel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 102<br />

6.2 Vorgehensweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 102<br />

6.3 Rahmenbedingungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 103<br />

6.4 Szene 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 104<br />

6.4.1 Beschreibung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 104<br />

6.4.2 Interpolationsverfahren . . . . . . . . . . . . . . . . . . . . . . . . 105<br />

6.4.3 Konfigurationsparameter . . . . . . . . . . . . . . . . . . . . . . . . 105<br />

6.4.4 Vorverarbeitung/Zwischenergebnisse . . . . . . . . . . . . . . . . . 105<br />

6.4.5 Ergebnisse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 106<br />

6.4.6 Auswertung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 107<br />

6.5 Szene 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 109<br />

6.5.1 Beschreibung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 109<br />

6.5.2 Interpolationsverfahren . . . . . . . . . . . . . . . . . . . . . . . . 110<br />

6.5.3 Konfigurationsparameter . . . . . . . . . . . . . . . . . . . . . . . . 110<br />

6.5.4 Vorverarbeitung/Zwischenergebnisse . . . . . . . . . . . . . . . . . 110<br />

6.5.5 Ergebnisse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 111<br />

6.5.6 Auswertung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 113<br />

6.6 Szene 3 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 114<br />

6.6.1 Beschreibung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 114<br />

6.6.2 Interpolationsverfahren . . . . . . . . . . . . . . . . . . . . . . . . 114<br />

6.6.3 Konfigurationsparameter . . . . . . . . . . . . . . . . . . . . . . . . 115<br />

6.6.4 Vorverarbeitung/Zwischenergebnisse . . . . . . . . . . . . . . . . . 115<br />

6.6.5 Ergebnisse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 116<br />

6.6.6 Auswertung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 118<br />

6.7 Problemanalyse - Bilaterale Interpolation . . . . . . . . . . . . . . . . . . 118<br />

6.7.1 Inhomogenes Warping . . . . . . . . . . . . . . . . . . . . . . . . . 119<br />

6.7.2 Bilaterale Gewichtung . . . . . . . . . . . . . . . . . . . . . . . . . 119<br />

6.7.3 Inverse Mapping . . . . . . . . . . . . . . . . . . . . . . . . . . . . 120<br />

6.8 Gesamtauswertung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 121<br />

6.9 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 122<br />

7 Ergebnisse und Ausblick 123<br />

7.1 Ergebnisse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 123<br />

7.2 Alternativer Lösungsansatz . . . . . . . . . . . . . . . . . . . . . . . . . . 125<br />

x

7.3 Ausblick . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 125<br />

xi

1 Einleitung<br />

1.1 Motivation<br />

Die digitale Bild-Metamorphose, welche im Allgemeinen als Morphing bezeichnet wird,<br />

findet heutzutage in allen Industrie-, Medien- sowie Wissenschaftsbereichen Anwendung,<br />

wo ein fließender Übergang zwischen zweidimensionalen Bilddaten erforderlich ist.<br />

Dabei ist durch die Vielzahl an verschiedenen Morphing-Verfahren, welche sich allesamt<br />

hinsichtlich ihrer Geschwindigkeit, Stabilität und Flexibilität voneinander unterscheiden,<br />

sowohl ein spezialisierter als auch ein generalisierter Einsatz möglich. Besonders in der<br />

Film- und Videoindustrie erfreut sich das Morphing seit langer Zeit sehr großer Beliebtheit<br />

und zählt heute mit zu den meistverbreiteten Effekten überhaupt, wenn es darum geht,<br />

Verwandlungen von Objekten oder Individuen bildlich darzustellen. Ein sehr bekanntes<br />

Beispiel hierfür stellt das populäre Musikvideo von Michael Jackson’s „Black or White“<br />

aus dem Jahre 1991 dar (siehe Abb 1.1).<br />

Abb. 1.1: Black or White - Musikvideo [MJJL91]<br />

Der Großteil der heute verfügbaren Morphing-Verfahren arbeitet, mit Ausnahme einiger<br />

spezialisierter Ansätze, überwiegend zweidimensional in der Bildebene. Probleme bei der<br />

Darstellung klassischer Tiefenphänomene wie Verdeckung oder Tiefenparallaxe werden <strong>of</strong>t<br />

dadurch umgangen, indem man bei der Wahl der Bildmotive größere Tiefenunterschiede<br />

vermeidet.<br />

Gerade aber für die Darstellung dreidimensionaler Szenen ist die Berücksichtigung der<br />

genannten Phänomene essentiell, damit für den Betrachter ein räumlicher Eindruck<br />

entstehen kann und er somit das Gesehene als „natürlich“ empfindet. Die Entwicklung<br />

entsprechender 3D-basierter Morphing-Ansätze stellt diesbezüglich neben weiteren<br />

Aspekten (u.a. höhere Flexibilität, Genauigkeit) seit einigen Jahren einen bedeutenden<br />

Forschungs- und Entwicklungsschwerpunkt dar.<br />

1

1 Einleitung<br />

1.2 Ziele<br />

Das primäre Ziel dieser Arbeit ist die Konzeption und Entwicklung einer S<strong>of</strong>twarelösung,<br />

die das Betrachten beliebiger, zweidimensionaler Bilddaten unter Anwendung<br />

verschiedener Morphing-Techniken innerhalb einer webbasierten Umgebung ermöglicht.<br />

Desweiteren soll untersucht werden, inwiefern sich klassische Morphing-Ansätze in Verbindung<br />

mit zusätzlich gewonnenen Tiefeninformationen für den interpolierten Bildübergang<br />

nutzen lassen und ob damit bekannte Aspekte der räumlichen Darstellung (z.B. tiefenabhängige<br />

Verdeckung, perspektivische Verzerrungen) realisierbar sind.<br />

Bezüglich der Zielstellung existieren verschiedene Aufgabenbereiche, welche im Folgenden<br />

kurz erläutert werden.<br />

• Recherche<br />

Gängige Ansätze des zweidimensionalen Morphings sollen recherchiert und kurz<br />

vorgestellt werden.<br />

• Akquisition<br />

Es sollen sowohl synthetische als auch fotobasierte Bilddaten für die Entwicklung<br />

und Evaluation verwendet werden.<br />

• Vorverarbeitung<br />

Es soll eine Applikation entwickelt werden, die die für das Morphing benötigten<br />

Daten aus einem gegebenen Bilddatensatz extrahiert, verarbeitet und in Form einer<br />

Bildergalerie mitsamt Zusatzdaten verfügbar macht.<br />

• Visualisierung<br />

Es soll ein Webfrontend entwickelt werden, das als eigenständiges Bildportal fungiert<br />

und somit das Betrachten von Bildern unter Verwendung verschiedener Morphing-<br />

Ansätze in Echzeit ermöglicht.<br />

• Evaluation<br />

Die Ergebnisse dieser Arbeit sollen nachfolgend evaluiert und bewertet werden.<br />

1.3 Struktur<br />

Im zweiten Kapitel werden zunächst die Grundlagen des Morphings schrittweise erarbeitet<br />

und vertieft. Der Fokus des dritten Kapitels liegt auf der Betrachtung und Analyse<br />

thematisch verwandter Arbeiten sowie einer anschließenden Gegenüberstellung. Im vierten<br />

Kapitel wird das Konzept der angestrebten S<strong>of</strong>twarelösung hinsichtlich Inhalt und<br />

Struktur präsentiert und erläutert. Die programmtechnische Umsetzung auf Basis des<br />

vorgestellten Konzeptes ist Gegenstand des fünften Kapitels. Im Mittelpunkt des sechsten<br />

2

1.3 Struktur<br />

Kapitels steht die Evaluation der S<strong>of</strong>twarelösung anhand verschiedener Beispielszenarien.<br />

Das siebte Kapitel schließt diese Arbeit mit einer kritischen Betrachtung der eigenen<br />

Ergebnisse und einem Ausblick auf zukünftige Entwicklungen ab.<br />

3

2 Grundlagen<br />

2.1 Bilder<br />

Die Grundlage für jede Form von Morphing bilden zweidimensionale, pixelbasierte Bilder,<br />

weshalb deren Definition das Fundament für die weiterführenden Ansätze und Methoden<br />

darstellt.<br />

Ein zweidimensionales Bild definiert eine Abbildung I(⃗x), die einen Vektor ⃗x ∈ R 2 auf<br />

einen Intensitäts- bzw. Farbwert c ∈ R abbildet [CL11].<br />

I : R 2 → R<br />

c = I(⃗x)<br />

Im Allgemeinen besitzt ein Bild eine rechteckige Struktur mit einer bestimmten Höhe und<br />

Breite, wodurch die Definitionsmenge der Abbildung I(⃗x) auf eine Untermenge P ⊂ R 2<br />

beschränkt wird.<br />

Ein digitales Bild besitzt darüber hinaus eine reguläre Gitterstruktur, die somit eine<br />

diskrete Quantisierung im Zuge der Abbildung von ⃗x nach c sowie gegebenfalls zusätzliche<br />

Filtermaßnahmen (z.B. Bilineare Filter) ermöglicht.<br />

2.2 Morphing<br />

Das Morphen von Bildern setzt sich grundlegend aus den beiden Teilschritten Warping<br />

und Blending (auch Cross-Dissolving genannt) zusammen, die dabei kontinuierlich in<br />

beliebig kleinen Teilschritten ausgeführt werden. Während Warping Formen und Geometrien<br />

innerhalb eines Bildes verändert, wird über das anschließende Blending der finale<br />

Intensitätswert für jeden Bildpunkt individuell berechnet [BN92, GW98].<br />

Morphing = Warping + Blending<br />

4

2.2 Morphing<br />

2.2.1 Warping<br />

Hauptaufgabe des Warpings ist das Verformen des Quell- und Zielbildes, sodass eine<br />

größtmögliche optische Übereinstimmung im Bildraum entsteht. Der Fokus liegt dabei<br />

auf der Abbildung T , die vor dem Auslesen des Intensitätswertes c auf einen gegebenen<br />

Vektor ⃗x ∈ R 2 ausgeführt wird.<br />

T : R 2 → R 2<br />

c = I(T (⃗x))<br />

2.2.2 Blending<br />

Blending beschreibt den Vorgang, bei dem mehrere Intensitäts- bzw. Farbwerte aus verschiedenen<br />

Quellen miteinander kombiniert werden. Für den einfachen Fall, dass nur zwei<br />

Bilder gemischt werden sollen, vereinfacht sich die Berechnung zu einer Linearkombination<br />

unter Verwendung eines Parameters α ∈ [0..1] [PD84].<br />

I(⃗x) = α · I 1 (⃗x) + (1 − α) · I 2 (⃗x)<br />

Abgesehen von der hier abgebildeten Blending-Vorschrift, welche u.a die Grundlage für<br />

das bekannte Alpha-Blending bildet, gibt es noch eine Vielzahl weiterer Verfahren zur<br />

Komposition von Farbwerten (z.B. additives Blending). Da in der Regel aber beim Wechsel<br />

von einem Quellbild I 1 zu einem Zielbild I 2 ein möglichst fließender und natürlicher<br />

Übergang angestrebt wird, sind diese im Kontext des Morphings von geringerer Bedeutung.<br />

2.2.3 Komposition<br />

Wie eingangs erwähnt, findet für die finale Intensitätswertberechnung die Kombination<br />

der Warping- und Blending-Schritte unter Berücksichtigung eines Parameters t ∈ [0..1]<br />

statt. Dabei wird zur Generierung eines Zwischenbildes I t eine gewicht- und invertierbare<br />

Warping-Funktion T sowohl auf das Quellbild I 1 als auch das Zielbild I 2 angewendet,<br />

sodass nachfolgend die ausgelesenen Intensitätswerte mittels Blending kombiniert werden<br />

können. Zur Veranschaulichung sind in Abbildung 2.1 die einzelnen Zwischenschritte<br />

exemplarisch dargestellt.<br />

I t ( x) ⃗ = (1 − t) · I 1 (Tt<br />

−1 (⃗x)) + t · I 2 (T 1−t (⃗x))<br />

Unter der Annahme, dass sich der Parameter t gleichmäßig nach Eins entwickelt, wird<br />

über die angegebene Formel ein rein lineares Morphing durchgeführt. Obwohl dies für<br />

5

2 Grundlagen<br />

Abb. 2.1: Black or White - Teilschritte für t = 0.5 [CL12, MJJL91]<br />

die meisten Anwendungsfälle ausreichend sein dürfte, ist darüber hinaus eine zusätzliche<br />

Übergangskontrolle durch Einbindung einer Transitionsfunktion D möglich [GW98].<br />

Dabei wird t, das als reeller Kontrollparameter fungiert, auf einen Parameter t ′ ∈ [0..1]<br />

abgebildet (siehe auch Abb. 2.2).<br />

D : [0..1] → [0..1]<br />

t ′ = D(t)<br />

Abb. 2.2: Transitionsfunktionen zur Abbildung von t auf t ′ (von links nach rechts):<br />

D(t) = t, D(t) = t 2 , D(t) = t (1/(1+sin(t∗π))) , D(t) = 1 2 + 1 2cos(π(t + 1))<br />

6

2.3 Warping-Ansätze<br />

2.3 Warping-Ansätze<br />

Warping gilt im Kontext des Morphings als der komplizierteste Teilschritt für die Berechnung<br />

des finalen Bildes, denn durch dieses wird die Grundlage für ein nahtloses Blending<br />

geschaffen. Darüber hinaus stellt es im Bereich der Bildverarbeitung ein komplexes<br />

Forschungsfeld dar, das bisweilen auch als Image Transformation bzw. Bildregistrierung<br />

bezeichnet wird.<br />

Da in diesem Bereich eine Vielzahl von Ansätzen existiert, die auf Basis unterschiedlicher<br />

Strukturen und Algorithmen die Transformation von Bildern erlauben, soll im Folgenden<br />

ein grundlegender Überblick über bekannte Ansätze gegeben werden.<br />

2.3.1 Klassifikation<br />

Abb. 2.3: Parametrisiertes Warping - Beispiele [CL11]<br />

Grundsätzlich wird beim Warping zwischen parametrisierten und nichtparametrisierten<br />

Methoden unterschieden [GM98].<br />

• Parametrisiertes Warping<br />

In diesen Bereich fallen parametrisierte Abbildungen, welche global auf das gesamte<br />

Bild angewendet werden. Die Grundlage entsprechender Abbildungen bildet dabei<br />

stets eine begrenzte Anzahl von Parametern, woraus sich die charakteristischen<br />

Abbildungseigenschaften sowie eine Dimensionsbegrenzung des Parameterraums<br />

ergeben. Wie in Abbildung 2.3 dargestellt, zählen unter anderem lineare und affine<br />

Transformationen zu dieser Klasse [GM98, CL11].<br />

• Nichtparametrisiertes Warping<br />

Alle Abbildungen aus dieser Klasse operieren nicht global unter Verwendung bestimmter<br />

Kontrollparameter, sondern transformieren jeden Punkt im Bildraum<br />

individuell. Entsprechende Methoden erlauben die lokale Auswertung bestimmter<br />

Charakteristika pro Bildpunkt, was zu einer weitaus höheren Flexibilität und somit<br />

einem breiteren Einsatzspektrum führt.<br />

Im Kontext des hier besprochenen Morphings für zweidimensionale Bilder definiert<br />

sich das nichtparametrisierte Warping demnach über eine Abbildung U : R 2 → R 2 ,<br />

7

2 Grundlagen<br />

die für jeden Vektor ⃗x ∈ R 2 einen Translationsvektor bereitstellt. Auf Basis dessen<br />

ergibt sich die weiter oben erwähnte Warping-Abbildung T (siehe 2.2.1) [CL11].<br />

T : R 2 → R 2<br />

U : R 2 → R 2<br />

T (⃗x) = ⃗x + U(⃗x)<br />

Bedingt durch die vielen Einsatzmöglichkeiten und Ansätze im Bereich des nichtparametrisierten<br />

Warpings ist es sinnvoll, zusätzlich weitere Klassifikationen und Betrachtungen<br />

durchzuführen.<br />

Eine weitere Kategorisierung ergibt sich aus der Unterscheidung nach vorwärts und<br />

rückwärts gerichtetem Warping (Forward Mapping bzw. Inverse Mapping) [CDK99,<br />

FDBF06, CL12].<br />

• Forward Mapping<br />

Bei dieser Klasse von Abbildungen wird jeder Bildpunkt im Ausgangsbild I 1 unter<br />

Einsatz von T so transformiert, dass sich am Ende das Zielbild I 2 ergibt (siehe Abb.<br />

2.4).<br />

⃗x ′ = T (⃗x)<br />

I 2 (⃗x ′ ) = I 1 (⃗x)<br />

• Inverse Mapping<br />

Im Gegensatz zum vorherigen Ansatz geht man hier den umgekehrten Weg. Ausgehend<br />

vom Zielbild I 2 , wird für jeden Bildpunkt an der Position ⃗x über die inverse<br />

Abbildung T −1 der Intensitätswert in I 1 an der Position ⃗x ′ ausgelesen (siehe Abb.<br />

2.5).<br />

⃗x = T −1 (⃗x ′ )<br />

I 2 (⃗x ′ ) = I 1 (⃗x)<br />

In der Praxis kommt vergleichsweise <strong>of</strong>t Inverse Mapping zum Einsatz, da bei der<br />

vorwärts gerichteten Abbildung unter Umständen Lücken im Zielbild entstehen können<br />

und darüber hinaus wegen potentieller Mehrfachbelegung für jeden Pixel im Zielbild ein<br />

Akkumulationspuffer benötigt wird.<br />

8

2.3 Warping-Ansätze<br />

Abb. 2.4: Schema - Forward Mapping [CL11]<br />

Abb. 2.5: Schema - Inverse Mapping [CL11]<br />

2.3.2 Strukturbasierte Methoden<br />

Das Hauptmerkmal bei dieser Familie von Warping-Verfahren ist das Verformen von<br />

Bildflächen mittels topologisch starrer Strukturen innerhalb des Bildraums. Im Allgemeinen<br />

handelt es sich dabei um Netzstrukturen, die sich aus Kanten und Knoten<br />

zusammensetzen.<br />

2.3.2.1 Gitternetze<br />

Abb. 2.6: Gitterbasiertes Warping: Korrespondierende Gitterstrukturen [FDBF06]<br />

Wie in Abbildung 2.6 dargestellt, wird bei gitterbasierten Verfahren ein beliebiges<br />

Gitternetz verwendet, um darüber das Warping zu realisieren. Die Gitterknoten werden<br />

9

2 Grundlagen<br />

dabei auf markante Bildbereiche („Features“) gelegt, um so eine Approximation der<br />

Konturen und Strukturen im Ausgangs- und Zielbild zu erreichen. Für die Interpolation<br />

der Differenzvektoren wird in der Regel die bilineare Interpolation verwendet, da aufgrund<br />

der gitterbasierten Quantisierung ein Bildpunkt immer nur einem Gitterfeld zugeordnet<br />

werden kann. Eine Erweiterung dieses Ansatzes stellt der Einsatz sogenannter B-Spline-<br />

Patches dar [Wol96, GW98, GS98].<br />

2.3.2.2 Dreiecksnetze<br />

Den Kern beim Warping mittels Dreiecksnetzen stellt die Partitionierung des Gesamtbildes<br />

in unterschiedlich große Dreiecksflächen dar. Diese wurden im Vorfeld auf Basis<br />

automatisch oder manuell gesetzter Kontrollpunkte unter Anwendung eines geeigneten<br />

Triangulationsverfahrens (z.B. Delaunay-Triangulierung) erzeugt.<br />

Die Interpolation verhält sich bei diesem Ansatz analog zum gitternetzbasierten Warping,<br />

wobei zur Vektorberechnung eines Punktes innerhalb eines Dreiecks in der Regel die<br />

baryzentrische Interpolation verwendet wird [FDBF06].<br />

Abb. 2.7: Dreiecksbasiertes Warping: Dreiecks-zu-Dreiecks-Korrespondenz in beiden<br />

Bildern<br />

Bei diesem Ansatz ist es essentiell, dass eine durchgehende Dreiecks-zu-Dreiecks-<br />

Korrespondenz vorliegt (siehe Abb. 2.7). Im Detail bedeutet dies, dass für jedes<br />

Korrespondenz-Tripel sowohl im Ausgangs- als auch im Zielbild ein Dreieck erzeugt<br />

wird. Dadurch ergibt sich für beide Netze eine identische Topologie, wodurch die Bilder<br />

affin aufeinander abgebildet werden können. [ACOL00, CL11]<br />

2.3.3 Strukturfreie Methoden<br />

Warping-Ansätze dieser Kategorie zeichnen sich in erster Linie dadurch aus, dass sie ohne<br />

eine diskrete Unterteilung des Bildraumes arbeiten und das Warping eines Punktes ohne<br />

räumliche Zuordnung geschieht. Analog zu den strukturbasierten Verfahren gibt es hier<br />

10

2.3 Warping-Ansätze<br />

korrespondierende Kontrollpunkte im Bildraum des Ausgangs- und Zielbildes, welche<br />

jedoch nicht topologisch geordnet sind.<br />

2.3.3.1 Feldbasiertes Warping<br />

Abb. 2.8: Feldbasiertes Warping: Korrespondierende Kontrolllinien [CL12]<br />

Das zentrale Element dieses durch Beier und Neely [BN92] entwickelten Algorithmus<br />

bilden korrespondierende Kontrolllinien (siehe Abb. 2.8), die affin aufeinander abgebildet<br />

werden. Während Bildpunkte, welche direkt auf den Linien liegen, unmittelbar transformiert<br />

werden können, ergeben sich die Abbildungen für alle anderen Punkte durch die<br />

gewichteten Summen der Transformationen aller umgebenden Linienpaare [BN92,GW98].<br />

Abb. 2.9: Beier-Neely Algorithmus: Berechnung von Punkt X ′ [BN92, CL12]<br />

Zu beachten ist, dass das feldbasierte Warping nach dem rückwärts gerichteten Abbildungsprinzip<br />

(Inverse Mapping) arbeitet und demnach stets vom Zielbild ausgegangen<br />

wird. Im ersten Schritt werden für einen Punkt X die relativen Koordinaten u i und v i<br />

zu jeder Linie L i berechnet. Durch diese Koordinaten, die als konstant vorausgesetzt<br />

werden, wird im Quellbild für jede Linie L i die transformierte Punktposition X ′ i und<br />

anschließend der Differenzvektor D i = X ′ i − X i berechnet. Den Abschluß bildet die<br />

11

2 Grundlagen<br />

gewichtete Summierung aller Differenzvektoren unter Berücksichtigung des orthogonalen<br />

Abstandes zwischen einer Linie L i und dem Punkt X sowie der Linienlänge im Zielbild<br />

(siehe auch Abb. 2.9).<br />

2.3.3.2 Kurvenbasiertes Warping<br />

Eine weitere Form des Warpings stellt der Einsatz stetig differenzierbarer Funktionen<br />

dar, durch die sehr fließende und weiche Bewegungen im Bild realisiert werden können.<br />

Die Grundlage bildet dabei stets eine Menge von Stützstellen, die sich z.B aus einer<br />

automatischen oder auch manuellen Extraktion von korrespondierenden Punkten in den<br />

Quellbildern ergibt.<br />

Ein bekanntes Beispiel stellen radiale Basisfunktionen (Radial Basis Functions, RBF)<br />

[FDBF06, CK08] dar. Wie in Abbildung 2.10 dargestellt, sind diese radialsymmetrisch<br />

und ergeben durch gewichtetes Summieren eine harmonisch verlaufende Kurve bzw.<br />

Oberfläche, die alle Stützstellen interpoliert.<br />

Abb. 2.10: Radiale Basisfunktionen: 1D-Interpolation [FDBF06]<br />

Eine Funktion f(x), die alle N gegebenen Stützstellen interpoliert, ergibt sich aus der<br />

Linearkombination von N radialen Basisfunktionen mit jeweils eigenem Zentrum c i und<br />

einem individuellen Gewichtungsfaktor w i .<br />

r i = x − c i<br />

N∑<br />

f(x) = w i ϕ(r i )<br />

i=1<br />

Obwohl sich grundsätzlich jede radialsymmetrische Funktion ϕ(r) als Basisfunktion<br />

(auch Kernel genannt) eignet, gibt es einige Funktionstypen, die sich aufgrund ihrer<br />

12

Eigenschaften besonders hierfür anbieten [CK08, SASEJK09].<br />

• Gaußsche RBF: ϕ(r) = e −(cr)2<br />

• Multiquadric RBF: ϕ(r) = √ 1 + (cr) 2<br />

1<br />

• Inverse Multiquadrics RBF: ϕ(r) = √<br />

1+(cr) 2<br />

• Thin Plate Spline: ϕ(r) = r 2 ln r<br />

2.4 Anwendungsgebiete und -beispiele<br />

Nachdem eine passende Basisfunktion gewählt wurde, ist es notwendig, für alle N<br />

Basisfunktionen die zugeordneten Gewichtungsfaktoren w i zu finden. Dies erreicht man<br />

durch Aufstellen und Lösen eines Gleichungssystems mit N Unbekannten unter Beachtung<br />

der Interpolationsbedingung f(x i ) = y i mit i ∈ {1, .., N}.<br />

2.3.4 Weitere Methode<br />

Neben den hier vorgestellten Verfahren gibt es noch eine Vielzahl von Ansätzen, durch<br />

die ebenfalls ein Warping bzw. eine Bildregistrierung realisiert werden kann. Dazu zählen<br />

unter anderem Energie-Minimierungs-Methoden [SYLKYCJHSYS96, GW98], Multilevel-<br />

Freiformdeformationen (MFFD) [LCS95] oder auch einfache, distanzbasierte Verfahren<br />

zur Interpolation der k-nächsten Stützstellen (z.B. Shepard-Interpolation [She68]). All<br />

diese Methoden haben gemein, dass sie im Normalfall auf bereits bekannten Techniken<br />

aufbauen und dadurch <strong>of</strong>t eine hybride Charakteristik aufweisen. So ist es möglich, dass<br />

sie bis zu einem bestimmten Grad strukturgebunden arbeiten können und darüber hinaus<br />

Methoden des strukturfreien Warpings verwenden (z.B. farbabhängige Bildraumaufteilung<br />

mit anschließender Freiformdeformation).<br />

Einen anderen Ansatz stellt die Verwendung des Optischen Flusses dar, der unter<br />

optimalen Bedingungen für ein gegebenes Bildpaar ein Differenzvektorfeld berechnet und<br />

dadurch ein individuelles Verzerren auf Bildpunktebene ermöglicht [SM07, WTP + 09].<br />

2.4 Anwendungsgebiete und -beispiele<br />

2.4.1 Anwendungsgebiete<br />

Neben der Film- und Unterhaltungsindustrie, die das wichtigste Einsatzgebiet darstellt,<br />

gibt es diverse andere Bereiche, wo die Verwendung von Morphing Vorteile hinsichtlich<br />

13

2 Grundlagen<br />

der Ausgabequalität und/oder dem Arbeitsaufwand mit sich bringt.<br />

• Medizin und Biologie (z.B. CT/MRT-Aufnahmen)<br />

• Kartografie (z.B. stufenlose Kartendarstellung)<br />

• Meteorologie (z.B. Wetterphänomene visualisieren)<br />

• Materialforschung (z.B. grafische Simulation von Materialprozessen)<br />

• Foto- und Bildverarbeitung<br />

2.4.2 S<strong>of</strong>tware<br />

Zum gegenwärtigen Zeitpunkt existiert eine Vielzahl von Programmen, welche das Morphing<br />

von Bildern und Videos auf unterschiedlichen Plattformen erlauben. Neben proprietärer<br />

S<strong>of</strong>tware existiert dabei eine Reihe von Open Source- und Freeware-Anwendungen,<br />

die entweder separat oder in Verbindung mit anderen Programmen nutzbar sind.<br />

Proprietär<br />

• FantaMorph (Abros<strong>of</strong>t) 1<br />

• Photo Morpher (Morpheus) 2<br />

• FaceMorpher (Luxand Development) 3<br />

• MorphMan (Stoik) 4<br />

• Fun Morph (ZEALLSOFT Inc.) 5<br />

Freeware/Open Source<br />

• WinMorph (DebugMode) 6<br />

• FotoMorph (Digital Photo S<strong>of</strong>tware) 7<br />

• Sqirlz Morph (Xiberpix) 8<br />

1 http://www.fantamorph.com/index.html, Zugriff am 2.9.2012<br />

2 http://www.morpheuss<strong>of</strong>tware.net/, Zugriff am 2.9.2012<br />

3 http://www.luxand.com/, Zugriff am 2.9.2012<br />

4 http://www.stoik.com/products/video/STOIK-MorphMan/, Zugriff am 2.9.2012<br />

5 http://www.zealls<strong>of</strong>t.com/fun-morph.html, Zugriff am 2.9.2012<br />

6 http://www.debugmode.com/winmorph/, Zugriff am 2.9.2012<br />

7 http://www.diphso.no/FotoMorph.html, Zugriff am 2.9.2012<br />

8 http://www.xiberpix.net/SqirlzMorph.html, Zugriff am 2.9.2012<br />

14

2.4 Anwendungsgebiete und -beispiele<br />

2.4.3 Filme<br />

Der Einsatz von Morphing ist heutzutage in vielen Bereichen weit verbreitet und insbesondere<br />

für Filmproduktionen steht eine Vielzahl verschiedener Verfahren zur Verfügung,<br />

um so bestmöglich Deformationen und Verwandlungen von Objekten oder Individuen<br />

darzustellen. Diesbezüglich werden im Folgenden einige bedeutende Produktionen kurz<br />

vorgestellt.<br />

• Hunger<br />

„Hunger“ ist ein kanadischer Kurzfilm aus dem Jahre 1974, welcher unter Regie von<br />

Peter Foldes produziert wurde und zum Zeitpunkt seiner Veröffentlichung verschiedene<br />

Preise gewinnen konnte (u.a. Cannes Film Festival 1974). Die Animationen<br />

im Film basieren komplett auf dem Morphen der Konturlinien, welche vorwiegend<br />

vor einfarbigen Hintergründen dargestellt werden (siehe Abb. 2.11). Er zählt zu den<br />

ersten computeranimierten Filmen überhaupt [NRCoC, NFBoC].<br />

Abb. 2.11: Hunger (1974) [NFBoC]<br />

• Willow<br />

Der Fantasyfilm „Willow“ von 1988 gilt heute als der erste Film, in dem neben diversen<br />

anderen Spezialeffekten auch erstmalig Morphing zum Einsatz kam. Die enthaltene<br />

Morphing-Sequenz ist vergleichsweise kurz (siehe Abb. 2.12), galt aber dennoch zum<br />

damaligen Zeitpunkt als revolutionär und wegweisend. [GLRHJJNW88, fil].<br />

Abb. 2.12: Willow (1988) [GLRHJJNW88]<br />

• Black or White<br />

Im Musikvideo zu Michael Jackson’s „Black or White“, das im Jahre 1991 veröffentlicht<br />

wurde, kommt eine Morphing-Sequenz vor, die auch heute noch in Arbeiten zum<br />

15

2 Grundlagen<br />

Thema Morphing referenziert wird. In der Sequenz sind die Gesichter von Personen<br />

unterschiedlicher Ethnien zu sehen, welche den Betrachter anlächeln und sich passend<br />

zur Musik bewegen. Dabei wird in unregelmäßigen Abständen unter Anwendung<br />

von Gesichts-Morphing zwischen den verschiedenen Personen gewechselt(siehe Abb.<br />

2.13), wodurch harte Schnitte vermieden werden und die zentrale Botschaft des<br />

Liedes, dass alle Menschen gleich sind, unterstrichen wird [MJJL91].<br />

Abb. 2.13: Black or White (1991) [MJJL91]<br />

• Terminator 2: Judgment Day<br />

Der Actionfilm „Terminator 2“ aus dem Jahr 1992 galt zum Zeitpunkt seiner Veröffentlichung<br />

als der Film mit den meisten und besten visuellen Effekten in der<br />

Filmindustrie. Erstmalig wurden dabei in größerem Umfang computergenerierte<br />

Spezialeffekte (sog. CGI-Effekte) zur Darstellung von Personen, Umgebungen sowie<br />

unnatürlichen Phänomenen (siehe Abb. 2.14) eingesetzt. [JCWWJSAGAH92].<br />

Abb. 2.14: Terminator 2: Judgment Day (1992) [JCWWJSAGAH92]<br />

• Matrix<br />

1999 stellte der Film „The Matrix“ aufgrund der enthaltenen Spezialeffekte einen weiteren<br />

Meilenstein in der Filmindustrie dar. Ein Grund hierfür war unter anderem der<br />

häufige Einsatz der sogenannten „Bullet Time“ (siehe Abb. 2.15), wodurch vorallem<br />

schnelle Ereignisse (z.B. Sprünge, Explosionen) in ihrer Bedeutung unterstrichen und<br />

vom Betrachter besser wahrgenommen werden. Charakteristisch für diesen Effekt<br />

ist die beträchtliche Verlangsamung bzw. das Einfrieren der Filmzeit, während die<br />

Kamera auf ein bestimmtes Objekt/Akteur fokussiert ist und sich unabhängig von<br />

der Zeit bewegt [PDGS, AWLWJS99].<br />

16

2.5 Zusammenfassung<br />

Abb. 2.15: The Matrix (1999) [AWLWJS99]<br />

2.5 Zusammenfassung<br />

Im Zuge dieses Kapitels wurden alle fundamentalen Aspekte des Morphings, welche<br />

für diese Arbeit von Relevanz sind, schrittweise erarbeitet. Beginnend mit der Definition<br />

von Bildern und Morphing, wurden anschließend grundlegende Warping-Methoden,<br />

S<strong>of</strong>twarelösungen sowie bekannte Anwendungsbeispiele vorgestellt und erörtert.<br />

17

3 Forschungsarbeiten<br />

Im Mittelpunkt dieses Kapitels steht die Betrachtung von drei wissenschaftlichen Arbeiten,<br />

welche thematisch eng mit der hier vorliegenden Arbeit verwandt sind. Neben einer<br />

inhaltlichen und strukturellen Betrachtung geht es hierbei insbesondere um das Aufzeigen<br />

und Erörtern der zentralen Lösungsansätze, auf denen die Arbeiten aufbauen.<br />

3.1 Image Morping for Space-Time Interpolation<br />

3.1.1 Beschreibung<br />

Der inhaltliche Schwerpunkt der im Jahr 2007 durch Timo Stich und Marcus Magnor<br />

veröffentlichten Arbeit „Image Morping for Space-Time Interpolation„ [SM07] liegt auf der<br />

Präsentation eines wahrnehmungsbasierten Morphing-Ansatzes zur Darstellung komplexer<br />

Szenen. Unter Beachtung psychovisueller Faktoren ermöglicht die vorgestellte Methode<br />

das Morphen von Bildsequenzen, welche sowohl große Tiefenunterschiede als auch Objektverdeckungen<br />

aufweisen. Zudem ist der Ansatz weder von einer im Vorfeld durchgeführten<br />

Kamerakalibrierung noch von einer dreidimensionalen Szenenrekonstruktion abhängig,<br />

wodurch er sich für das Morphen beliebig akquirierter Bilddaten eignet.<br />

3.1.2 Inhalt<br />

Den Anfang der Arbeit bildet eine kompakte Einführung in die grundlegenden Aspekte<br />

des Morphings, der sich ein Überblick über die visuelle Wahrnehmung des Menschen<br />

anschließt. Im Fokus stehen dabei der Formpfad (form pathway) und der Bewegungspfad<br />

(motion pathway), welche beide durch das visuelle Zentrum des menschlichen Gehirns<br />

wahrgenommen werden und für das Erkennen einer physikalisch plausiblen Bewegung<br />

gleichermaßen notwendig sind. Der Formpfad bezeichnet dabei das Wahrnehmen von<br />

markanten Eigenschaften (z.B. der Kontur) bei aufeinanderfolgenden Einzelbildern,<br />

worüber Objekte letztlich wiedererkannt werden. Der Bewegungspfad hingegen basiert auf<br />

der Analyse des Optischen Flusses und dem Vergleichen mit bekannten Bewegungsmustern<br />

(z.B. Rotation, der menschliche Gang). Beide Faktoren sind demnach für das menschliche<br />

Sehen und Verstehen essentiell.<br />

18

3.1 Image Morping for Space-Time Interpolation<br />

Abb. 3.1: Links Ausgangsbild, rechts Zielbild [SM07]<br />

Nach Betrachtung der psychovisuellen Aspekte wird der Einsatz des Optischen Flusses im<br />

Kontext des Morphings erläutert. Dieser wird in einem nachgeschalteten Verarbeitungsschritt<br />

zur Korrektur von fehlerhaften Warping-Vektoren verwendet, damit so die effektive<br />

Bilddifferenz minimiert werden kann. Magnor und Stich weisen diesbezüglich darauf hin,<br />

dass die alleinige Anwendung des Optischen Flusses nicht für das Warping geeignet ist<br />

und vorallem bei großen Bilddifferenzen sowie Verdeckungen fehlerhaft arbeitet.<br />

Abb. 3.2: Fehlermaske (fehlerhafte Bereiche sind weiß) [SM07]<br />

Die Klassifizierung der Bilddifferenz ist ein weiterer Aspekt der hier vorgestellten Arbeit.<br />

Die Basis hierfür bilden dabei stets das Ausgangs- und Zielbild (siehe Beispiel 3.1), welche<br />

beide in den CIELAB-Farbraum übertragen werden. Zusätzlich wird das Ausgangsbild<br />

mittels vorberechneter Warping-Daten auf das Zielbild abgebildet. Im Anschluss daran<br />

wird die Differenz zwischen beiden Bildern berechnet und in einer monochromen Maske<br />

(siehe Abb. 3.2) gespeichert.<br />

Die erzeugte Fehlermaske dient als Datengrundlage für das sogenannte nichtlineare<br />

Blending, das nun zum Einsatz kommt. Im Kern findet dabei pro Bildpunkt ein adaptives<br />

Blending der Quellfarben mittels einer speziellen Logistikfunktion (Sigmoidfunktion)<br />

statt, welche neben dem eigentlichen Blendingparameter t den vorberechneten Fehlerwert<br />

nutzt. Daraus resultiert ein nahezu lineares Blending für Bildbereiche mit geringem<br />

19

3 Forschungsarbeiten<br />

Fehlerwert, während besonders fehlerhafte Bereiche stark verzögert mit einem schnellen<br />

Sprung geblendet werden (siehe Abb. 3.3). An diesem Punkt wird den Erkenntnissen<br />

über die visuelle Wahrnehmung beim Menschen Rechnung getragen, da aus Sicht der<br />

Autoren Ghosting-Artefakte und Farbsprünge negativer gewertet werden als ein optischer<br />

Stillstand.<br />

Den Abschluss der Arbeit bildet eine Vorstellung der prototypischen Implementierung<br />

sowie eine Auswertung der erzielten Ergebnisse.<br />

Abb. 3.3: Vergleich - links lineares Blending, rechts adaptives Blending [SM07]<br />

3.1.3 Prozessübersicht<br />

Der durch Stich und Magnor vorgestellte Lösungsansatz basiert auf einer Abfolge inhaltlich<br />

voneinander getrennter Teilschritte, welche im Folgenden aufgelistet werden.<br />

1. Feature- und Korrespondenzdetektion<br />

Erkennen von Merkmalen und Ermitteln der darauf basierenden Korrespondenzen<br />

im Ausgangs- und Zielbild.<br />

2. Feature-Animation<br />

Vorberechnung des Warpings mittels der Methode von Beier und Neely [BN92],<br />

wobei anstelle einer linearen Positionsinterpolation ein Rigid-As-Possible-Ansatz<br />

(siehe Alex et al. 2000 [ACOL00]) genutzt wird.<br />

3. Feature-Gewichtung<br />

Berechnung der Feature-Gewichtung auf Grundlage unterschiedlicher Faktoren (z.B.<br />

Abstand, Farbdifferenz).<br />

20

3.2 Silhouette-Aware Warping for Image-Based Rendering<br />

4. Prewarping<br />

Prewarping der beiden Quellbilder mittels vorberechneter Interpolationsgewichte<br />

und Warping-Daten.<br />

5. Optischer Fluss<br />

Berechnung des Optischen Flusses sowie die anschließende Korrektur der vorläufigen<br />

Warping-Vektoren.<br />

6. Fehlermaske<br />

Generierung einer monochromen Differenzmaske im CIELAB-Farbraum auf Basis<br />

der gewarpten Quellbilder.<br />

7. Warping<br />

Warping der Quellbilder sowie der Fehlermaske als erster Schritt im Morphing-<br />

Prozess.<br />

8. Blending<br />

Adaptives Blending des Ausgangs- und Zielbildes mithilfe der Fehlermaske unter<br />

Verwendung einer nichtlinearen, parametrisierten Logistikfunktion.<br />

3.1.4 Zusammenfassung<br />

Der in dieser Arbeit präsentierte Ansatz zur interpolierten Bildsynthese erlaubt die<br />

Darstellung von komplex aufgebauten Szenen, indem er die psychovisuellen Aspekte<br />

der menschlichen Wahrnehmung aktiv ausnutzt und adaptiv auf Pixelebene arbeitet.<br />

Er ermöglicht dadurch das Morphen von Bildsequenzen mit häufigen Objektverdeckungen<br />

und Tiefensprüngen, ohne dass störende Bildfehler (z.B. Ghosting-Artefakte) die<br />

Gesamtwirkung beeinträchtigen.<br />

3.2 Silhouette-Aware Warping for Image-Based Rendering<br />

3.2.1 Beschreibung<br />

Gegenstand der 2011 durch Chaurasia, Sorkine und Drettakis veröffentlichten Arbeit<br />

„Silhouette-Aware Warping for Image-Based Rendering“ [CSD11] ist die Präsentation eines<br />

Multiframe-basierten Morphing-Ansatzes. Unter Verwendung von kalibrierten Bildern<br />

sowie daraus extrahierten Punktwolken ermöglicht das Verfahren Silhouetten-erhaltendes<br />

Morphing von Szenen mit häufigen Objektverdeckungen und Tiefensprüngen.<br />

21

3 Forschungsarbeiten<br />

3.2.2 Inhalt<br />

Beginnend mit einer thematischen Einführung, findet zunächst eine grundlegende Betrachtung<br />

verschiedener Teilbereiche des bildbasierten Renderns (Image-based Rendering,<br />

IBR) statt. Unter anderem wird ein kurzer Überblick über die Bereiche Bildinterpolation<br />

und Warping gegeben, wobei hier neben Methoden und Anwendungsmöglichkeiten auch<br />

die Entwicklungen der letzten Jahre aufgezeigt werden.<br />

Abb. 3.4: Übersicht über die zentralen Teilschritte des vorgestellten Ansatzes [CSD11]<br />

Nachfolgend wird mit einer Übersicht über das entwickelte Verfahren mitsamt der dazugehörigen<br />

Teilschritte die Grundlage für den Rest der Arbeit gelegt. Im Fokus stehen<br />

dabei die drei zentralen Teilschritte Vorverarbeitung, Silhouetten-sensitives Warping<br />

und Rendering, welche aufeinander aufbauen und somit sequentiell ausgeführt werden<br />

müssen (siehe auch Abb. 3.4). Zu beachten ist, dass das Verfahren aufgrund der jeweiligen<br />

Teilschritte als Eingabedaten sowohl kalibrierte Bilder (inklusive Mehrfachansichten) als<br />

auch dichte 3D-Punktwolken vorraussetzt.<br />

Das Ziel der Vorverarbeitung ist die Bereitstellung von bildabhängigen Tiefeninformationen<br />

unter Berücksichtigung dominanter Bildflächen und Silhouetten. Im ersten Schritt<br />

findet eine manuelle Markierung der Silhouetten statt, da aus Sicht der Autoren automatisierte<br />

Algorithmen häufig zuviele bzw. falsche Konturen finden und die dadurch<br />

notwendigen Korrekturen noch zeitaufwendiger sind. Im Anschluss daran erfolgt eine bildabhängige<br />

Punktselektion auf Basis der gegebenen dreidimensionalen Punktwolke sowie<br />

den Kalibrierungsdaten. Hauptbestandteil des Selektionsprozesses ist eine Punktreduktion,<br />

bei der mittels konfigurierbarem Point-Splatting nur soviel Punkte auf die Bildebene<br />

abgebildet werden, dass eine bildfüllende Darstellung erreicht wird. Um Überdeckungen<br />

von Vordergrund- und Hintergrundpunkten sowie Tiefeninkonsistenz zu vermeiden, wird<br />

sowohl das Entfernen falsch zugeordneter Punkte als auch das Mitteln der Tiefenwerte<br />

auf Basis der markierten Silhouetten durchgeführt. Den Abschluß der Vorverarbeitung<br />

bildet das automatisierte Auffüllen leerer Bildbereiche mit zusätzlichen Stützpunkten<br />

und das optionale, manuelle Entfernen falscher Korrespondenzen.<br />

Das nachfolgende Image-Warping wird unter Berücksichtigung vorhandener Silhouetten<br />

22

3.2 Silhouette-Aware Warping for Image-Based Rendering<br />

durchgeführt und stellt im Kontext des vorgestellten Ansatzes den wichtigsten Zwischenschritt<br />

dar. Ihm zugrunde liegt eine Menge von Einzelbildern für die Darstellung der<br />

gleichen Szene sowie die vorverarbeiteten Punktwolken.<br />

Ziel ist es, eine Warpingfunktion W zu finden, welche alle einbezogenen Bilder bestmöglich<br />

und plausibel für das nachfolgende Blending verzerrt. Dazu wird zunächst über jedes<br />

Bild ein regelmäßiges Dreiecksgitter mit einer ausreichend hohe Vertex-Dichte gelegt. Als<br />

Nächstes werden die Energie-Funktionen E p , E s und E b definiert, die allesamt auf der<br />

Methode der kleinsten Quadrate aufbauen und als Nebenbedingungen für das Finden der<br />

optimalsten Warping-Funktion W : R 2 → R 2 benötigt werden.<br />

Abb. 3.5: Silhouetten-abhängige Unterteilung des vorhandenen Dreiecksnetzes [CSD11]<br />

Der Energie-Term E p dient als Kriterium für die Erhaltung der identischen Punktpositionen<br />

im dreidimensionalen Raum. Konkret bedeutet das für ein selektiertes Bild I i , dass<br />

jeder 3D-Punkt p ∈ P i und der korrespondierende 2D-Punkt q ∈ Q i unter Berücksichtigung<br />

der bildabhängigen Projektion C i auch nach dem Warping korrespondieren.<br />

Der Term E s fungiert als Kriterum für die Erhaltung der Formähnlichkeit. Bezogen<br />

auf das erzeugte Dreiecksnetz, versucht man darüber eine Warping-Funktion W mit<br />

der Eigenschaft der geringstmöglichen Dreiecksverzerrung und der maximalen lokalen<br />

Formerhaltung zu finden.<br />

Dem letzten Energieterm E b kommt eine besondere Bedeutung zu, da dieser als Hauptkriterium<br />

für die Erhaltung der Silhouetten während des Warping-Prozesses dient. Vorbedingung<br />

hierfür ist aber eine Modifikation des Dreiecksgitters, das entlang der markierten<br />

Kontur-Kanten zusätzlich mehrfach unterteilt werden muss (siehe Abb. 3.5). Die bei<br />

der Tesselierung erzeugten Dreiecke dienen als „elastisches“ Band und werden nicht<br />

vom Ähnlichkeitserhaltungs-Term E s berücksichtigt. Alle drei vorgestellten Energieterme<br />

werden nachfolgend gewichtet und zu einem Term E zusammengefasst.<br />

E(W ) = w p E p + w s E s + w b E b<br />

Die lineare Gleichung ∇E(W ) = 0 wird nun entsprechend des Minimierungsprinzips<br />

unter Verwendung eines geeigneten Gleichungsauflösers für das Finden der optimalsten<br />

23

3 Forschungsarbeiten<br />

Warpingfunktion W verwendet. Nach Abschluss dieses Schrittes besitzt jedes Eingabebild<br />

I i ein individuell angepasstes Dreiecksgitter sowie ein vorberechnetes Linearsystem, das<br />

zur Laufzeit für die Berechnung der Warpingfunktion W unter Berücksichtigung der<br />

interpolierten Projektion C n verwendet wird.<br />

Abb. 3.6: Rendering: (a) Warping (b) Texturkomposition (c) Blending (d) Bildoptimierung<br />

mittels Poisson-Synthese [CSD11]<br />

Den finalen Verarbeitungsschritt stellt das eigentliche Rendering dar. Hierbei werden<br />

zunächst die vier optimalsten Ansichten selektiert, um so eine stabile Berechnungsgrundlage<br />

zu schaffen. Anschließend findet das blickpunktabhängige Warping aller Bilder unter<br />

Verwendung der im Vorfeld berechneten Linearsysteme statt (erste Phase in Abbildung<br />

3.6). Ergebnis dieser Bildregistrierung ist die projektive Abbildung unterschiedlicher<br />

3D-Punkte mit gleicher Raumposition auf dieselbe 2D-Position im Ausgabebild.<br />

Der nächste Schritt ist das individuelle Blending der Quellbilder pro Bildpunkt. Dazu<br />

wird eine Auswahl der zwei besten Bilder mittels Raycasting durchgeführt, welches als<br />

Ergebnis den Winkel zwischen dem Raycasting-Strahl und dem Blickpunkt-Strahl im<br />

Quellbild I i sowie die Art der Trefferfläche zurückliefert (siehe Abb. 3.7). Auf Basis dessen<br />

findet die Berechnung eines Fehlerwertes statt, über den die Auswahl der beiden Bilder<br />

mit dem geringsten Fehler umgesetzt wird.<br />

Dieser Zwischenschritt resultiert in zwei Texturen R 0 und R 1 , die pro Bildpunkt die<br />

Farben und Blend-Gewichte des besten und zweitbesten Quellbildes enthalten. Das<br />

Ergebnis der Blend-Phase ist eine Textur R, die sich aus dem Überblenden von R 0 und<br />

R 1 ergibt (siehe Phase c in Abbildung 3.6).<br />

Da innerhalb der geblendeten Textur R räumliche Diskontinuitäten (z.B. Quellbild-<br />

Ränder) vorliegen können, wird in der letzten Phase eine Poisson-Synthese zur Bildoptimierung<br />

eingesetzt. Grundlage dafür bilden eine von R 0 abgeleitete Gradienten-Textur G<br />

sowie eine Divergenz-Textur divG. Beide Texturen werden nun für das iterative Lösen der<br />

Poisson-Gleichung ∇ 2 R ′ = divG in Abhängigkeit von ∇R ′ | B0 = 0 eingesetzt, wobei R ′ die<br />

optimierte Ausgabetextur und B 0 die Flächenränder in R 0 beschreibt. Das Ergebnis sind<br />

weiche Übergänge in kritischen Bereichen und eine Reduktion von Ghosting-Artefakten.<br />

24

3.2 Silhouette-Aware Warping for Image-Based Rendering<br />

Abb. 3.7: Links Strahlentest zur Bildauswahl, rechts gewarptes Bild mit elastischem Band<br />

(rot) und Freiflächen (blau) [CSD11]<br />

Der Vorstellung der einzelnen Prozessschritte schließt sich eine allgemeine Ergebnisbetrachtung<br />

an. Unter anderem wird aufgezeigt, dass im Vergleich zu vorherigen Arbeiten<br />

die Szenenrekonstruktion bekannter Testdatensätze deutlich weniger Speicher benötigt.<br />

Zusätzlich befinden sich im gleichen Abschnitt Informationen über das verwendete<br />

Testsystem sowie dazugehörige Leistungswerte.<br />

Den Abschluss bildet eine kurze Zusammenfassung der wichtigsten Aspekte und Eigenschaften<br />

des Verfahrens sowie nachfolgend ein Ausblick auf zukünftige Herausforderungen<br />

im Bereich des bildbasierten Renderings.<br />

3.2.3 Prozessübersicht<br />

Der Prozessablauf des beschriebenen Verfahrens zeichnet sich durch eine Reihe von<br />

Einzelschritten aus, die thematisch von einander getrennt sind und sukzessive aufeinander<br />

aufbauen. Die folgende Auflistung soll einen grundlegenden Überblick über die<br />

vorhandenen Teilschritte geben und diese kurz charakterisieren.<br />

1. Bildakquisition<br />

Gewinnung von kalibrierten Bilddaten, wobei durch die Multiframe-Eigenschaft des<br />

Verfahrens eine möglichst große Anzahl von Bildern einer Szene benötigt wird.<br />

2. Punktwolken-Generierung<br />

Globale Erzeugung einer dichten 3D-Punktwolke.<br />

3. Silhouetten-Extraktion<br />

Manuelle oder automatisierte Erfassung von dominanten Flächen und Konturen.<br />

4. Punktselektion<br />

Blickpunktabhängige Selektion von 3D-Punkten pro Quellbild sowie Einfügen zusätzlicher<br />

Punkte bei Leerflächen.<br />

25

3 Forschungsarbeiten<br />

5. Warping-Netz<br />

Erzeugung eines Dreiecksnetzes für jedes Quellbild I i .<br />

6. Warping-Energiefunktionen<br />

Bildabhängige Initialisierung der Energie-Funktionen E p , E s und E b als Kriterien<br />

für ein optimales Warping.<br />

7. Warping-Vorberechnung<br />

Berechnung einer optimalen Warping-Funktion W nach der Methode der kleinsten<br />

Quadrate mittels eines geeigneten Gleichungsauflösers. Zwischenspeichern des<br />

berechneten Linearsystems.<br />

8. Quellbild-Selektion<br />

Auswahl der vier geeignetsten Bilder, um darauf basierend das Rendering durchzuführen.<br />

9. Warping<br />

Bildregistrierung mittels Warping auf Basis des interpolierten Blickpunktes C n .<br />

10. Blending-Preprocessing<br />

Geometriebasiertes Raycasting zur Fehlerwertberechnung. Pro Bildpunkt Caching<br />

des besten und zweitbesten Quellbildpixels sowie der dazugehörigen Blend-Gewichte<br />

in den Texturen R 0 und R 1 .<br />

11. Blending<br />

Erzeugen des Ausgabebildes R durch Überblenden der Texturen R 0 und R 1 .<br />

12. Optimierung<br />

Optimierung und Korrektur von Blendfehlern durch eine Poisson-Synthese. Die<br />

Gradienten- und Divergenz-Texturen von R 0 dienen dabei als Berechnungsgrundlage.<br />

3.2.4 Zusammenfassung<br />

Das in dieser Arbeit vorgestellte Morphing-Verfahren ermöglicht eine fortschrittliche<br />

Form der interpolierten Bildsynthese unter Erhaltung aller relevanten Silhouetten. Auf<br />

Basis von kalibrierten Bilddaten wird zunächst ein mehrstufiger Prozess durchlaufen,<br />

welcher sowohl Konturen als auch Tiefenunterschiede berücksichtigt. Im Anschluss daran<br />

ist eine interpolierte Darstellung von nahezu jedem beliebigen Blickpunkt innerhalb der<br />

Szene möglich, ohne dass dabei Verdeckungsfehler auftreten.<br />

26

3.3 Photo Tourism: Exploring Photo Collections in 3D<br />

3.3 Photo Tourism: Exploring Photo Collections in 3D<br />

3.3.1 Beschreibung<br />

Im Fokus der 2006 veröffentlichten Arbeit „Photo Tourism: Exploring Photo Collections<br />

in 3D“ [ea06] steht die Präsentation einer komplexen Visualisierungslösung, die das<br />

interaktive Navigieren und Darstellen beliebiger Bildmengen einer Szene innerhalb einer<br />

dreidimensionalen Umgebung ermöglicht.<br />

3.3.2 Inhalt<br />

Nach einer thematischen Einführung in den Bereich der bildbasierten Modellierung<br />

und Darstellung von Szenen stellen die Autoren zunächst die Datenvorverarbeitung<br />

des Systems vor. Im Mittelpunkt steht dabei die geometrische Rekonstruktion einer<br />

Szene auf Basis einer ungeordneten Bildmenge, die manuell oder per Web-Anbindung<br />

(u.a. zu FlickR 1 ) erzeugt wurde. Im ersten Schritt werden die Bildmerkmale (Features)<br />

mittels des SIFT-Operators [Low04] gesucht und darauf aufbauend über den RANSAC-<br />

Algorithmus [FB87] Korrespondenzen ausfindig gemacht. Letztere werden, s<strong>of</strong>ern sie über<br />

mehr als zwei Bilder bestehen, in sogenannten Tracks organisiert (siehe Abb.3.8).<br />

Abb. 3.8: Quellbildmenge (links), Korrespondenzen (mitte), rekonstruierte Szene (rechts)<br />

[ea06]<br />

Im nächsten Schritt wird nun die eigentliche Rekonstruktion der Szene mittels einer<br />

Technik namens Structure from Motion(SfM ) realisiert. Im Kern handelt es sich dabei<br />

um nichtlineares Minimierungsproblem, das in diesem Fall iterativ berechnet wird. Als<br />

initiales Bildpaar wird das mit den meisten Korrespondenzen ausgewählt, da dies als<br />

die stabilste Berechnungsgrundlage gilt und so degenerierte Ergebnisse vermieden werden<br />

können. Schrittweise werden weitere Kameras der Optimierung hinzugefügt und<br />

parallel die äußeren Kameraparameter (d.h. Position, Orientierung usw.) durch die DLT-<br />

Methode (Direct Linear Transform) [HZ04] initialisiert. Die inneren Kameraparameter<br />

1 http://www.flickr.com/, Zugriff am 6.11.2012<br />

27

3 Forschungsarbeiten<br />

(z.B. Brennweite) werden primär mittels DLT geschätzt und über Zusatzinformationen<br />

aus den gegebenen Bilddateien (z.B. EXIF-Tags) ergänzt. Die geometrische Rekonstruktion<br />

erfolgt durch Hinzunahme der im Vorfeld erzeugten Tracks, wobei nur solche in<br />

die Berechnung einfließen, welche von mindestens einer bereits rekonstruierten Kamera<br />

erfasst werden. Wie in Abbildung 3.8 dargestellt, ist das Ergebnis im Idealfall eine dichte,<br />

räumliche Punktwolke sowie vollständige Kameraparameter für alle Ansichten.<br />

Den Abschluss der Vorverarbeitungsphase bildet die absolute Ausrichtung aller Raumdaten,<br />

wobei optional eine Georegistrierung der Szene über GPS-Daten (z.B. GPS-Tags)<br />

oder manuelle Eingaben durchgeführt werden kann. Die Registrierung ist notwendig,<br />

wenn der Einsatz einer interaktiven Navigationshilfe in Form einer Minikarte (siehe<br />

Abb.3.9) gewünscht wird.<br />

Abb. 3.9: Minikarte (mit grünem Standortsymbol) als Navigationshilfe [ea06]<br />

Hauptmerkmal der Präsentationsphase ist das interaktive Durchwandern und Entdecken<br />

der rekonstruierten 3D-Szene. Die Darstellung erfolgt dabei über einen zentralen Viewport,<br />

worüber sowohl die erzeugte Punktwolke als auch die eingebetteten Ansichten in<br />

Form von Bildebenen abgebildet werden.<br />

Für die Navigation stehen die Modi Freiflug, Ansichtsbasiert und Objektbasiert zur Auswahl.<br />

Der erste Modus ermöglicht das freie Erkunden der Szene, ohne dass Ansichten<br />

exklusiv im Viewport dargestellt werden. Der ansichtsbasierte Modus beinhaltet das<br />

Selektieren und Bewegen zwischen den expliziten Ansichten. Der objektbasierte Modus<br />

erlaubt hingegen die Auswahl und Darstellung von im Vorfeld identifizierten und<br />

annotierten Objekten über mehrere Ansichten hinweg.<br />

Der Wechsel zwischen den Ansichten kann über unterschiedliche Ansätze erfolgen. Zentraler<br />

Bestandteil ist dabei in jedem Fall die Sichttransformation durch lineares Interpolieren<br />

der Kamera zwischen dem Ausgangs- und Zielbild. Dabei ist zu beachten, dass das System<br />

die Position, die Orientierung und den Blickwinkel der Kamera getrennt voneinander<br />

interpoliert, um so degenerierte Transformationen zu vermeiden. Für die Berechnung von<br />

Zwischenbildern stehen zwei Verfahren zur Auswahl.<br />

• Planares Morphing<br />

Ausgehend von zwei Kameras C j und C k , wird eine Ebene durch planares Approxi-<br />

28

3.3 Photo Tourism: Exploring Photo Collections in 3D<br />

mieren der gemeinsamen Tracks erzeugt. Auf diese Ebene werden die beiden Bilder<br />

I j und I k projiziert und in Abhängigkeit von der Kamerabewegung linear geblendet.<br />

• Trianguliertes Morphing<br />

Zunächst findet in der Vorverarbeitungsphase eine Projektion aller Punkte, die<br />

durch die Kameras C j bzw. C k erfasst werden, sowie eine anschließende Delaunay-<br />

Triangulierung im Bildraum statt. Da im Allgemeinen nicht alle Bereiche einer<br />

Ansicht durch die Triangulierung abgedeckt werden können, wird zusätzlich ein<br />

reguläres Gitternetz eingefügt und die Gitterknoten, welche außerhalb der konvexen<br />

Hülle liegen, der Triangulierung hinzugefügt.<br />

Da jeder Punkt im Bildraum auch eine dreidimensionale Position benötigt, wird<br />

diese mittels Raycasting auf der gemeinsamen Ebene von C j und C k berechnet.<br />

Danach werden die räumlichen Netzmodelle durch Übertragen der Triangulierung<br />

für die Start- und Zielansicht erzeugt. Den Abschluss der Vorverarbeitung bildet das<br />

projektive Texturieren der Netzmodelle. Während des Bildwechsels werden nun die<br />

beiden Dreiecksnetze auf Basis der interpolierten Kameraparameter gerendert und<br />

abschließend die erzeugten Ansichten linear geblendet.<br />

Nachdem in den bisherigen Abschnitten der Fokus auf dem Import, der Aufbereitung<br />

und der Präsentation der Bilddaten lag, erläutern die Autoren im letzten Teil der Arbeit<br />

Möglichkeiten, wie bereits fertig rekonstruierte Szenen erweitert werden können.<br />

Eine Variante ist das Hinzufügen von neuen Bildern, ohne dass ein erneuter Durchlauf<br />

der Vorverarbeitungsphase notwendig ist. Hierzu wechselt der Nutzer in einen Übersichtsmodus,<br />

wo er die Szene von oben betrachtet und zusätzliche Bilder durch Drag’n’Drop<br />

hinzufügen kann. Falls ein Bild eingefügt wurde, werden wiederum Bildmerkmale mittels<br />

SIFT ermittelt und Korrespondenzen in den 20 nächsten Ansichten in der Szene<br />

gesucht. Anschließend werden die Kameraparameter des hinzugefügten Bildes auf Basis<br />

der selektierten Ansichten neu berechnet.<br />

Die bildübergreifende Annotation von Objekten ist eine weitere Option, eine bestehende<br />

Szene zu ergänzen. Zuallererst wird dazu ein Objekt in der aktuellen Ansicht selektiert<br />

und über einen Eingabedialog mit Metadaten (z.B. Text, Weblinks) versehen. Nachfolgend<br />

werden dann diese Informationen durch das System auf alle Ansichten übertragen, welche<br />

exakt das gleiche Objekt abbilden. Zusätzlich zu der hier beschriebenen Methode gibt es<br />

die Möglichkeit, durch die Anbindung an bekannte Bildportale wie FlickR automatisiert<br />

Annotationen in das System zu übertragen.<br />

3.3.3 Prozessübersicht<br />

Da der Bildwechsel im beschriebenen System auch mittels bildbasiertem Morphing<br />

möglich ist, soll im Folgenden ein Überblick über dafür notwendigen Teilschritte gegeben<br />

werden.<br />

29

3 Forschungsarbeiten<br />

1. Bildakquisition<br />

Akquisition von Bilddaten einer Szene aus verschiedenen Quellen, wobei sowohl unkalibrierte<br />

als auch kalibrierte Fotos möglich sind (<strong>of</strong>fline oder per Web-Anbindung).<br />

2. Feature- und Korrespondenzdetektion<br />

Automatisiertes Finden von Bildmerkmalen mittels des SIFT-Operators [Low04].<br />

Anschließend werden mittels des RANSAC-Algorithmus [FB87] Korrespondenzen<br />

zwischen Bildpaaren gesucht und diese für multiple Bilder in sogenannten Tracks<br />

organisiert.<br />

3. Szenenrekonstruktion<br />

Rekonstruktion der Kameraparameter sowie der 3D-Positionen aller Tracks. Optional<br />

findet eine Linienrekonstruktion innerhalb der Szene statt.<br />

4. Punktprojektion<br />

Projektion aller Punkte, die durch die Start- bzw. Zielkamera erfasst werden.<br />

5. Triangulierung<br />

Auf Basis der projizierten Punkte wird im Bildraum eine Delaunay-Triangulierung<br />

durchgeführt.<br />

6. Planares Gitternetz<br />

Einfügen eines regelmäßigen Gitters, wo jeder Knoten außerhalb der konvexen Hülle<br />

des Dreiecksnetzes der Triangulierung hinzugefügt wird. Die 3D-Position wird durch<br />

Raycasting auf der Tracks-Ebene (approximiert alle gleichzeitig sichtbaren Punkte)<br />

gewonnen.<br />

7. Räumliches Dreiecksnetz<br />

Auf Basis der im Bildraum durchgeführten Triangulierungen wird für die Start- und<br />

Zielansicht jeweils ein korrespondierendes, dreidimensionales Netzmodell erzeugt.<br />

8. Projektive Texturierung<br />

Ausgehend vom jeweiligen Blickpunkt, werden mittels projektiver Texturierung<br />

die Texturkoordinaten für die dreidimensionalen Netze der Start- und Zielansicht<br />

berechnet.<br />

9. Sichtinterpolation<br />

Während des Bildübergangs werden die Kameraposition, die Orientierung sowie der<br />

Blickwinkel getrennt voneinander interpoliert.<br />

10. Rasterisierung<br />

Über den interpolierten Blickpunkt werden die Dreiecksnetze getrennt voneinander<br />

gerendert und zwischengespeichert<br />

11. Blending<br />

Entsprechend des relativen Abstandes der interpolierten Kameraposition zur Startund<br />

Zielposition, werden die gerenderten Zwischenansichten linear geblendet.<br />

30

3.4 Vergleich und Bewertung<br />

3.3.4 Zusammenfassung<br />

Snavely et al. haben in dieser Arbeit ein sehr flexibles und komplexes Visualisierungssystem<br />

vorgestellt, das die Akquisition, Rekonstruktion sowie Darstellung von komplexen<br />

Szenen auf Basis von unstrukturierten Bildmengen erlaubt. Die Fähigkeit, beliebige<br />

Bilder einer Szene für die räumliche Rekonstruktion der Geometrie- und Kameradaten<br />

verwenden zu können, macht das System vielseitig einsetzbar. Durch die integrierte<br />

Web-Anbindung an bekannte Bildportale wie FlickR ist es zudem eine schnelle und<br />

effiziente Bildakquisition möglich.<br />

Die Präsentation der Bilddaten erfolgt durch eine Einbettung in die rekonstruierte Szene,<br />

sodass intuitiv zwischen den verschiedene Ansichten navigiert werden kann. Der Bildwechsel<br />

erfolgt dabei über einen hybriden Ansatz, der neben der kontinuierlichen Interpolation<br />

der Kameraparameter auch ein merkmals- und strukturbasiertes Morphing umfasst.<br />

3.4 Vergleich und Bewertung<br />

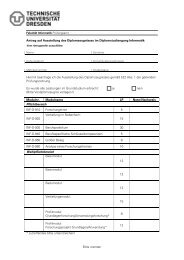

Nachdem in diesem Kapitel drei aktuelle wissenschaftliche Arbeiten aus dem Bereich<br />

des Morphings vorgestellt und inhaltlich beschrieben wurden, erfolgt nun in Tabelle 3.1<br />

eine Gegenüberstellung der präsentierten Ansätze. Durch diesen Vergleich soll sowohl ein<br />

kompakter Überblick über die Eigenschaften und Fähigkeiten der entwickelten Ansätze<br />

als auch eine möglichst umfassende Bewertungsgrundlage geschaffen werden.<br />

Es ist ersichtlich, dass die von Timo Stich und Marcus Magnor vorgestellte Methode<br />

bezüglich der Komplexität einfacher aufgebaut ist als die beiden anderen Ansätze. Die<br />

Anzahl der Vorverarbeitungsschritte ist weitaus geringer, da weder Kalibrierungsdaten<br />

noch extrahierte Raumdaten zum Einsatz kommen. Um dennoch eine ansprechende<br />

Interpolation von Bildern zu erreichen, nutzen die Autoren für das Blending Erkenntnisse<br />

und Techniken aus der Wahrnehmungspsychologie.<br />

Eine fortschrittlichere Methode wird in der Arbeit „Silhouette-Aware Warping for Image-<br />

Based Rendering“ verwendet, weshalb hier weitaus mehr und auch deutlich komplexere<br />

Teilschritte für die Generierung von Zwischenansichten notwendig sind. Das Ergebnis ist<br />

eine Silhouetten-erhaltende Bildsynthese von nahezu jedem beliebigen Blickpunkt aus,<br />

ohne dass beachtenswerte Bildfehler bei Objektverdeckungen oder Tiefensprüngen auftreten.<br />

Als nachteilig ist der hohe Aufwand für die Gewinnung geeigneter Bilddatensätze zu<br />

sehen, da in jedem Fall eine Kamerakalibrierung durchgeführt werden muss.<br />

Das durch Snavely et al. vorgestellte System „Photo Tourism“ stellt, bezogen auf seine<br />

Morphing-Fähigkeiten, einen Kompromiss aus Einfachheit und Komplexität dar. Die<br />

größte Stärke liegt in der Verwendung beliebiger Quelldaten, wodurch die Akquisition<br />

einer Szene direkt und auch webgestützt durchgeführt werden kann. Darüber hinaus<br />

31

3 Forschungsarbeiten<br />

werden aus den Quellbildern Kamera- und Geometriedaten gewonnen und aktiv für die<br />

Sichtinterpolation beim Bildwechsel verwendet. Aus Sicht der Autoren kann es, bedingt<br />

durch nicht erfasste Punkte und fehlerhafte Geometriedaten, aber dennoch bei der Darstellung<br />

zu Fehlern kommen.<br />

Die eigentliche Bildberechnung erfolgt ohne Berücksichtigung von Sillhoueten oder Tiefenebenen,<br />

wodurch das System hinsichtlich seiner Morphing-Eigenschaften weniger<br />

leistungsfähig ist als die Lösung von Chaurasia et al.<br />

3.5 Zusammenfassung<br />

Der Fokus dieses Kapitels lag auf der Betrachtung und Analyse von drei wissenschaftlichen<br />

Arbeiten, die sich mit dem Morphing zweidimensionaler Bilddaten unter Beachtung<br />

tiefenräumlicher Faktoren auseinandersetzen. Die Arbeiten wurden hinsichtlich ihres<br />

Inhalts betrachtet, analysiert sowie die zentralen Lösungsansätze in Stichpunktform<br />

herausgearbeitet. Anschließend fand eine Gegenüberstellung sowie eine abschließende<br />

Bewertung der Arbeiten statt.<br />

32

3.5 Zusammenfassung<br />

Image Morping for<br />

Space-Time Interpolation<br />

[SM07]<br />

Silhouette-Aware<br />

Warping for Image-<br />

Based Rendering<br />

[CSD11]<br />

Photo Tourism: Exploring<br />

Photo Collections<br />

in 3D [ea06]<br />

Autoren Stich, Magnor Chaurasia, Sorkine, Drettakis<br />

Snavely, Seitz, Szeliski<br />

Quellbilder beliebig kalibriert beliebig<br />

Szenenrekonstrwolken,<br />

nein Mesh<br />

ja, Kameradaten, Punkt-<br />

wolken, Mesh<br />

ja, Kameradaten, Punkt-<br />

Prozess sequentiell, einfach sequentiell, komplex sequentiell, komplex<br />

Bilder pro 2 >= 4 >= 2<br />

Übergang<br />

Warping über Flussfelder, Inverse-<br />

Mapping<br />

blickpunktabhängig,<br />

interpolierte Projektion,<br />

kein Warping, sondern<br />

blickpunktabhängiges<br />

Forward-Mapping Mesh-Rendering<br />

Blending einfach, adaptives Blending<br />

komplex, Raycasting, einfach, lineares Polygon-<br />

über Fehlermaske Fehlerwertberechnung, Blending, distanzabhän-<br />

Texture-Blending gig<br />

Verdeckungstoleranz<br />

gering (bei Multilayer- sehr hoch durchschnittlich (abhän-<br />

Umsetzung eher möglich)<br />

gig von Szene)<br />

Blickpunkt festgelegt (interpoliert) variabel, abhängig von variabel, Bildsynthese bei<br />

Datensatz<br />

Bildpaaren<br />

Vorteile flexibel, beliebige Bilder, Erhaltung von Konturen,<br />

flexibel, beliebige Bilder,<br />

einfach, Refinement über<br />

Tiefenschichten, Ver-<br />

echte Sichtinterpolation<br />

Optischen Fluss<br />

deckungen möglich<br />

Nachteile ohne Bildtiefe, Verdeckung<br />

aufwendige Bildakquisiti-<br />

Konturen werden igno-<br />

kritisch, nutzt nur on, manuelle Konturmarriert,<br />

Verdeckung kritisch,<br />

Blending<br />

kierung, komplex kein Warping<br />

Tab. 3.1: Vergleich - Forschungsarbeiten<br />

33

4 Konzeption<br />

Den Kern dieses Kapitels bildet die strukturelle und inhaltliche Konzeption der in<br />