Belegarbeit (.pdf - 2.3 MB) - Technische Universität Dresden

Belegarbeit (.pdf - 2.3 MB) - Technische Universität Dresden

Belegarbeit (.pdf - 2.3 MB) - Technische Universität Dresden

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

6. TESTS 42<br />

wie hoch die Worterkennungsrate in den einzelnen Menüs ist. Jeder Befehl wurde dazu fünf mal wiederholt.<br />

Außerdem wurden nur ein Teil der möglichen Menüpunkte ausgewählt, die geeignet sind, einen<br />

Überblick zu geben welche Erkennungsraten bei welcher Vokabulargröße zu erwarten sind. Natürlich<br />

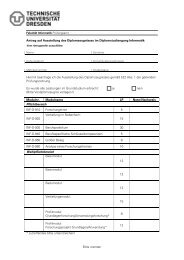

Menüpunkt Anzahl richtig nicht verwechselt Worterkennungsrate<br />

der Befehle erkannt erkannt in Prozent<br />

Musik 31 90 24 40 58,06<br />

Anrufe 24 83 10 27 69,17<br />

Spiele 18 62 13 15 68,89<br />

eMail 13 58 3 4 89,23<br />

Hauptmenü 11 43 4 8 78,18<br />

Tabelle 6.1: Worterkennungsrate einiger Menüs der Sphinx-4 Dialog Demo<br />

sind diese Daten mit Vorsicht zu betrachten. Zunächst ist Sphinx für sprecherunabhängiges Erkenner gedacht.<br />

Darum wäre es von Vorteil gewesen noch die Daten von anderen Sprechern zu haben um objektive<br />

Werte zu erhalten. Außerdem versteht dieser Erkenner nur die englische Sprache. Ein Muttersprachler<br />

hätte somit wahrscheinlich noch eine etwas bessere Worterkennungsrate erzielen können. Des weiteren<br />

schient es, als ob der Erkenner besser damit zurecht kommt, wenn man die Pausen zwischen den<br />

einzelnen Wörtern einer Befehlswortgruppe etwas verlängert.<br />

6.1.2 JLab<br />

Im Kapitel 5.3.5 wurden schon einmal Testdaten von JLab gezeigt. Um einen besseren Vergleich mit<br />

Sphinx zu erreichen wurden im einige zusätzliche Vokabulare erstellt. Diese orientieren sich stark an den<br />

Befehlswörterbüchern der Sphinx-4 Dialog Demo. Der Zweck besteht darin, die Befehle in ihrer Länge,<br />

Anzahl und Ähnlichkeit untereinander, denen des Sphinx Tests anzugleichen. So soll trotz der unterschiedlichen<br />

Sprache ein möglichst guter Vergleich zustande kommen. In Tabelle 6.2 werden die Testergebnisse<br />

dargestellt. Auch in diesem Test wurde jeder Befehl fünf mal eingegeben. Der JLab Speech<br />

Server erreicht in fast allen Menügrößen deutlich bessere Erkennungsraten. Diese Werte sind jedoch<br />

nicht vollständig vergleichbar. Die eigenhändig erstellten Vokabulare für JLab sind nicht optimiert. Das<br />

heißt die Rückweisungsschwelle für die einzelnen Befehle ist so gering, das beinahe jede Eingabe am<br />

Ende auch wirklich als ein Befehl erkannt wird. Aus diesem Grund sind auch nur Verwechslungsfehler<br />

in der Tabelle zu finden. Das ist kein Problem wenn man den Erkenner nur einschaltet wenn man auch<br />

wirklich einen Befehl gibt (siehe Abschnitt <strong>2.3</strong>.1.1 Push to Talk). Es erschwert aber den Vergleich mit<br />

Sphinx, da dort versucht wird wirklich nur auf echte Befehle zu reagieren.