Diplomarbeit

Diplomarbeit

Diplomarbeit

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

Fachhochschule Furtwangen<br />

Computer Networking<br />

<strong>Diplomarbeit</strong><br />

Thema:<br />

Design und Implementierung eines<br />

verteilten Regressionstest-Frameworks<br />

Referent:<br />

Prof. Dr. Christoph Reich<br />

Fachhochschule Furtwangen<br />

Korreferent:<br />

Rudolf Strobl<br />

Linux Information Systems AG<br />

vorgelegt im:<br />

Sommersemester 2005<br />

am:<br />

31. August 2005<br />

vorgelegt von:<br />

Thilo Alexander Uttendorfer<br />

Matrikelnummer: 213164<br />

Bismarckstraße 23<br />

73257 Köngen

ii<br />

Ich erkläre hiermit an Eides Statt, dass ich die<br />

vorliegende <strong>Diplomarbeit</strong> selbständig und ohne unzulässige<br />

fremde Hilfe angefertigt habe. Die verwendeten Quellen und<br />

Hilfsmittel sind vollständig zitiert.<br />

München, den 29. August 2005<br />

Thilo Alexander Uttendorfer<br />

Bismarckstraße 23<br />

73257 Köngen

Inhaltsverzeichnis<br />

1 Einleitung 1<br />

1.1 Problemstellung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1<br />

1.2 Vorgehensweise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1<br />

2 CoreBiz 3<br />

2.1 Debian GNU/Linux . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3<br />

2.2 CoreBiz Ressource-Pool . . . . . . . . . . . . . . . . . . . . . . . . . . . 4<br />

2.3 Installation und Konfiguration von CoreBiz Systemen . . . . . . . . . . . 5<br />

2.3.1 Generierung von Systemen . . . . . . . . . . . . . . . . . . . . . . 6<br />

2.3.2 Installation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6<br />

2.3.3 Konfiguration . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7<br />

2.4 Qualitätssicherung des CoreBiz Ressource-Pools . . . . . . . . . . . . . . 7<br />

2.5 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8<br />

3 Software-Test 9<br />

3.1 Softwarequalität . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9<br />

3.2 Ausprägungen von Tests . . . . . . . . . . . . . . . . . . . . . . . . . . . 10<br />

3.2.1 Testarten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10<br />

3.2.2 Testszenarien . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12<br />

3.3 Regressionstest . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15<br />

3.4 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15<br />

4 Test-Werkzeuge und Testsuites 17<br />

4.1 Automatisiertes Testen . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17<br />

4.2 Test-Werkzeuge . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19<br />

4.2.1 Vergleich von Test Management Tools . . . . . . . . . . . . . . . 20<br />

4.2.2 Test Environment Toolkit . . . . . . . . . . . . . . . . . . . . . . 23<br />

4.3 Testsuites . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 26<br />

4.3.1 Linux Standard Base Testsuites . . . . . . . . . . . . . . . . . . . 26<br />

4.3.2 CoreBiz Testsuites . . . . . . . . . . . . . . . . . . . . . . . . . . 26<br />

4.4 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27<br />

iii

iv<br />

Inhaltsverzeichnis<br />

5 CoreBiz Testsuite - Remote Tests 29<br />

5.1 Ausgangssituation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 29<br />

5.2 Aufbau der Testumgebung . . . . . . . . . . . . . . . . . . . . . . . . . . 29<br />

5.2.1 TET-Lite vs. Distributed TET . . . . . . . . . . . . . . . . . . . 29<br />

5.2.2 Virtualisierungssoftware . . . . . . . . . . . . . . . . . . . . . . . 31<br />

5.2.3 Konfiguration der Systeme . . . . . . . . . . . . . . . . . . . . . . 32<br />

5.3 Ablauf eines Testfalls . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33<br />

5.4 Testarten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34<br />

5.4.1 Verifikation von Konfigurationen . . . . . . . . . . . . . . . . . . 34<br />

5.4.2 Funktionstests . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35<br />

5.4.3 Performance Tests . . . . . . . . . . . . . . . . . . . . . . . . . . 36<br />

5.5 Ein prototypischer Testfall . . . . . . . . . . . . . . . . . . . . . . . . . . 37<br />

5.5.1 Ziel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 37<br />

5.5.2 Implementierung . . . . . . . . . . . . . . . . . . . . . . . . . . . 37<br />

5.6 Problematiken bei Remote Tests . . . . . . . . . . . . . . . . . . . . . . . 38<br />

5.7 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 39<br />

6 Corebiz Testsuite - Verteilte Tests 41<br />

6.1 Aufbau der Testumgebung . . . . . . . . . . . . . . . . . . . . . . . . . . 41<br />

6.2 Das Test Environment Toolkit und verteilte Tests . . . . . . . . . . . . . 42<br />

6.2.1 Einbinden von weiteren Programmiersprachen . . . . . . . . . . . 42<br />

6.2.2 Synchronisation . . . . . . . . . . . . . . . . . . . . . . . . . . . . 43<br />

6.2.3 Installation von verteilten Tests . . . . . . . . . . . . . . . . . . . 44<br />

6.3 Drei prototypische Testfälle . . . . . . . . . . . . . . . . . . . . . . . . . 44<br />

6.3.1 LDAP Konflikttest . . . . . . . . . . . . . . . . . . . . . . . . . . 45<br />

6.3.2 LDAP Performance Test . . . . . . . . . . . . . . . . . . . . . . . 47<br />

6.3.3 LDAP Latenztest . . . . . . . . . . . . . . . . . . . . . . . . . . . 53<br />

6.4 Problematiken bei verteilten Tests . . . . . . . . . . . . . . . . . . . . . . 56<br />

6.5 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 56<br />

7 Conclusio 57<br />

7.1 Fazit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 57<br />

7.2 Ausblick . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 58<br />

A Literaturverzeichnis 61<br />

B Abbildungsverzeichnis 63<br />

C Tabellenverzeichnis 65<br />

D Abkürzungsverzeichnis 67

Kapitel 1<br />

Einleitung<br />

1.1 Problemstellung<br />

Das Ziel dieser <strong>Diplomarbeit</strong> ist die Erarbeitung eines Konzepts für ein verteiltes Regressionstest-Framework<br />

und dessen prototypische Implementierung. Hintergrund dieser<br />

Tests ist die Qualitätssicherung der Produktreihe CoreBiz, die von der Linux Information<br />

Systems AG entwickelt wird.<br />

CoreBiz basiert auf dem Softwarearchiv von Debian GNU/Linux. Dieses Archiv wird<br />

in regelmäßigen Abständen aktualisiert. Das bedeutet, dass jedes Softwarepaket, für<br />

das eine aktuellere Version verfügbar ist, durch diese ersetzt wird. Um nach solch einer<br />

Aktualisierung eine Regression, also einen Rückschritt bei der Qualität zu verhindern,<br />

müssen verschiedene Tests durchgeführt werden. Das Regressionstest-Framework soll die<br />

bisherige Testumgebung integrieren und erweitern. Dabei soll untersucht werden, welche<br />

Arten von Tests sinnvoll eingesetzt werden können.<br />

Besondere Bedeutung haben die so genannten verteilten Tests. Diese unterscheiden sich<br />

zu normalen Tests dahingehend, dass die Komponenten eines solchen Testfalls auf verschiedenen<br />

Systemen eines lokalen Netzwerkes ablaufen und sich zeitlich und inhaltlich<br />

aufeinander beziehen. Es werden also die Interaktionen zwischen verschiedenen Systemen<br />

getestet.<br />

1.2 Vorgehensweise<br />

Zunächst wird die Produktreihe CoreBiz vorgestellt. Da sich das Regressionstest-Framework<br />

vorrangig auf die verschiedenen Produkte von CoreBiz bezieht, ist ein grundlegendes<br />

Verständnis über den Aufbau dieser Software nötig. Es wird gezeigt was die Software<br />

leistet und aus welchen Komponenten sie besteht. Aus diesem Zusammenhang heraus<br />

wird erläutert, warum und an welchen Punkten Softwaretests eingesetzt werden sollen.<br />

Anschließend wird auf das Thema Softwaretest im Allgemeinen eingegangen. Es wird<br />

die Notwendigkeit eines Qualitätsmanagements von Software aufgezeigt und es werden<br />

1

2 Kapitel 1 Einleitung<br />

verschiedene Testarten näher erläutert. Darauf folgt ein Überblick über Werkzeuge, die<br />

den Testprozess unterstützen und vereinfachen. In diesem Zusammenhang werden die<br />

Möglichkeiten sowie die Vor- und Nachteile der Automatisierung von Tesfällen diskutiert.<br />

Der praktische Teil dieser Arbeit enthält die prototypische Implementierung von Remote<br />

und verteilten Tests. Es wird gezeigt, wie eine Testumgebung für Testfälle dieser Art<br />

realisiert werden kann. Auf einige exemplarische Testfälle wird näher eingegangen und<br />

es werden die Probleme und Ergebnisse dieser Tests diskutiert. Zum Ende dieser Arbeit<br />

wird ein Fazit gezogen und ein Ausblick für die Zukunft dargestellt.

Kapitel 2<br />

CoreBiz<br />

Eine modular aufgebaute Software um Linux für unterschiedlichste Einsatzzwecke zu<br />

installieren und zu konfigurieren wird unter dem Namen CoreBiz von der Linux Information<br />

Systems AG angeboten. Als Basis wird dafür die Linux Distribution Debian<br />

GNU/Linux (vgl. [Deba]) benutzt. Da sich diese Arbeit an vielen Stellen immer wieder<br />

darauf bezieht, wird im Folgenden der Aufbau und die Funktionsweise von Core-<br />

Biz Systemen im Detail erläutert. In diesem Zusammenhang wird zunächst auf Debian<br />

GNU/Linux eingegangen.<br />

2.1 Debian GNU/Linux<br />

Debian GNU/Linux ist ein freies Betriebssystem, das unterschiedlichste Rechnerarchitekturen<br />

unterstützt und mehrere Tausend Softwarepakete enthält. Es wird im Gegensatz<br />

zu vielen anderen Linux Distributionen ausschließlich von Freiwilligen entwickelt und ist<br />

die am weitesten verbreitete nicht-kommerzielle Linux Distribution (vgl. [Wik]).<br />

Debian hat sehr strenge Richtlinien in Bezug auf Software, die in die Distribution aufgenommen<br />

wird. So wird ausschließlich Software zugelassen, die unter einer freien Lizenz,<br />

wie zum Beispiel der GNU General Public License (GPL) oder der Berkeley Software<br />

Distribution (BSD) License 1 , veröffentlicht wurde. Diese Richtlinien sind in den Debian<br />

Free Software Guidelines (DFSG) (vgl. [Debb]) geregelt.<br />

Debian hebt sich von anderen Linux Distributionen vor allem durch sein Paketmanagement<br />

ab, welches das Aktualisieren von Paketen und das Auflösen von Abhängigkeiten<br />

zwischen diesen Paketen zuverlässig löst. Außerdem bietet es ein sehr umfangreiches Archiv<br />

an Software. Dieses Archiv ist in drei 2 verschiedenen Varianten erhältlich: stable“, ”<br />

” testing“ und ” unstable“. Dabei enthält stable“ die jeweils letzte veröffentlichte Version<br />

”<br />

und testing“ die Kommende aber noch nicht veröffentlichte Version des Betriebssystems.<br />

Die Variante unstable“ enthält jeweils relativ aktuelle, meist aber ungetestete<br />

”<br />

”<br />

Pakete, die, wie der Name schon sagt, unstabil oder fehlerhaft sein können.<br />

1 Die beiden Lizenzen findet man unter [Freb] beziehungsweise unter [Unia]<br />

2 Es gibt noch eine vierte Variante ”<br />

experimental“, die aber nur für Entwickler gedacht ist.<br />

3

4 Kapitel 2 CoreBiz<br />

2.2 CoreBiz Ressource-Pool<br />

Größter Nachteil an Debian (zum Zeitpunkt des Schreibens dieser Arbeit) ist der sehr<br />

lange Releasezyklus. Tabelle 2.1 zeigt die veröffentlichten Versionen der letzten Jahre.<br />

Der immer größer werdende Abstand zwischen den Versionen ist unter anderem auf die<br />

Vielzahl der unterstützten Architekturen und der stetig steigenden Anzahl an Paketen<br />

zurückzuführen. Das Debian Projekt ist sich zwar diesem Problem bewußt und arbeitet<br />

an Lösungen, es ist jedoch nicht damit zu rechnen, dass es mittelfristig deutlich kürzere<br />

Releasezyklen geben wird.<br />

Version Name Datum<br />

2.0 Hamm 24. Juli 1998<br />

2.1 Slink 9. März 1999<br />

2.2 Potato 15. August 2000<br />

3.0 Woody 19. Juli 2002<br />

3.1 Sarge 6. Juni 2005<br />

? Etch ?<br />

Tabelle 2.1: Veröffentlichte Versionen von Debian (Quelle: [Deba])<br />

Daraus ergibt sich, dass die stabile Variante von Debian zum Teil sehr alte Pakete<br />

enthält, da in diesem Archiv nur eventuelle Sicherheitslücken beseitigt werden, jedoch<br />

keine neuen Pakete hinzugefügt werden. Dagegen werden die Varianten testing“ und<br />

”<br />

unstable“ ständig mit neuen Paketen aktualisiert. Das führt dazu, dass sich auch grundlegende<br />

Teile des Systems verändern können und diese Varianten somit keine verlässliche<br />

”<br />

Lösung darstellen.<br />

Die Anforderungen an ein CoreBiz System sind aber einerseits die Verfügbarkeit aktueller<br />

Versionen von bestimmten Softwarepaketen, andererseits muß die Software stabil<br />

und langfristig einsetzbar sein. Um dieses Dilemma zu überwinden, wird für CoreBiz in<br />

regelmäßigen Abständen ein so genannter Snapshot aus ”<br />

testing“ gemacht. Das bedeutet,<br />

dass sämtliche Pakete aus dem Debian Archiv ”<br />

eingefroren“ werden und von diesem<br />

Zeitpunkt an nur noch durch Sicherheitsaktualisierungen oder Bugfixes verändert werden<br />

können. Dadurch sind CoreBiz basierte Server und Clients einerseits aktueller als<br />

entsprechende, auf Debian ”<br />

stable“ basierende Systeme. Andererseits wird trotzdem versucht<br />

die Stabilität und Qualität von Debian ”<br />

stable“ zu erreichen.<br />

Diesem regelmäßig aktualisiertem Archiv werden dann zusätzlich CoreBiz-spezifische Pakete<br />

hinzugefügt. Um begrifflichen Missverständnissen vorzubeugen, wird dieses Archiv<br />

CoreBiz Ressource-Pool“ bezeichnet.<br />

”

2.3 Installation und Konfiguration von CoreBiz Systemen 5<br />

2.3 Installation und Konfiguration von CoreBiz<br />

Systemen<br />

Die Basis jeder CoreBiz Installation ist der so genannte ”<br />

CoreBiz Factory Server“. Dieses<br />

System verfügt über alle Komponenten, die nötig sind, um weitere Systeme zu installieren<br />

und hat direkten Zugriff auf den CoreBiz Ressource-Pool. Hier werden sämtliche Konfigurationseinstellungen,<br />

Parameterisierungen und Kundenanpassungen durchgeführt,<br />

um daraus den so genannten ”<br />

CoreBiz Base Server“ zu generieren.<br />

Der CoreBiz Base Server wird an den Kunden ausgeliefert und ist dann in der Lage,<br />

weitere Systeme zu installieren. Diese Fähigkeit wird zum Beispiel genutzt, um die Installation<br />

von Clients direkt vor Ort beim Kunden durchzuführen. Abbildung 2.1 zeigt<br />

den typischen Aufbau einer CoreBiz Umgebung.<br />

CoreBiz Factory<br />

CoreBiz Base<br />

CoreBiz<br />

Ressource-Pool<br />

installiert<br />

installiert<br />

CoreBiz Backup<br />

CoreBiz Client CoreBiz Client CoreBiz Client<br />

Abbildung 2.1: CoreBiz Umgebung

6 Kapitel 2 CoreBiz<br />

Auf dem CoreBiz Factory Server beziehungsweise dem CoreBiz Base Server ist das Softwarepaket<br />

OpenLDAP (vgl. [Ope]) installiert, um Benutzerkonten und Gruppen mittels<br />

des Lightweight Directory Access Protocol (LDAP) zentral verwalten zu können. Außerdem<br />

wird der LDAP-Server genutzt, um bestimmte Server-Dienste zu parameterisieren.<br />

Das wird aber nur von einigen Diensten unterstützt, wie beispielsweise dem DHCP-<br />

Server.<br />

Wenn alle Kundenanpassungen und Konfigurationen für ein neues System erstellt wurden,<br />

werden im wesentlichen folgende Schritte durchgeführt:<br />

1. Generierung<br />

2. Installation<br />

3. Konfiguration<br />

2.3.1 Generierung von Systemen<br />

Wichtiger Bestandteil ist die frei erhältliche Software FAI (Fully Automatic Installation)<br />

(vgl.[Lan]), welche die Infrastruktur für eine komplett automatische Installation über das<br />

Netzwerk oder die Generierung von Installations-CDs ermöglicht. Anhand von Profilen<br />

und Komponenten werden die unterschiedlichen CoreBiz Systeme erstellt. Tabelle 2.2<br />

zeigt den Zusammenhang zwischen Profil, Komponente und Debian-Paket. Ein Profil<br />

stellt ein komplettes CoreBiz System dar. Eine Komponente dagegen ist ein bestimmter<br />

Teil eines Systems, wie zum Beispiel die KDE Umgebung, und enthält eine Liste von<br />

Debian-Paketen. Da die Komponenten aber unabhängig von einem Profil sind, können<br />

sie beliebig in anderen Profilen wiederverwendet werden. Durch diesen modularen Ansatz<br />

ist es möglich, auf einfache Art und Weise Kundenanpassungen durchzuführen.<br />

enthält<br />

Beispiel<br />

Profil Liste mit Komponenten CoreBiz Client<br />

Komponente Liste mit Paketen KDE Umgebung<br />

Paket Debian-Paket Konqueror<br />

Tabelle 2.2: Interner Aufbau eines CoreBiz Systems<br />

2.3.2 Installation<br />

Die Installation eines CoreBiz Systems erfolgt vollkommen automatisch entweder durch<br />

eine Installations-CD oder über das Netzwerk. Im Falle der Netzwerkinstallation wird<br />

PXE (Preboot eXecution Environment) genutzt, um ein System automatisch zu installieren.<br />

Als PXE-Boot-Server dient dabei der CoreBiz Factory Server beziehungsweise<br />

der CoreBiz Base Server.

2.4 Qualitätssicherung des CoreBiz Ressource-Pools 7<br />

Einem System, das über das Netzwerk installiert wird, wird mit Hilfe von DHCP (Dynamic<br />

Host Configuration Protocol) eine IP-Adresse zugewiesen. Daraufhin wird vom<br />

Server ein Kernel heruntergeladen mit dem das System in der Lage ist zu booten.<br />

Die Installation erfolgt dann in zwei Phasen. Während der ersten Phase werden Systeminformationen<br />

ausgelesen und an den Server übermittelt. Es werden dabei entsprechende<br />

Eintragungen im LDAP des CoreBiz Base Servers vorgenommen. Ab diesem Zeitpunkt<br />

ist das System registriert und es können beispielsweise Hardwareinformationen ausgelesen<br />

oder das zu installierende Profil geändert werden. Nach einem Neustart des Systems<br />

erfolgt dann die zweite Phase mit der eigentlichen Installation.<br />

Die Installation von CD kann unabhängig der Netzwerkumgebung durchgeführt werden.<br />

Von Nachteil ist allerdings die Beschränkung der Kapazität auf eine CD oder, falls ein<br />

entsprechendes Laufwerk vorhanden ist, auf eine DVD. Zum Beispiel kann es bei einem<br />

so genannten ”<br />

Fat Client“ sein, dass mehrere Gigabyte an Softwarepaketen installiert<br />

werden müssen.<br />

2.3.3 Konfiguration<br />

Ziel jeder CoreBiz Installation ist es, ohne manuellen Eingriff abzulaufen. Das setzt voraus,<br />

dass alle Konfigurationsparameter schon vor der Installation festgelegt werden. Des<br />

weiteren ist es oft wünschenswert bestimmte Konfigurationen bei produktiven Systemen<br />

später zu ändern.<br />

Um diese Anforderungen realisieren zu können, wird das Werkzeug ”<br />

cfengine“ (vgl.<br />

[Frea]) eingesetzt. Der Name ”<br />

cfengine“ leitet sich von ”<br />

configuration engine“ ab. Damit<br />

lassen sich unter anderem Konfigurationsdateien auf einfache und elegante Art und<br />

Weise modifizieren. Es bringt eine eigene Programmiersprache mit, die im Gegensatz<br />

zu vielen anderen Sprachen ohne die üblichen if-else-Anweisungen auskommt. Anweisungen<br />

werden dagegen in Abhängigkeit von bestimmten Klassen ausgeführt, die frei<br />

definiert werden können. Weiterhin stehen eine Vielzahl von vordefinierten Klassen zur<br />

Verfügung, die beispielsweise bestimmte Systemeigenschaften wie die Kernelversion repräsentieren.<br />

Bei einem CoreBiz System wird dieses Werkzeug genutzt, um bestimmte Systemparameter<br />

in Konfigurationsdateien zu setzen oder zu überprüfen. Das können beispielsweise<br />

grundlegende Dinge wie die Netzwerkkonfiguration sein, aber auch das Hintergrundbild<br />

der grafischen Oberfläche kann so verändert werden.<br />

2.4 Qualitätssicherung des CoreBiz Ressource-Pools<br />

Bei einer Aktualisierung des CoreBiz Ressource-Pools wird die Variante ”<br />

testing“ des<br />

Debian Archivs verwendet. Dabei kann nicht davon ausgegangen werden, dass alle Pa-

8 Kapitel 2 CoreBiz<br />

kete fehlerfrei sind, beziehungsweise sich alle Programme genau so verhalten wie ihre<br />

Vorgängerversion. Fehler können beispielsweise schon daraus entstehen, dass sich der<br />

Name eines Parameters einer Konfigurationsdatei ändert. Wenn dieser Parameter durch<br />

CoreBiz mittels ”<br />

cfengine“ kontrolliert wird, würde dies höchstwahrscheinlich zu einer<br />

fehlerhaften Konfiguration führen. Es könnten sich aber auch die Schnittstellen eines Programmes<br />

geändert haben oder es fehlen sogar bestimmte Pakete im Ressource-Pool.<br />

Das bisherige Verfahren bei einer Aktualisierung des Ressource-Pools war, das auf einer<br />

CoreBiz Installation Tests der Linux Standard Base (LSB) ausgeführt wurden. Diese<br />

Tests überprüfen verschiedene Aspekte wie zum Beispiel die POSIX-Kompatibilität oder<br />

die Konformität des Dateisystems zur LSB. Damit kann zwar eine gewisse Grundfunktionalität<br />

abgedeckt werden, aber es wäre wünschenswert weitergehende Tests durchzuführen.<br />

Deshalb gibt es den Ansatz, Konfigurationsdateien, die durch ”<br />

cfengine“ automatisch<br />

verwaltet werden, mit Hilfe von Tests zu verifizieren. Vorstellbar sind aber auch weitergehende<br />

Tests, die direkt bestimmte Funktionalitäten von CoreBiz Systemen überprüfen<br />

oder aber auch Performance- und Lasttests.<br />

Ziel aller Tests ist es, festzustellen, ob sich nach einer Aktualisierung des Ressource-<br />

Pools, die Funktionalität der CoreBiz Skripte, die CoreBiz Systeme an sich und das<br />

Zusammenspiel verschiedener CoreBiz Systeme miteinander in irgendeiner Form beeinträchtigt<br />

ist. Auf letzteres, also die Interaktion zwischen verschiedenen Systemen, wird<br />

dabei besonderen Wert gelegt.<br />

2.5 Zusammenfassung<br />

In diesem Kapitel wurden die Komponenten eines CoreBiz Systems erklärt. Neben Debian<br />

GNU/Linux, welches die Basis für alle CoreBiz Systeme darstellt, wurde die Generierung,<br />

die Installation und die Konfiguration dieser Systeme detailliert erläutert.<br />

Besonders interessant ist die Qualitätssicherung des Resource-Pools, der sämtliche Software<br />

enthält, die bei CoreBiz Systemen verwendet wird. Es wurde gezeigt, dass bei<br />

CoreBiz Systemen unterschiedliche Software integriert wird und diese Systeme im Netzwerk<br />

zusammenarbeiten und voneinander abhängig sind. Um Fehler in einem CoreBiz<br />

System, aber auch in der vollständigen CoreBiz Umgebung zu verhindern, müssen gewisse<br />

Tests durchgeführt werden. Es ist also nötig ein Konzept für die Qualitätssicherung<br />

dieser Systeme zu entwickeln und zu realisieren.

Kapitel 3<br />

Software-Test<br />

Testing is the process of executing a program with the intent of finding errors.“<br />

[Mye79, Seite<br />

”<br />

5]<br />

In diesem Kapitel wird auf die Notwendigkeit des Qualitätsmanagements von Software<br />

eingegangen. Es soll einen Überblick über die grundlegenden Termini und Themen<br />

aus dem Gebiet der Softwaretests im Hinblick auf die CoreBiz Testumgebung geben.<br />

Besondere Beachtung wird den verschiedenen Testausprägungen geschenkt.<br />

3.1 Softwarequalität<br />

Definition von Definition<br />

1 Philip B. Crosby Qualität ist die Erfüllung von Anforderungen<br />

2 DATEV Qualität ist Kundenzufriedenheit<br />

3 Thaller Qualität ist Fehlerfreiheit<br />

4 Weinberg Qualität heißt, die Anforderungen eines Menschen zu erfüllen<br />

Tabelle 3.1: Verschiedene Definitionen von Qualität (Quelle: [Tha97])<br />

Tabelle 3.1 zeigt verschiedene Definitionen von Qualität. Wenn Qualität mit Fehlerfreiheit<br />

definiert wird, stellt sich zunächst die Frage, wie es überhaupt dazu kommt, dass<br />

Fehler entstehen: Fehler entstehen prinzipiell in jeder Phase eines Softwareprojekts, beim<br />

Aufnehmen der Anforderungen, beim Erstellen des Designs und bei der Kodierung der<br />

Software (vgl. [OU87, Seite 5]). Problematisch dabei ist, dass Fehler in einer frühen Phase<br />

in der Regel zu Folgefehlern in den darauf folgenden Phasen führen. Wie empirische<br />

Untersuchungen gezeigt haben, sind solche Fehler, die in späten Phasen der Software-<br />

Entwicklung oder sogar erst im Betrieb gefunden werden, sehr teuer (vgl. [Sch83, Seite<br />

61f]).<br />

Es ist also notwendig, in allen Phasen eines Projekts zu testen und Fehler möglichst<br />

früh zu erkennen und zu beheben. Das führt aber dazu, dass das Testen einen nicht<br />

unbeachtlichen Teil am Gesamtaufwand eines Projekts einnimmt und somit zu einem<br />

9

10 Kapitel 3 Software-Test<br />

aufwändigen und kostspieligen Prozess wird. Thaller schreibt von 30 bis 50 Prozent des<br />

Gesamtaufwands, welches das Testen eines Softwareprojekts an Ressourcen verschlingen<br />

kann (vgl. [Tha02, Seite 49]).<br />

Die Erfahrungen in der Softwareentwicklung haben gezeigt, dass es praktisch unmöglich<br />

ist, fehlerfreie Software zu schreiben. Thaller stellte eine interressante Rechnung an, die<br />

das verdeutlicht: Er nimmt relativ optimistische Fehlerraten an und berechnet damit die<br />

Anzahl der nicht erkannten schwerwiegenden Fehlern von verschiedenen Softwareprojekten.<br />

Ein Beispiel ist die Software für das Navigationssystem des Space Shuttles. Obwohl<br />

die NASA eine der niedrigsten Fehlerraten der Industrie aufweist, muß trotzdem mit 100<br />

schwerwiegenden Fehlern gerechnet werden, die nicht erkannt werden. Es muß beachtet<br />

werden, dass dies die Anzahl der Fehler ist, die nach dem Test der Software verbleibt<br />

(vgl. [Tha02, Seite 17]).<br />

Für die Qualitätssicherung von Software bedeutet das, dass auch hier ständig Fortschritte<br />

und Verbesserungen erzielt werden müssen. Nur so kann bei immer größer werdenden<br />

Softwareprojekten die Qualität sichergestellt werden. Trotzdem muß auch die Wirtschaftlichkeit<br />

des Testens im Auge behalten werden. Es macht einen Unterschied, ob von<br />

einer Software Menschenleben abhängen oder ob durch einen Softwarefehler ”<br />

nur“ Daten<br />

verloren gehen, die mit etwas Aufwand wiederhergestellt werden können. Entsprechend<br />

muß der Aufwand abgeschätzt werden, der in das Testen der Software investiert wird.<br />

3.2 Ausprägungen von Tests<br />

Softwaretests haben das Ziel, bestimmte Systemparameter zu erzeugen und zu ermitteln.<br />

Diese Systemparameter werden je nach Ausprägung des Tests auf unterschiedliche Art<br />

und Weise erzeugt. Sie werden dann mit den eigentlich korrekten Parametern verglichen<br />

und entsprechend bewertet. Die erwarteten Systemparameter müssen daher eindeutig<br />

ermittelt werden können (vgl. [Rät04, Seite 34]). Nachfolgend werden verschiedene Arten<br />

von Tests erläutert und dann mögliche Testszenarien vorgestellt.<br />

3.2.1 Testarten<br />

Im folgenden wird auf verschiedene Arten von Tests eingegangen, die für das Qualitätsmanagement<br />

von CoreBiz sinnvoll erscheinen.<br />

Verifikation von Konfigurationen<br />

Diese Art des Tests darf nicht mit Konfigurationstests verwechselt werden, bei denen<br />

es in der Regel um das Zusammenspiel einer Software mit unterschiedlichen Hardwarekonfigurationen<br />

geht. Bei der Verifikation von Konfigurationen handelt es sich um

3.2 Ausprägungen von Tests 11<br />

Tests, die bestimmte Werte in Konfigurationsdateien verifizieren, welche automatisch,<br />

zum Beispiel durch ein Skript, verändert werden. Für den Test bedeutet das, dass ein<br />

Programm oder Skript ausführt wird, welches bestimmte Parameter in einer Konfigurationsdatei<br />

auf einen vorher festgelegten Wert setzt. Dann wird diese Konfigurationsdatei<br />

beziehungsweise die einzelnen Parameter mit dem erwartetem Ergebnis verglichen.<br />

Die Tests sind nötig, da sich beispielsweise der Aufbau einer Konfigurationsdatei oder der<br />

Name eines Parameters ändern kann. Ein Skript, das diese Datei verändern will, würde<br />

dann eine fehlerhafte Konfiguration hinterlassen. Als Nebeneffekt lassen sich damit auch<br />

Fehler im Skript selbst aufdecken.<br />

Funktionstest<br />

Funktionstests überprüfen das Ergebnis eines Aufrufs eines Programms (vgl. [Tha02,<br />

Seite 122ff]). Sie setzen die korrekte Konfiguration aller Programme, die am Test beteiligt<br />

sind, vorraus. Eine korrekte Konfiguration ist aber noch kein Garant für einen<br />

erfolgreichen Funktionstest. Der Test führt ein Programm aus und vergleicht dessen<br />

Rückgabewert mit dem erwartetem Ergebnis. Vor der eigentlichen Überprüfung des<br />

Rückgabewertes werden in der Regel andere Programme oder Skripte ausgeführt, die<br />

diesen Rückgabewert beeinflussen.<br />

Stress- und Lasttest<br />

Wie Boris Beizer bemerkt, werden diese beiden Begriffe sehr oft falsch benutzt und als<br />

Synonyme verwendet (vgl. [Riv]). Nachfolgend wird versucht, die Unterschiede dieser<br />

beiden Testarten aufzuzeigen.<br />

Bei einem Stresstest wird versucht das zu testende Programm extrem zu belasten. Es<br />

wird dabei keinesfalls erwartet, dass das Programm unter dieser Belastung korrekt weiterarbeitet.<br />

Das Programm sollte aber zum Beispiel mit einer entsprechenden Fehlermeldung<br />

abbrechen. Das ist oftmals aber nicht der Fall und das Programm kann abstürzen<br />

oder Daten beschädigen.<br />

Beim Lasttest dagegen wird das Programm gleichmäßig über einen längeren Zeitraum<br />

unter Last gesetzt. Es sollen also die Auswirkungen getestet werden, wenn eine Funktion<br />

nicht nur einmal ausgeführt wird, sondern über eine bestimmte Dauer ständig<br />

wiederholt wird. Wenn ein Programm zum Beispiel für eine Funktion Speicher reserviert,<br />

aber aufgrund eines Fehlers nicht mehr freigibt, dann fällt das beim einmaligen<br />

Ausführen möglicherweise nicht weiter auf. Durch das ständige Wiederholen würde<br />

höchstwahrscheinlich aber auch solch ein Fehler erkannt.

12 Kapitel 3 Software-Test<br />

Performance Test<br />

Performance Tests sollen die Geschwindigkeit bestimmter Funktionen des Systems messen.<br />

Das Besondere an diesem Test ist, dass kein Fehler auftreten muß, sondern nur<br />

verschiedene Messwerte zurückgeliefert werden. Diese müssen dann entsprechend interpretiert<br />

werden und zum Beispiel mit Referenzwerten verglichen werden. So kann<br />

beispielsweise die Performance-Verbesserung zwischen zwei Programmversionen gemessen<br />

werden. Aber auch die Unterschiede in Bezug auf die Performance beim Einsatz<br />

verschiedener Hardwarekonfigurationen können so bestimmt werden.<br />

Weiterhin lassen sich Performance Tests mit Lasttests kombinieren. Es wird also die<br />

Performance eines Programmes oder einer Funktion unter verschieden großen Lasten<br />

gemessen.<br />

3.2.2 Testszenarien<br />

Tests können auf unterschiedliche Weise durchgeführt werden. Im folgenden wird auf<br />

diese Szenarien näher eingegangen:<br />

• Lokaler Test<br />

• Remote Test<br />

• Verteilter Test<br />

Lokaler Test<br />

Ein lokaler Test wird direkt auf dem Testsystem ausgeführt, die Systemparameter werden<br />

dort ermittelt und verglichen. Es kann für den Test selbst aber nötig sein, dass<br />

weitere Systeme im Netzwerk verfügbar sind. Diese Systeme werden allerdings nicht<br />

vom Testframework kontrolliert oder beeinflusst.<br />

Lokale Tests haben den Vorteil, dass sie in der Regel auf einem beliebigen System installiert<br />

und ausgeführt werden können. Im Vergleich zu Remote und verteilten Tests ist<br />

der Konfigurationsaufwand minimal. Die Ergebnisse können auf dem Testsystem selbst<br />

ausgewertet werden. Problematisch wird dieser Ansatz, wenn auf mehreren Systemen<br />

Tests ausgeführt werden sollen. Der Aufwand, um die Ergebnisse auszuwerten steigt in<br />

diesem Fall deutlich an.

3.2 Ausprägungen von Tests 13<br />

Remote Test<br />

Ein Remote Test ist im Prinzip ein lokaler Test, welcher aber von einem zentralen System<br />

aus gesteuert wird. Dieses System kann auf einem oder mehreren entfernten Systemen die<br />

Tests ausführen. Die Ergebnisse jedes einzelnen Systems werden dann ebenfalls zentral<br />

auf diesem System erfasst. Es kann außerdem selbst eines der Systeme sein, auf dem<br />

Tests ausgeführt werden. Abbildung 3.1 zeigt eine mögliche Testumgebung.<br />

Server<br />

Tests<br />

ausführen<br />

LAN<br />

Testsystem<br />

Testsystem<br />

Testsystem<br />

Abbildung 3.1: Remote Test<br />

Mit diesem Ansatz ist es möglich, einen Test auf unterschiedlichen Systemen gleichzeitig<br />

auszuführen oder aber auch unterschiedliche Tests auf viele, eventuell sogar identische,<br />

Systeme zu verteilen. Der größte Vorteil gegenüber lokalen Tests ist die Tatsache, dass<br />

es nur noch eine zentrale Datei mit Ergebnissen sämtlicher Tests gibt. Allerdings ist der<br />

Konfigurationsaufwand etwas höher als bei lokalen Tests. Durch Automatisierung kann<br />

aber dieser Aufwand auf ein Minimum reduziert werden.<br />

Verteilter Test<br />

Bei verteilten Tests geht es nicht darum, Tests durch ein Lastverteilungsverfahren auf<br />

mehrere parallel arbeitende Systeme zu verteilen, um so eine schnellere Durchführung<br />

der Tests zu ermöglichen. Das ist schon mit Hilfe der Remote Tests möglich. Das Wort<br />

verteilt“ bezieht sich vielmehr auf den Testfall, der über mindestens zwei Systeme<br />

”<br />

verteilt ist. Diese Systeme sind über ein Netzwerk verbunden und können miteinander<br />

kommunizieren.

14 Kapitel 3 Software-Test<br />

Die einzelnen Schritte eines solchen Tests, also die Erzeugung und Ermittlung von Systemparametern,<br />

müssen zeitlich und inhaltlich aufeinander abgestimmt sein. Das bedeutet,<br />

dass jeder Schritt vom vorherigen abhängig ist und erst gestartet werden darf,<br />

wenn dieser abgeschlossen ist. Um diesen zeitlichen Ablauf zu kontrollieren, werden sogenannte<br />

Synchronisationspunkte verwendet. Die Testsysteme warten dann gegenseitig<br />

aufeinander, bis jeder an diesem Synchronisationspunkt angelangt ist und fahren erst<br />

dann mit den weiteren Testschritten fort. Abbildung 3.2 zeigt eine mögliche Testumgebung.<br />

Server<br />

Tests<br />

ausführen<br />

LAN<br />

Aktion 1<br />

Aktion 2<br />

Testsystem<br />

Testsystem<br />

Abbildung 3.2: Verteilter Test<br />

Verteilte Tests werden benötigt, wenn bestimmte Interaktionen zwischen den Testsystemen<br />

getestet werden sollen. Damit sind auf den Testsystemen stattfindende Aktionen<br />

gemeint, die die Interaktion der Systeme beeinflussen. Für die Erzeugung und Ermittlung<br />

von Systemparametern auf einem System ist es also nötig, dass auf einem anderen<br />

System in zeitlich koordinierter Abfolge bestimmte Aktionen durchgeführt werden.<br />

Weiterhin ist es möglich, Nachrichten zwischen den Testsystemen auszutauschen. Das<br />

heißt, dass es zur Laufzeit des Tests möglich ist, die einzelnen Testschritte zu beeinflussen.<br />

Es werden also nicht nur die jeweilgen Testschritte nach einem vorgegebenen<br />

Schema auf den beteiligten Systemen ausgeführt, sondern jeder Testschritt kann vom<br />

vorherigen beeinflusst werden und darauf reagieren.

3.3 Regressionstest 15<br />

3.3 Regressionstest<br />

Regressionstests werden eingesetzt, um eine Regression, also einen Rückschritt beziehungsweise<br />

eine Verschlechterung einer Software zu erkennen. Das heißt, dass Funktionalitäten<br />

getestet werden, die in einer älteren Version fehlerfrei waren. Außerdem soll<br />

verhindert werden, dass alte, eventuell schon behobene Fehler wieder in der Software<br />

auftauchen. Dazu bietet es sich an, alte Tesfälle zu wiederholen und die Ergebnisse mit<br />

den früheren Ergebnissen zu vergleichen.<br />

Die verschiedenen Testarten, die unter Punkt 3.2.1 beschrieben wurden, können prinzipiell<br />

alle für einen Regressionstest eingesetzt werden. Damit der Aufwand nicht zu groß<br />

wird, macht es Sinn, sämtliche Tests so weit wie möglich zu automatisieren. Dann ist es<br />

auch möglich, die Tests regelmäßig, insbesondere vor einem neuen Release, auszuführen.<br />

Der Aufwand für die Automatisierung darf aber keinesfalls unterschätzt werden (vgl.<br />

[Rät04, Seite 171]).<br />

Bei CoreBiz ist der Einsatz von Regressionstests besonders wichtig. Da bei einem CoreBiz<br />

System unterschiedlichste Software integriert wird, auf die keinen oder nur geringen<br />

Einfluss ausgeübt werden kann, darf nicht davon ausgegangen werden, dass sich die<br />

Software absolut gleich wie ihre Vorgängerversion verhält. Durch das Wiederholen von<br />

Testfällen kann auch diese Software getestet werden und somit läßt sich sicherstellen,<br />

dass sich diese Software weiterhin wie gewohnt in das System integrieren läßt.<br />

3.4 Zusammenfassung<br />

In diesem Kapitel wurde gezeigt, dass die Qualität von Software eine äußerst wichtige<br />

Rolle spielt, die nicht unterschätzt werden darf. Diese zu sichern ist die Aufgabe von<br />

Softwaretests, auf deren verschiedenen Ausprägungen eingegangen wurde. Speziell die<br />

verteilten Tests stellen dabei ein äußerst interessantes Gebiet dar. Als eine besondere<br />

Testart sind die Regressionstests zu verstehen. Damit werden zwar kaum neue Fehler<br />

gefunden, allerdings kann damit die Abwesenheit von Fehlern gezeigt werden. In diesem<br />

Zusammenhang ist die Automatisierung von Testfällen besonders wichtig. Darauf wird<br />

detailliert im nächsten Kapitel eingegangen.

16 Kapitel 3 Software-Test

Kapitel 4<br />

Test-Werkzeuge und Testsuites<br />

Es gibt sehr viele verschiedene freie und kommerzielle Werkzeuge, die das Testen von<br />

Software unterstützen. Im Folgenden werden einige dieser Werkzeuge vorgestellt und<br />

deren Nutzen diskutiert. Besonderes Augenmerk wird auf das Test Environment Toolkit<br />

gerichtet, welches die Basis für die CoreBiz Testumgebung darstellt.<br />

4.1 Automatisiertes Testen<br />

Das Automatisieren von Tests wurde schon im vorherigen Kapitel im Zusammenhang<br />

mit Regressionstests angesprochen. Es dient in erster Linie dazu, Tests auf einfache Art<br />

und Weise zu wiederholen, was natürlich gerade bei einem Regressionstest interessant<br />

ist. Es stellt sich also die Frage, was bei einem Testfall sinnvoll automatisiert werden<br />

kann und welche Werkzeuge dafür eingesetzt werden können. Dazu muß der Ablauf eines<br />

Tests betrachtet werden (vgl. [Tha02, Seite 228]):<br />

• Entwurf der Testfälle<br />

• Testumgebung vorbereiten<br />

• Für jeden Testfall folgende Schritte durchführen:<br />

– Testdaten zur Verfügung stellen<br />

– Test ausführen<br />

– Ergebnisse vergleichen und dokumentieren<br />

– Umgebung wiederherstellen<br />

• Ergebnisse zusammenfassen<br />

• Analysieren der Ergebnisse<br />

17

18 Kapitel 4 Test-Werkzeuge und Testsuites<br />

Die beiden hervorgehobenen Punkte, der Entwurf von Testfällen und das Analysieren<br />

der Ergebnisse, sind anspruchsvolle Aufgaben, die in der Regel von einem Menschen<br />

erledigt werden. Sie lassen sich daher nur bedingt automatisieren. Die anderen Punkte<br />

eignen sich dagegen sehr gut für die Automatisierung.<br />

Generell bieten sich Skriptsprachen an, um verschiedene Aufgaben, wie zum Beispiel das<br />

Zusammenfassen von Ergebnissen, zu erledigen. Speziell unter Unix/Linux ist hier der<br />

Einsatz von Werkzeugen wie ”<br />

awk“ , ”<br />

sed“ , ”<br />

diff“ etc. sinnvoll. Das Verwenden eines<br />

Test Management Tools hilft dabei, vor allem die Schritte eines einzelnen Testfalls zu<br />

automatisieren. Darauf wird später in diesem Kapitel noch detailliert eingegangen.<br />

Um das Vorbereiten der Testumgebung zu automatisieren, können zum Beispiel Werkzeuge<br />

zum Klonen von Festplatten einsetzt werden. Mit deren Hilfe kann ein bestimmter<br />

Zustand eines Testsystems ”<br />

eingefroren“ und absolut identisch wiederhergestellt werden.<br />

Eine weitere Möglichkeit ist der Einsatz einer Virtualisierungssoftware. Diese simuliert<br />

einen kompletten Computer und bietet in der Regel ebenfalls Funktionen an, um einen<br />

bestimmten Zustand zu speichern und wiederherzustellen. Mit einer Virtualisierungssoftware<br />

können außerdem Funktionen automatisiert werden, die mit einem realen Computer<br />

manuell erledigt werden müßten. Dazu gehört zum Beispiel das Einschalten eines Computers.<br />

Werden diese Möglichkeiten mit Skripten kombiniert, ist es möglich ein System<br />

auf schnelle und einfache Weise in einen Zustand zu bringen, in dem getestet werden<br />

kann.<br />

Trotz diesen Möglichkeiten muß jedoch klar sein, dass sich eine hunderprozentige Automatisierung<br />

von Tests einerseits nur schwer und mit größtem Aufwand erreichen läßt,<br />

andererseits aber oft auch nicht sinnvoll ist. Automatisierte Tests bergen verschiedene<br />

Probleme in sich (vgl. [Tha02, Seite 230] und [Kan02, Seite 102]):<br />

• Der Aufwand für die Automatisierung ist sehr hoch.<br />

• Es werden nur wenige neue Fehler entdeckt, da diese schon durch die manuellen<br />

Tests gefunden werden.<br />

• Die Wartung der automatischen Tests kann so aufwendig werden, dass ein manueller<br />

Test sinnvoller ist.<br />

• Fehler in Tests können in einer automatisierten Umgebung unbeachtet bleiben.<br />

• Ausführen von veralteten Tests, die zwar in einer älteren Version der Software Sinn<br />

machten, aber in der aktuellen Version nur Ressourcen und Zeit verschlingen.<br />

• Konzentration auf Testfälle, die sich leicht in die automatisierte Testumgebung<br />

einbinden lassen. Die Auswirkung ist eine geringe Testabdeckung.

4.2 Test-Werkzeuge 19<br />

Rob Savoye, Projektleiter und Entwickler des Test-Frameworks DejaGnu, schreibt in<br />

einem Usenet-Artikel:<br />

The higher level code that we used to automate all the testing was never part<br />

”<br />

of DejaGnu, and was pretty heavily customized for our own particular setup.<br />

It worked pretty good, but once we had a few dozen systems, maintaining it<br />

became close to a full-time job.“ [Savc]<br />

Er spricht damit genau die Problematik an, die eine Automatisierung von Tests mit sich<br />

bringen kann. Solange die Testumgebung statisch ist, lassen sich die Testfälle problemlos<br />

ausführen und wiederholen. Sobald sich aber Systeme verändern oder neue Systeme zur<br />

Testumgebung hinzugefügt werden, steigt der Aufwand stark an, um die automatisierten<br />

Tests der neuen Umgebung anzupassen.<br />

Andere Erfahrungen aus der Praxis zeigen jedoch, dass es sich in den meisten Fällen<br />

lohnt, Tests zumindest teilweise zu automatisieren (vgl. [Tha02, Seite 239ff]). Das Ziel<br />

sollte jedoch nicht das Finden von möglichst vielen neuen Fehlern sein, sondern vielmehr<br />

die Abwesenheit von Fehlern zu zeigen. Wie zu Beginn schon erwähnt, macht die Automatisierung<br />

von Tests insbesondere im Zusammenhang mit einem Regressionstest Sinn.<br />

Damit läßt sich dann mit minimalem Aufwand die wichtigsten Funktionalitäten einer<br />

Software überprüfen.<br />

4.2 Test-Werkzeuge<br />

Test-Werkzeuge sind Programme oder Bibliotheken, die bestimmte Funktionalitäten zur<br />

Verfügung stellen, um den Testprozess zu vereinfachen. Viele dieser Werkzeuge sind<br />

auf eine bestimmte Aufgabe spezialisiert. Beispielsweise sind GUI Test Tools darauf<br />

ausgelegt, grafische Benutzerobeflächen zu testen. Unit Test Tools setzen dagegen auf<br />

einer unteren Ebene an und sind für Komponententests geeignet.<br />

Unter [Fau] gibt es eine Übersicht über verschiedene Test Werkzeuge, kategorisiert nach<br />

der Art des Werkzeugs. Speziell für Open Source Werkzeuge gibt es eine Übersicht unter<br />

[Abe].<br />

In der CoreBiz-Testumgebung werden unterschiedliche Arten von Tests ausgeführt. Um<br />

einen Regressionstest für diese verschiedenen Tests zu realisieren, müssen sie ohne großen<br />

Aufwand wiederholt werden können. Daher wird ein so genanntes Test Management Tool<br />

benötigt. Dieses Werkzeug bietet ein Framework, um die Erstellung, das Ausführen und<br />

die Auswertung von unterschiedlichen Testarten in einer homogenen Art und Weise zu<br />

ermöglichen. Außerdem hilf es, einen beachtlichen Teil eines Tests zu automatisieren.

20 Kapitel 4 Test-Werkzeuge und Testsuites<br />

4.2.1 Vergleich von Test Management Tools<br />

Im Folgenden werden einige Test Management Tools untersucht und verglichen. Kriterium<br />

für die Auswahl war primär die Verfügbarkeit der Software unter Linux. Bei der<br />

Recherche nach geeigneter Software zeigte sich, dass es für Linux relativ wenig Software<br />

in diesem Bereich gibt und speziell kommerzielle Software fast überhaupt nicht vorhanden<br />

ist. Im Gegensatz dazu gibt es für Microsoft Windows eine Vielzahl kommerzieller<br />

Test-Werkzeuge. Eine Erklärung dafür könnte die Tatsache sein, dass die überwiegende<br />

Mehrheit an kommerzieller Software unter Windows und für Windows entwickelt wird.<br />

Dagegen wird Software für Linux meistens von Freiwilligen entwickelt, die kein Geld für<br />

Testwerkzeuge ausgeben wollen oder können. Daher macht es für die Anbieter kommerzieller<br />

Test Management Tools wenig Sinn ihre Software für Linux zu entwickeln oder<br />

zu portieren.<br />

Nachfolgend wird auf drei verschiedene Test Management Tools näher eingegangen:<br />

• DejaGnu (vgl. [Sava])<br />

• Software Testing Automation Framework (STAF) (vgl. [STA])<br />

• Test Environment Toolkit (TET) (vgl. [Theb])<br />

DejaGnu<br />

DejaGnu ist das Test-Framework der Free Software Foundation und ist unter der GNU<br />

General Public License erhältlich. Entwickelt wird es maßgeblich von Rob Savoye. Entstanden<br />

ist dieses Projekt durch die Tatsache, dass sein damaliger Arbeitgeber Cygnus<br />

Solutions ein Test-Framework mit folgenden Eigenschaften benötigte (vgl. [Savb]):<br />

• Automatisches ausführen von vielen Tests<br />

• Pattformübergreifend<br />

• Testen von interaktiven Programmen<br />

• Testen von batch-orientierten Programmen<br />

DejaGnu ist in ”<br />

Expect“ entwickelt, welches wiederum ”<br />

Tcl“ benutzt. Weiterhin ist es<br />

speziell darauf ausgelegt, auf so genannten Einplatinenrechnern Tests auszuführen. Diese<br />

haben oft sehr unterschiedliche Kommunikationsschnittstellen. Deshalb unterstützt<br />

DejaGnu rsh, rlogin, telnet, tip, kermit und mondfe für die Kommunikation mit entfernten<br />

Testsystemen.<br />

Zusammen mit TET ist DejaGnu das einzigste Framework, das den POSIX-Standard<br />

1003.3 unterstützt (vgl. [Savb]). Diese Spezifikationen definieren, welche Funktionalitäten<br />

ein Framework aufweisen muß, um POSIX-Konformitätstests durchführen zu<br />

können. Diese Eigenschaften können aber auch für andere Testfälle genutzt werden.

4.2 Test-Werkzeuge 21<br />

Software Testing Automation Framework<br />

Das Software Testing Automation Framework, kurz STAF, wird maßgeblich von IBM<br />

entwickelt und ist unter der Common Public License (CPL) lizenziert. Es wird viel Wert<br />

darauf gelegt, dass es nur minimale Leistungsanforderungen sowohl an die Hardware als<br />

auch an die Software stellt.<br />

Sämtliche Funktionalitäten sind bei STAF in so genannten Services ausgelagert. Neben<br />

einer großen Anzahl von Standard-Services, die beispielsweise das Logging durchführen,<br />

können beliebige weitere Services erstellt werden. Dadurch läßt sich STAF sehr einfach<br />

erweitern.<br />

Interessant ist auch das Konzept der so genannten ”<br />

Trust Levels“ von STAF. Mit ihnen<br />

lassen sich bestimmte Rechte auf den Testsystemen definieren. So kann zum Beispiel<br />

verhindert werden, dass Dateien auf einem bestimmten System gelöscht werden oder das<br />

System heruntergefahren wird. Die Einstellungen können per System oder per Benutzer<br />

durchgeführt werden.<br />

Test Environment Toolkit<br />

Das Test Environment Toolkit, kurz TET, ist ein plattformunabhängiges Test-Framework<br />

von ”<br />

The Open Group“. ”<br />

The Open Group“ ist ein herstellerunabhängiges Konsortium,<br />

dem beispielsweise Unternehmen wie Hewlett-Packard, IBM oder Sun Microsystems angehören.<br />

Dieses Konsortium war unter anderem auch an der Entwicklung der POSIX-<br />

Spezifikationen und des Lightweight Directory Access Protocol beteiligt.<br />

Das Test Environment Toolkit bietet Schnittstellen zu einer Vielzahl von Programmiersprachen<br />

und ist sowohl in einer freien, als auch in einer kommerziellen Version verfügbar.<br />

Ein besonderes Merkmal ist die Möglichkeit verteilte Tests durchzuführen.<br />

Neben der kommerziellen Version ”<br />

TETware“ ist das Test Environment Toolkit in zwei<br />

Varianten unter der ”<br />

Artistic License“ verfügbar. Zum Zeitpunkt des Schreibens dieser<br />

Arbeit wurden folgende Versionen veröffentlicht:<br />

• ”<br />

TET-Lite“ in der Version 3.6<br />

• Ein sogenanntes ”<br />

full source release“, das sowohl ”<br />

TET-Lite“ als auch ”<br />

Distributed<br />

TET“ in der Version 3.3 enthält<br />

Der Unterschied zwischen diesen beiden Versionen besteht im wesentlichen in der Einschränkung,<br />

Remote oder verteilte Tests in der Lite Version durchzuführen.

22 Kapitel 4 Test-Werkzeuge und Testsuites<br />

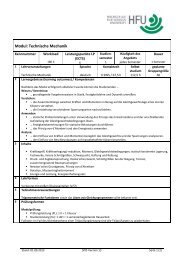

Features STAF Dejagnu TET<br />

Open Source ja ja ja<br />

Lizenz CPL GPL Artistic<br />

Gleiches Front-End für alle Tests ja ja ja<br />

Einheitliches Format für Ergebnisse ja ja ja<br />

Testfälle können X mal wiederholt werden nein nein ja<br />

Testfälle können eine bestimmte Zeit lang wiederholt<br />

nein nein ja<br />

werden<br />

Testfälle können zufällig ausgewählt werden nein nein ja<br />

Remote Tests ja ja ja<br />

Verteilte Tests nein nein ja<br />

Plattformübergreifend ja ja ja<br />

POSIX TM 1003.3 konform nein ja ja<br />

Logging Eigenschaften ja ja ja<br />

Debugging Eigenschaften ja ja ja<br />

Datenbank für Ergebnisse nein nein nein<br />

Dateien über das Netzwerk kopieren ja ja nein<br />

Security Eigenschaften ja nein nein<br />

Rückgabe von komplexen Datenstrukturen (Marshalling)<br />

ja nein nein<br />

Tabelle 4.1: Vergleich von Test Management Tools<br />

Fazit<br />

Die Tabelle 4.1 zeigt einen Überblick über die Features dieser Werkzeuge (vgl [Lin]).<br />

Alle drei Werkzeuge verfügen über die nötigen Funktionen, mit denen es prinzipiell<br />

möglich ist, eine größere Anzahl von Tests, auch auf entfernten Systemen, durchzuführen.<br />

STAF kann besonders durch die einfach erweiterbaren Services beeindrucken, was das<br />

Framework sehr flexibel macht. Die Entscheidung fiel schließlich aber zugunsten des Test<br />

Environment Toolkit aus. Die Gründe dafür waren:<br />

• Verteilte Tests sind möglich.<br />

• Das Framework wird bereits seit September 1989 von ”<br />

The Open Group“ entwickelt<br />

und gilt als sehr stabil und ausgereift.<br />

• Innerhalb des Unternehmens gibt es schon Erfahrungen mit TET.<br />

• Die Testsuites der Linux Standard Base basieren ebenfalls auf TET<br />

Nachfolgend wird noch einmal detailliert auf das Test Environment Toolkit eingegangen.

4.2 Test-Werkzeuge 23<br />

4.2.2 Test Environment Toolkit<br />

Im folgenden werden allgemein die Funktionen und Besonderheiten von Distributed TET<br />

erläutert. Dennoch sollte es abgesehen von der Einschränkung, Remote oder verteilte<br />

Tests durchzuführen, keine wesentlichen Unterschiede zu TET-Lite geben.<br />

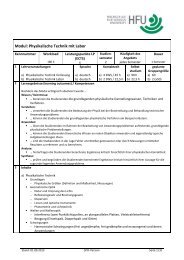

Überblick<br />

Testsystem 1 Testsystem 2<br />

Testsystem 3<br />

Test Case Controller<br />

Test Case<br />

Controller Daemon<br />

Test Case<br />

Controller Daemon<br />

Test Case<br />

Controller Daemon<br />

Test Case<br />

Manager<br />

Test Case<br />

Manager<br />

Test Case<br />

Manager<br />

Abbildung 4.1: Die Komponenten von TET<br />

Ein Test wird immer durch das Programm ”<br />

tcc“, dem Test Case Controller ausgelöst. Es<br />

gibt drei verschiedene Modi: ”<br />

Build“, ”<br />

Execute“ und ”<br />

Clean“. Der Test Case Controller<br />

verteilt diesen Auftrag an den Test Case Controller Daemon ( ”<br />

tccd“) aller beteiligten<br />

Systeme. Der Test Case Manager (TCM) wird implizit durch das Benutzen einer der<br />

TET-APIs eingebunden und kümmert sich um den Ablauf der Test Cases (Testfälle).<br />

Abbildung 4.1 zeigt, wie ein Test in der TET-Umgebung gestartet wird. Interessant<br />

dabei ist, dass nahezu beliebig viele weitere Testsysteme hinzugefügt werden können.<br />

Das System, auf dem der Test Case Controller gestartet wird, muß nicht zwingend den<br />

Test selbst ausführen.<br />

Aufbau eines Testfalls<br />

Ein Test Case besteht aus einem oder mehreren so genannter Invocable Components<br />

(IC). Diese wiederum bestehen aus einem oder mehreren Test Purposes (TP). Abbildung<br />

4.2 zeigt den Aufbau eines Testfalls.

24 Kapitel 4 Test-Werkzeuge und Testsuites<br />

Test Case<br />

Invocable<br />

Component 1<br />

Invocable<br />

Component 2<br />

Test Purpose 1<br />

Test Purpose 2<br />

Test Purpose ...<br />

Test Purpose 1<br />

Test Purpose 2<br />

Test Purpose ...<br />

Abbildung 4.2: Aufbau eines Testfalls im TET<br />

Direktiven<br />

Neben dem simplen Ausführen eines Tests bietet das Test Environment Toolkit so genannte<br />

Direktiven an. Teilweise können diese miteinander kombiniert werden. So ist es<br />

zum Beispiel möglich einen zufällig ausgewählten Test auf einem bestimmten entfernten<br />

System genau acht mal zu wiederholen. In der Konfigurationsdatei ”<br />

tet scen“ werden<br />

diese Direktiven zusammen mit den Testfällen aufgelistet. Die wichtigsten Direktiven<br />

sind:<br />

• :repeat: - Einen Test eine bestimmte Anzahl lang wiederholen<br />

• :timed loop: - Einen Test eine bestimmte Zeit lang wiederholen<br />

• :random: - Einen zufälligen Test ausführen<br />

• :parallel: - Tests parallel (gleichzeitig) ausführen<br />

• :remote: - Tests auf entfernten Systemen durchführen<br />

• :distributed: - Verteilte Tests auf entfernten Systemen durchführen<br />

Die Direktiven :remote: und :distributed: benötigen als Parameter eine dreistellige System<br />

ID. Jedem System auf dem Tests ausgeführt werden können, ist solch eine ID zuge-

4.2 Test-Werkzeuge 25<br />

wiesen. Der Test Case Controller kann diese ID dann mit Hilfe der Konfigurationsdatei<br />

systems“ zu einer entsprechenden IP-Adresse eines Testsystems auflösen.<br />

”<br />

Die nachfolgende Szenario-Datei beschreibt einen verteilten Test, der auf zwei Testsystemen<br />

(001 und 002) ausgeführt wird.<br />

all<br />

"starting LDAP tests"<br />

:distributed,001,002:<br />

:repeat,1000:@/ldap-latenz/ldap-latenz<br />

:/ldap-performance/ldap-performance<br />

:timed_loop,3600:@/ldap-konflikt/ldap-konflikt<br />

:enddistributed:<br />

"LDAP tests finished"<br />

Das Journal<br />

Nachdem ein Testfall abgeschlossen ist, werden die Ergebnisse in der Datei ”<br />

journal“<br />

abgespeichert. Diese Datei ist unabhängig vom Test immer gleichartig aufgebaut und<br />

kann dadurch einfach, zum Beispiel durch Skripte, weiter bearbeitet werden. Nachfolgend<br />

ein kleiner Ausschnitt eines Journals:<br />

10|4 /ldap-latenz/ldap-latenz 16:48:17|TC Start, scenario ref 5-1<br />

15|4 3.3 1|TCM Start<br />

400|4 1 1 16:48:17|IC Start<br />

200|4 1 16:48:17|TP Start<br />

520|4 1 00226816 1 1|sync 1 OK (client)<br />

520|4 1 00128614 1 2|sync 1 OK (base)<br />

520|4 1 00226816 1 4|delay = 7055 microseconds = 7 milliseconds<br />

220|4 1 0 16:48:17|PASS<br />

410|4 1 1 16:48:17|IC End<br />

80|4 0 16:48:18|TC End, scenario ref 5-1<br />

Die Zeilen, die beispielsweise mit 520 beginnen, sind Meldungen, die die Test Purposes<br />

auf den verschiedenen Systemen selbst ausgeben können. Die Nummer 220 bedeutet<br />

dagegen, dass diese Zeile das Ergebnis des Test Purpose enthält. Es kann also jede Zeile<br />

auf einfache Weise interpretiert werden. Eine ausführliche Beschreibung des Aufbaus<br />

eines Journals können in der TETware User Guide beziehungsweise in der TETware<br />

Programmers Guide gefunden werden (vgl. [Thed] und [Thec]).

26 Kapitel 4 Test-Werkzeuge und Testsuites<br />

4.3 Testsuites<br />

Eine Testsuite ist eine Sammlung von Testfällen. Es ist möglich, dass die einzelnen<br />

Tesfälle einer Testsuite aufeinander aufbauen. Obwohl eine Testsuite immer aus einzelnen<br />

Tesfällen besteht, kann diese dann nur im Verbund ausführt werden. Diese Abhängigkeit<br />

sollte aber so weit wie möglich verhindert werden, um jeden Testfall auch individuell<br />

ausführen zu können (vgl. [Rät04, Site 193]).<br />

Nachfolgend werden die Testsuites der Linux Standard Base und die für CoreBiz geplanten<br />

Testsuites vorgestellt.<br />

4.3.1 Linux Standard Base Testsuites<br />

Das Linux Standard Base Project (vgl. [Frec]) definiert verschiedene Spezifikationen<br />

mit dem Ziel, die verschiedenen Linux Distributionen hinsichtlich der Dateisystemstruktur<br />

und der Basisbibliotheken zu vereinheitlichen, um eine zu starke Zersplitterung<br />

zu vermeiden. Die Spezifikationen beinhalten teilweise auch POSIX-Spezifikationen.<br />

Um diese Spezifikationen zu überprüfen, stellt das Projekt folgende Testsuites frei zur<br />

Verfügung:<br />

• Filesystem Hierarchy Specification Tests<br />

• POSIX.1 Conformance Tests<br />

• POSIX thread (pthread) Conformance Tests<br />

• Linux Operating System Calls Test<br />

Die Tests bauen auf das Framework VSXgen auf, welches wiederum auf TET-Lite basiert.<br />

VSXgen ist ein Framework, das Betriebssystemfunktionen abstrahiert und in verschiedenen<br />

Bibliotheken zur Verfügung stellt. 97% dieser Tests wurden von ”<br />

The Open Group“<br />

entwickelt (vgl. [Thea]). Das ist damit zu erklären, dass ”<br />

The Open Group“ schon sehr<br />

lang Testsuites für die POSIX Konformität anbietet. Diese Testsuites waren ehemals<br />

nur gegen sehr teure Lizenzgebühren erhältlich. Heute werden sie aber unter einer freien<br />

Lizenz zur Verfügung gestellt.<br />

4.3.2 CoreBiz Testsuites<br />

Eine kleinere Testsuite mit verschiedenen lokalen Tests existiert bereits. Diese wurden<br />

wie die Tests der LSB mit Hilfe von TET-Lite entwickelt.<br />

Geplant ist eine weitere Testsuite, die mit Hilfe von Distributed TET auf beliebig vielen<br />

entfernten Testsystemen ausführbar ist. Es ist denkbar, dass diese Testsuite die bereits<br />

existierende Testsuite integriert. Interessant ist die Frage, ob es eine Möglichkeit gibt,

4.4 Zusammenfassung 27<br />

auch die LSB Testsuites zu integrieren. Dieser Ansatz wird im Kapitel ”<br />

CoreBiz Testsuite<br />

- Remote Tests“ diskutiert.<br />

Speziell für die verteilten Tests wird eine weitere Testsuite erstellt. Diese enthält Testfälle,<br />

die in der Regel auf zwei Systemen, einem CoreBiz Base Server und einem CoreBiz Client<br />

ablaufen. Im Kapitel ”<br />

CoreBiz Testsuite - Verteilte Tests“ wird detailliert auf dieses<br />

Thema eingegangen.<br />

4.4 Zusammenfassung<br />

In diesem Kapitel wurde auf Möglichkeiten der Automatisierung von Tests eingegangen.<br />

Das führt zu der Erkenntnis, dass Testwerkzeuge benötigt werden, um dies realisieren<br />

zu können. Testwerkzeuge bieten aber noch eine ganze Reihe weiterer Vorteile, wie zum<br />

Beispiel die einheitliche Darstellung von Testergebnissen. Für die CoreBiz-Testumgebung<br />

werden für die Regressionstests einerseits Werkzeuge für die Automatisierung benötigt,<br />

andererseits aber vor allem ein Test Management Tool, um verschiedenste Tests in einem<br />

homogenen Rahmen durchzuführen. Dafür wurde das Test Environment Toolkit gewählt,<br />

welches sich vor allem durch die Möglichkeit verteilte Tests durchzuführen von anderen<br />

Frameworks hervorhebt.

28 Kapitel 4 Test-Werkzeuge und Testsuites

Kapitel 5<br />

CoreBiz Testsuite - Remote Tests<br />

In diesem Kapitel wird auf die Implementierung des Test-Frameworks eingegangen. Es<br />

wird diskutiert, ob und wie die schon vorhandenen Tests der Linux Information Systems<br />

AG und die Testsuites der Linux Standard Base integriert werden können. Weiterhin wird<br />

der Aufbau einer Testumgebung erläutert, die es erlaubt Remote Tests auszuführen. Die<br />

prototypische Implementierung eines Testfalls veranschaulicht die Thematik.<br />

5.1 Ausgangssituation<br />

Für die Qualitätssicherung von CoreBiz wurden bisher die Testsuites der Linux Standard<br />

Base eingesetzt. Diese Tests basieren auf den Frameworks TET-Lite und VSXgen.<br />

Zusätzlich sind selbst entwickelte Tests vorhanden, die allerdings wie die Testsuites der<br />

LSB nur lokal auf einem Testsystem ausgeführt wurden. Diese Tests sind ebenfalls mit<br />

Hilfe von TET-Lite implementiert.<br />

5.2 Aufbau der Testumgebung<br />

Nachfolgend werden die Komponenten vorgestellt, die für den Aufbau der Testumgebung<br />

benötigt werden.<br />

5.2.1 TET-Lite vs. Distributed TET<br />

Für das Design der Testumgebung mit Hilfe des Test Environment Toolkits können im<br />

Prinzip zwei Möglichkeiten in Erwägung gezogen werden. Damit verknüpft ist allerdings<br />

auch die Frage, ob und wie die bisherigen CoreBiz-spezifischen Testfälle und die Testsuites<br />

der LSB integriert werden können. Hier muß sich noch einmal klar gemacht werden,<br />

dass mit TET-Lite ausschließlich lokale Tests möglich sind. Distributed TET dagegen<br />

erlaubt das Ausführen von Remote Tests und verteilten Tests.<br />

29

30 Kapitel 5 CoreBiz Testsuite - Remote Tests<br />

Die erste Variante würde die Erweiterung der bisherigen Testsuite bedeuten. Testfälle<br />

würden also mit Hilfe des Frameworks TET-Lite und optional VSXgen implementiert<br />

werden. Das hätte den Vorteil, dass diese Testsuite und die Testsuites der LSB sich in der<br />

gleichen Testumgebung ausführen lassen würden. Es müßte also die bisherige Testumgebung<br />

nicht verändert werden. Der Nachteil ist allerdings, dass so auf die Möglichkeiten<br />

von Distributed TET verzichtet wird. Um Tests auf entfernten Systemen durchführen<br />

zu können, müßte ein weiteres Framework entwickelt werden. Beispielsweise wäre vorstellbar,<br />

dass Tests mit Hilfe von ssh (Secure Shell) gestartet werden und die Ergebnisse<br />

mittels scp (Secure Copy) oder NFS (Network File System) an eine zentrale Stelle kopiert<br />

werden.<br />

Die zweite Variante, die schließlich auch implementiert wurde, setzt dagegen auf Distributed<br />

TET auf. Der größte Vorteil ist sicherlich, dass damit ein Framework zur<br />

Verfügung steht, dass Tests auf beliebig vielen entfernten Systemen grundsätzlich zuläßt.<br />

Weiterhin ist so auch gewährleistet, dass verteilte Tests in dieser Umgebung implementiert<br />

werden können. Allerdings muß hier die Frage gestellt werden, ob und wie die schon<br />

vorhandenen Testsuites in die neue Umgebung integriert werden können.<br />

Als problematisch stellt sich dabei das Framework VSXgen heraus, welches nur für TET-<br />

Lite verfügbar ist. Für die CoreBiz-spezifische Testfälle ist das nicht von Bedeutung,<br />

da die Funktionalitäten dieses Frameworks bisher nicht genutzt wurden. Da VSXgen<br />

hauptsächlich grundlegende Betriebssystemfunktionen in einer abstrahierten Form zur<br />

Verfügung stellt, ist es im Hinblick auf die Zukunft eher unwahrscheinlich, dass diese<br />

Funktionen von Testfällen aus den CoreBiz Testsuites benötigt werden.<br />

Die Testsuites der LSB sind jedoch ohne VSXgen nicht ausführbar. Für die Integration<br />

der LSB-Testsuites wäre also die Portierung dieses Frameworks auf Distributed TET<br />

nötig. Das wäre zwar mit etwas Aufwand durchaus möglich, dennoch ist dieser Schritt<br />

und der damit verbundene Aufwand nicht unbedingt notwendig. Die Testsuites der LSB<br />

haben ein ganz anderes Ziel als die CoreBiz Testsuites. Mit ihnen werden keine neuen<br />

Fehler in Produkten gefunden. Es kann damit aber gezeigt werden, dass CoreBiz-Systeme<br />

gewisse Standards und Spezifikationen einhalten. Während es bei CoreBiz-spezifischen<br />

Tests je nach Testart Sinn macht, diese möglichst oft und regelmäßig durchzuführen, ist<br />

es bei den Tests der LSB ausreichend, diese zum Beispiel vor einem neuen Release durchzuführen.<br />

Sie werden also nicht direkt für die Produktentwicklung benötigt und müssen<br />

deshalb auch nicht so häufig ausgeführt werden. Weiterhin werden die Testsuites der<br />

LSB nicht von der Linux Information Systems AG entwickelt. Es darf daher nicht davon<br />

ausgegangen werden, dass zukünftige Versionen der Testsuites kompatibel zur jetzigen<br />

Testumgebung sind. Von diesen Gesichtspunkten aus betrachtet, ist es vertretbar und<br />

sinnvoll, die LSB und CoreBiz Testsuites weitestgehend unabhängig voneinander auszuführen.<br />

Im Vordergrund sollten die Anforderungen für die CoreBiz Testsuites stehen<br />

und das Framework sollte maßgeblich danach ausgerichtet sein.

5.2 Aufbau der Testumgebung 31<br />

5.2.2 Virtualisierungssoftware<br />

Basis der Testumgebung ist der CoreBiz Factory Server. Auf diesem System werden dann<br />

mit Hilfe der Software ”<br />

VMware Workstation“ ein oder mehrere Testsysteme ”<br />

virtuell“<br />

aufgesetzt. Dieser Ansatz bringt verschiedene Vorteile mit sich:<br />

• Es muß keine weitere Hardware für Testssysteme angeschafft werden<br />

• Es können beliebig viele weitere Systeme hinzugefügt werden<br />

• Mit Hilfe so genannter Snapshots kann ein bestimmter Zustand eines Systems<br />

eingefroren werden<br />

• Systeme können schnell und einfach dupliziert werden<br />

• Verschiedene Aktionen wie zum Beispiel das Einschalten eines Rechners, die normalerweise<br />

manuell durchgeführt werden müßten, können automatisiert werden.<br />

Abbildung 5.1 zeigt den Aufbau einer Testumgebung für Remote Tests, die mit Hilfe<br />

von VMware und Distributed TET realisiert wurde. Die Testumgebung ist im Prinzip<br />

frei skalierbar. Eine Einschränkung setzen nur die TET System IDs, die von 000 bis<br />

999 vergeben werden können und natürlich die Leistungsfähigkeit der Hardware, auf der<br />

VMware installiert ist.<br />

CoreBiz Factory<br />

Test Case<br />

Control Daemon<br />

VMware<br />

LAN<br />

Test Case<br />

Control Daemon<br />

Test Case<br />

Control Daemon<br />

Test Case<br />

Control Daemon<br />

Testsystem 1<br />

(Bsp.: CoreBiz Base)<br />

Testsystem 2, optional<br />

(Bsp.: CoreBiz Client)<br />

Weitere Testsysteme,<br />

optional<br />

Abbildung 5.1: Aufbau der CoreBiz Testumgebung für Remote Tests

32 Kapitel 5 CoreBiz Testsuite - Remote Tests<br />

Eine Virtualisierungssoftware bringt allerdings auch Probleme mit sich. Auf diese wird im<br />

Zusammenhang mit verteilten Tests im nächsten Kapitel noch detailliert eingegangen.<br />

5.2.3 Konfiguration der Systeme<br />

Das Test Environment Toolkit installiert sich standardmäßig in das Verzeichnis<br />

/home/tet. Da bei einem CoreBiz System die Benutzerverzeichnisse in der Regel per<br />

NFS über das Netzwerk bezogen werden, würde das zu Problemen führen. Damit sichergestellt<br />

werden kann, dass sich TET auf einer lokalen Festplatte befindet, wird es in<br />

das Verzeichnis /opt/tet-full installiert. Dazu wurde ein entsprechendes Debian-Paket<br />

erstellt, das neben den Programmen und den Bibliotheken von TET außerdem ein Startskript<br />

für den Test Case Controller Daemon enthält. Bei der Installation dieses Pakets<br />

werden automatisch der Benutzer und die Gruppe ”<br />

tet“ angelegt. Um das Test Environment<br />

Toolkit einsetzen zu können, muß nur noch die Datei ”<br />

systems.equiv“ auf<br />

dem Testsystem beziehungsweise die Datei ”<br />

systems“ auf dem CoreBiz Factory Server<br />

angepaßt werden.<br />

Für jede Testsuite gibt es ebenfalls ein eigenes Debian-Paket. Dieses installiert die zugehörigen<br />

Testfälle unterhalb des Verzeichnisses /opt/tests//.<br />

Da es bestimmte Tests geben kann, die nicht auf allen CoreBiz Systemen ausgeführt<br />

werden können, ist es notwendig, innerhalb der Testumgebung standardisierte TET-ID-<br />

Nummern zu vergeben. Dann kann die Szenario-Datei schon beim Erstellen des Tests<br />

entsprechend konfiguriert werden, so dass der Test nur auf bestimmten Systemen gestartet<br />

wird. Wichtig wird dieser Punkt auch im Hinblick auf verteilte Tests.<br />

ID CoreBiz System<br />

000 CoreBiz Factory<br />

001 CoreBiz Base<br />

002 CoreBiz Client<br />

003<br />

bis<br />

009 CoreBiz Backup)<br />

ab<br />

010<br />

reserviert für bestimmte<br />

CoreBiz Systeme (Beispiel:<br />

für beliebig weitere Testsysteme<br />

nutzbar<br />

Tabelle 5.1: Zuweisung von TET-IDs zu CoreBiz Systemen<br />

Tabelle 5.1 zeigt die Zuweisung von IDs zu den jeweiligen CoreBiz Systemen. ID 000 ist<br />

immer für den CoreBiz Factory Server reserviert, von dem aus sämtliche Tests gestartet<br />

werden, auf dem selbst aber in der Regel keine Tests ablaufen. ID 001 und 002 werden<br />

für den CoreBiz Base Server beziehungsweise den CoreBiz Client reserviert. Die IDs<br />

003 bis 009 werden vorerst für Systeme wie zum Beispiel dem CoreBiz Backup Server

5.3 Ablauf eines Testfalls 33<br />

reserviert, für die zur Zeit aber noch keine speziellen Testfälle existieren. Alle weiteren<br />

IDs können beliebig für zusätzliche Testsysteme benutzt werden.<br />

Ein weiteres Problem ist die Notwendigkeit bestimmte Programme mir root-Rechten<br />

auszuführen. Der Test Case Control Daemon und damit auch die Tests werden aber<br />

standardmäßig als Benutzer ”<br />

tet“ ausgeführt. Das Problem kann am einfachsten mit<br />

Hilfe des Programms ”<br />

sudo“ gelöst werden. Durch den Eintrag der Zeile<br />

tet ALL = NOPASSWD: ALL<br />

in /etc/sudoers können alle Programme als Benutzer root ausgeführt werden.<br />

5.3 Ablauf eines Testfalls<br />

Der Testprozess läßt sich in drei Phasen beschreiben:<br />

• Phase 1 - Installation:<br />

Die Testsysteme werden weitestgehend automatisch über das Netzwerk installiert.<br />

In der Regel wird ein CoreBiz Base Server und ein CoreBiz Client als Testsystem<br />

dienen, aber es können natürlich prinzipiell alle CoreBiz Systeme verwendet werden.<br />

Dannach muß TET und die CoreBiz Testsuite installiert werden und unter<br />

Umständen die Konfiguration von TET angepaßt werden. Dieser Schritt kann in<br />

Zukunft sicherlich auch relativ einfach automatisiert werden. Aus den verschiedenen<br />

CoreBiz Profilen könnte jeweils ein entsprechendes Testprofil generiert werden,<br />

das eine zusätzliche Komponente mit TET, den CoreBiz Testsuites und eventuell<br />

sogar eine passende Konfiguration enthält.<br />

• Phase 2 - Testing:<br />

Nach der Installation sollte auf allen Testsystemen der Test Case Controller Daemon<br />

aktiv sein. Nun kann festgelegt werden, auf welchen Testsystemen überhaupt getestet<br />

werden soll beziehungsweise welche Testfälle auf den verschiedenen Testsystemen<br />

ausgeführt werden sollen. Dazu kann die Szenario-Datei angepaßt werden.<br />

Standardmäßig wird die vollständige Testsuite ausgeführt. Die Testfälle werden<br />

dann vom CoreBiz Factory Server aus mit Hilfe des Test Case Controllers gestartet.<br />

Die Tests selbst werden automatisch ausgeführt und die Ergebnisse zentral<br />

auf dem Server abgelegt.<br />

• Phase 3 - Reporting:<br />

Für die Auswertung der Journale kann beispielsweise das Perl-Skript ”<br />

tetreport.pl“<br />

benutzt werden, das von TET mitgeliefert wird. Dieses Skript erstellt einen kurzen<br />

Report über die erfolgreichen und fehlgeschlagenen Testfälle. Für bestimmte Tests,<br />

etwa einen Performance Test, muß das Journal aber weitergehend ausgewertet<br />

werden. Es müssen zum Beispiel bestimmte Werte extrahiert und Berechnungen

34 Kapitel 5 CoreBiz Testsuite - Remote Tests<br />

durchgeführt werden. Das kann in der Regel durch kleine SHELL-Skripte erledigt<br />

werden.<br />

5.4 Testarten<br />

Nachfolgend wird erläutert, wie verschiedene Testarten in dieser Umgebung realisiert<br />

werden können. Die theoretischen Hintergründe dazu sind im Kapitel ”<br />

Softwaretest“<br />

unter Punkt 3.2.1 zu finden.<br />

Remote Tests unterscheiden sich prinzipiell nicht von lokalen Tests. Zu Remote Tests<br />

werden sie allein durch das Benutzen der Direktive ”<br />

:remote:“ (vgl. 4.2.2). Die Tests<br />

selbst enthalten also keinen Quellcode, der darauf hinweist, dass die Tests auf entfernten<br />

Systemen ausgeführt werden können. Alle Testfälle sollten daher auch problemlos lokal<br />

ausgeführt werden können. Selbst das Verwenden von TET-Lite anstatt Distributed<br />

TET sollte möglich sein.<br />

5.4.1 Verifikation von Konfigurationen<br />

Diese Tests haben das Ziel, bestimmte Konfigurationsdateien zu verifizieren. Dabei geht<br />

es speziell um solche Konfigurationsdateien, die von den cfengine-Skripten verändert<br />

werden. Es wurden schon einige Tests dieser Art in der bisherigen Testumgebung unter<br />

Verwendung von TET-Lite erstellt. Der Aufwand für das Portieren der Tests sollte relativ<br />

gering sein, da Distributed TET alle Funktionalitäten von TET-Lite besitzt.<br />

Bei dieser Art von Testfall wird zuerst cfengine mit der Standardumgebung ausgeführt,<br />

um sicherzustellen, dass das System keinen undefinierten Zustand hat. Die entsprechenden<br />