ÐÐ ÐÐЦÐÐ ÐÐ ÐÐÐÐЬÐЫХ ÐÐÐÐЩÐÐÐÐ: меÑодологиÑ, задаÑи ...

ÐÐ ÐÐЦÐÐ ÐÐ ÐÐÐÐЬÐЫХ ÐÐÐÐЩÐÐÐÐ: меÑодологиÑ, задаÑи ...

ÐÐ ÐÐЦÐÐ ÐÐ ÐÐÐÐЬÐЫХ ÐÐÐÐЩÐÐÐÐ: меÑодологиÑ, задаÑи ...

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

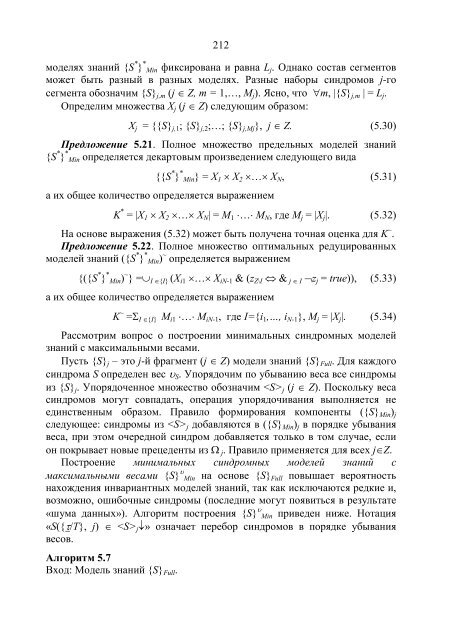

212<br />

моделях знаний {S * } * Min фиксирована и равна L j . Однако состав сегментов<br />

может быть разный в разных моделях. Разные наборы синдромов j-го<br />

сегмента обозначим {S} j,m (j ∈ Z, m = 1,…, M j ). Ясно, что ∀m, |{S} j,m | = L j .<br />

Определим множества X j (j ∈ Z) следующим образом:<br />

X j = {{S} j,1 ; {S} j,2 ;…; {S} j,Mj }, j ∈ Z. (5.30)<br />

Предложение 5.21. Полное множество предельных моделей знаний<br />

{S * } * Min определяется декартовым произведением следующего вида<br />

{{S * } * Min} = X 1 × X 2 ×…× X N , (5.31)<br />

а их общее количество определяется выражением<br />

K * = |X 1 × X 2 ×…× X N | = M 1 ⋅…⋅ M N , где M j = |X j |. (5.32)<br />

На основе выражения (5.32) может быть получена точная оценка для K ~ .<br />

Предложение 5.22. Полное множество оптимальных редуцированных<br />

моделей знаний ({S * } * Min) ~ определяется выражением<br />

{({S * } * Min) ~ } =∪ I ∈{I} (X i1 ×…× X iN-1 & (z Z\I ⇔ & j ∈ I ¬z j = true)), (5.33)<br />

а их общее количество определяется выражением<br />

K ~ =Σ I ∈{I} M i1 ⋅…⋅ M iN-1 , где I={i 1 ,…, i N-1 }, M j = |X j |. (5.34)<br />

Рассмотрим вопрос о построении минимальных синдромных моделей<br />

знаний с максимальными весами.<br />

Пусть {S} j – это j-й фрагмент (j ∈ Z) модели знаний {S} Full . Для каждого<br />

синдрома S определен вес υ S . Упорядочим по убыванию веса все синдромы<br />

из {S} j . Упорядоченное множество обозначим j (j ∈ Z). Поскольку веса<br />

синдромов могут совпадать, операция упорядочивания выполняется не<br />

единственным образом. Правило формирования компоненты ({S} Min ) j<br />

следующее: синдромы из j добавляются в ({S} Min ) j в порядке убывания<br />

веса, при этом очередной синдром добавляется только в том случае, если<br />

он покрывает новые прецеденты из Ω j. Правило применяется для всех j∈Z.<br />

Построение минимальных синдромных моделей знаний с<br />

максимальными весами {S} υ Min на основе {S} Full повышает вероятность<br />

нахождения инвариантных моделей знаний, так как исключаются редкие и,<br />

возможно, ошибочные синдромы (последние могут появиться в результате<br />

«шума данных»). Алгоритм построения {S} υ Min приведен ниже. Нотация<br />

«S({τ/T}, j) ∈ j ↓» означает перебор синдромов в порядке убывания<br />

весов.<br />

Алгоритм 5.7<br />

Вход: Модель знаний {S} Full .